Speechify kündigt die frühe Einführung von SIMBA 3.0 an – der neuesten Generation seiner produktiven Voice-AI-Modelle. SIMBA 3.0 steht ausgewählten Drittentwicklern über die Speechify Voice API zur Verfügung. Die vollständige allgemeine Verfügbarkeit ist für März 2026 vorgesehen. Entwickelt im Speechify AI Research Lab, bietet SIMBA 3.0 hochwertige text vorlesen lassen-, Speech-to-Text- und Speech-to-Speech-Funktionen, die Entwickler direkt in ihre eigenen Produkte und Plattformen integrieren können.

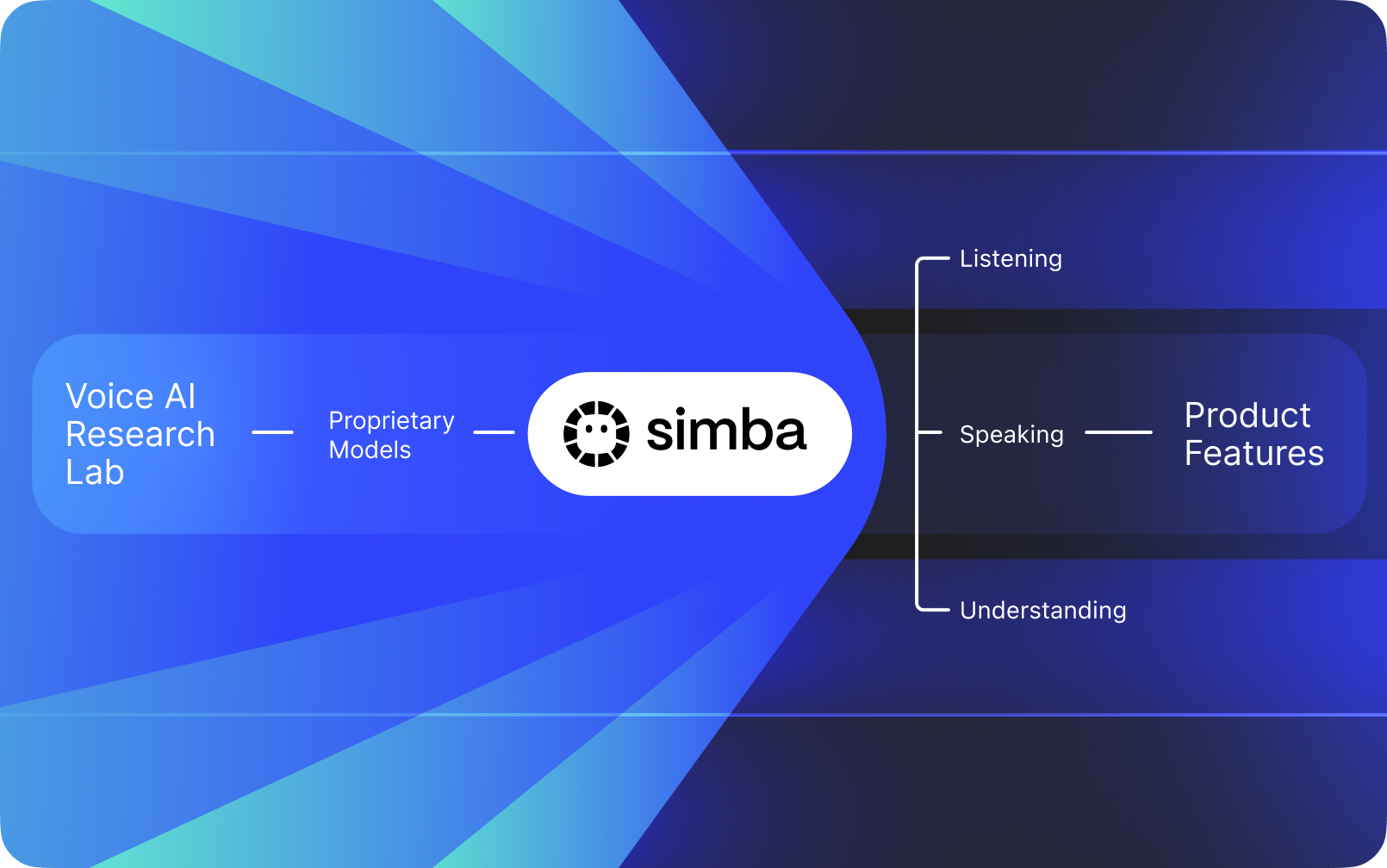

Speechify ist keine Voice-Schnittstelle, die auf anderen AI-Anbietern aufbaut. Das Unternehmen betreibt ein eigenes Forschungslabor zur Entwicklung proprietärer Sprachmodelle. Diese Modelle werden Drittentwicklern und Unternehmen über die Speechify API angeboten und können in jede Anwendung integriert werden – von KI-Rezeptionisten und Kundenservice-Bots bis hin zu Content-Plattformen und Barrierefreiheits-Tools.

Speechify nutzt diese Modelle auch zur Unterstützung eigener Endnutzerprodukte und stellt Entwicklern weiterhin Zugriff über die Speechify Voice API bereit. Das ist wichtig, weil Qualität, Latenz, Kosten und die langfristige Weiterentwicklung der Sprachmodelle unter der Kontrolle des eigenen Forschungsteams stehen und nicht von externen Anbietern abhängen.

Speechifys Sprachmodelle sind speziell für produktive Voice-Aufgaben geschaffen und bieten erstklassige Modellqualität im großen Maßstab. Drittentwickler erhalten direkten Zugriff auf SIMBA 3.0 und andere Speechify-Modelle über die Speechify Voice API – mit produktiven REST-Endpunkten, vollständiger API-Dokumentation, Quickstart-Guides für Entwickler und offiziell unterstützten SDKs für Python und TypeScript. Die Entwicklerplattform von Speechify ist für schnelle Integration, produktiven Einsatz und skalierbare Voice-Infrastruktur konzipiert und ermöglicht Teams einen schnellen Übergang vom ersten API-Aufruf zu Live-Voice-Features.

Dieser Artikel erklärt, was SIMBA 3.0 ist, was das Speechify AI Research Lab entwickelt und warum Speechify erstklassige Modellqualität für Voice-AI, geringe Latenz und starke Kosteneffizienz bei produktiven Developer-Workloads liefert. Damit etabliert sich Speechify als führender Anbieter für Voice-AI und übertrifft andere Anbieter von Sprach- und multimodaler KI wie OpenAI, Gemini, Anthropic, ElevenLabs, Cartesia und Deepgram.

Was bedeutet es, Speechify als AI-Forschungslabor zu bezeichnen?

Ein Künstliche-Intelligenz-Labor ist eine spezialisierte Forschungs- und Entwicklungsorganisation, in der Experten aus Machine Learning, Data Science und Computermodellierung zusammenarbeiten, um fortschrittliche intelligente Systeme zu entwerfen, zu trainieren und bereitzustellen. Wenn von einem „AI Research Lab“ die Rede ist, sind meist Organisationen gemeint, die zwei Dinge gleichzeitig tun:

1. Eigene Modelle entwickeln und trainieren

2. Diese Modelle Entwicklern über produktive APIs und SDKs zur Verfügung stellen

Einige Organisationen sind hervorragend bei der Modellentwicklung, machen sie aber nicht Drittentwicklern zugänglich. Andere bieten APIs, verlassen sich aber größtenteils auf Drittmodelle. Speechify betreibt einen vertikal integrierten Voice-AI-Stack: Das Unternehmen entwickelt eigene Sprach-KI-Modelle und stellt diese externen Entwicklern über produktive APIs bereit – und nutzt sie zudem in den eigenen Endnutzeranwendungen, um die Modellleistung im großen Maßstab zu validieren.

Das Speechify AI Research Lab ist eine interne Organisation mit Forschungsschwerpunkt auf Voice Intelligence. Die Mission ist es, text vorlesen lassen, automatische Spracherkennung und Sprach-zu-Sprache-Systeme weiterzuentwickeln, damit Entwickler sprachbasierte Anwendungen für jeden Anwendungsfall bauen können – von KI-Rezeptionisten und Sprachagenten über Vorlesemodule bis hin zu Barrierefreiheits-Tools.

Ein echtes Voice-AI-Forschungslabor muss in der Regel die folgenden Herausforderungen lösen:

• Text vorlesen lassen – Qualität und Natürlichkeit für produktive Einsätze

• Speech-to-Text- und ASR-Genauigkeit über Akzente und Geräuschbedingungen hinweg

• Echtzeit-Latenz für natürliche Gesprächsführung durch KI-Agenten

• Stabilität bei langen Hörsessions

• Dokumentenverständnis für die Verarbeitung von PDFs, Webseiten und strukturierten Inhalten

• OCR und Seitenanalyse für gescannte Dokumente und Bilder

• Eine Produkt-Feedbackschleife zur kontinuierlichen Verbesserung der Modelle

• Entwickler-Infrastruktur, die Sprachfunktionen über APIs und SDKs zugänglich macht

Speechify's AI Research Lab entwickelt diese Systeme als einheitliche Architektur und stellt sie für Entwickler über die Speechify Voice API bereit, die für die Integration in Drittprodukte und -plattformen verfügbar ist.

Was ist SIMBA 3.0?

SIMBA ist Speechifys eigene Modellfamilie für Voice-AI, die sowohl eigene Produkte von Speechify antreibt als auch an Drittentwickler über die Speechify API verkauft wird. SIMBA 3.0 ist die neueste Generation, optimiert für Voice-First-Leistung, Geschwindigkeit und Echtzeit-Interaktion und bereit zur Integration in Drittplattformen.

SIMBA 3.0 ist darauf ausgelegt, hochwertige Sprachqualität, geringe Latenz und Stabilität bei langem Zuhören im produktiven Maßstab zu liefern. Entwickler können damit professionelle Voice-Anwendungen branchenübergreifend umsetzen.

SIMBA 3.0 erschließt Drittentwicklern Anwendungsbereiche wie:

• KI-Sprachagenten und Conversational-AI-Systeme

• Automatisierten Kundenservice und KI-Rezeptionisten

• Outbound-Telefoniesysteme für Vertrieb und Service

• Sprachassistenten und Speech-to-Speech-Anwendungen

• Content-Narration und Plattformen zur Hörbuch-Erstellung

• Barrierefreiheits-Tools und unterstützende Technologien

• Bildungsplattformen mit sprachbasiertem Lernen

• Gesundheitsanwendungen mit einfühlsamer Sprachinteraktion

• Mehrsprachige Übersetzungs- und Kommunikations-Apps

• Sprachgesteuerte IoT- und Automotive-Systeme

Wenn Nutzer sagen, eine Stimme „klingt menschlich“, meinen sie damit, dass mehrere technische Elemente zusammenspielen:

- Prosodie (Rhythmus, Tonhöhe, Betonung)

- Sinnverstehendes Sprechtempo

- Natürliche Pausen

- Stabile Aussprache

- Intonationswechsel entsprechend der Syntax

- Emotionale Neutralität, wenn passend

- Ausdrucksstärke, wenn hilfreich

SIMBA 3.0 ist die Modellschicht, die Entwicklern ermöglicht, natürliche Spracherlebnisse mit hoher Geschwindigkeit, über lange Nutzungssitzungen und für viele Inhaltstypen zu schaffen. Für produktive Voice-Workloads – von KI-Telefonsystemen bis hin zu Content-Plattformen – ist SIMBA 3.0 darauf optimiert, allgemeine Voice-Layer zu übertreffen.

Wie nutzt Speechify SSML für präzise Steuerung der Sprachsynthese?

Speechify unterstützt die Speech Synthesis Markup Language (SSML), damit Entwickler präzise steuern können, wie synthetische Sprache klingt. Mit SSML lassen sich Tonhöhe, Sprechrate, Pausen, Betonung und Stil durch <speak>-Tags und unterstützte SSML-Tags wie prosody, break, emphasis und substitution verändern. Teams erhalten dadurch feine Steuerungsmöglichkeiten für Ausdruck und Struktur – die Sprachausgabe passt sich besser an Kontext, Formatierung und Absicht an.

Wie ermöglicht Speechify Echtzeit-Audiostreaming?

Speechify stellt einen Streaming-Text-to-Speech-Endpunkt bereit, der Audiodaten bereits während der Generierung in Teilstücken liefert. Dadurch kann die Wiedergabe sofort beginnen, anstatt auf die vollständige Audioproduktion zu warten. Dies unterstützt Anwendungsfälle mit langen Inhalten und niedriger Latenz, wie Sprachagenten, Assistenztechnologien, automatische Podcast- oder Hörbuchproduktion. Entwickler können große Eingabemengen jenseits der üblichen Grenzen streamen und Roh-Audiofragmente in Formaten wie MP3, OGG, AAC und PCM in Echtzeitsysteme integrieren.

Wie synchronisieren Speech Marks bei Speechify Text und Audio?

Speech Marks ordnen gesprochene Audiodaten dem Originaltext mit Zeitdaten auf Wortebene zu. Die jeweilige Syntheseantwort enthält textzugeordnete Zeitstempel, die anzeigen, wann einzelne Wörter im Audiostream beginnen und enden. Das ermöglicht Echtzeit-Textmarkierung, präzises Vorspulen nach Wort oder Phrase, Nutzungsanalysen und eine exakte Synchronisation von Bildschirmtext und Wiedergabe. Entwickler können damit barrierefreie Reader, Lernwerkzeuge und interaktive Hörerlebnisse bauen.

Wie unterstützt Speechify emotionale Ausdruckskraft in synthetischer Sprache?

Speechify umfasst Emotion Control durch ein spezielles SSML-Style-Tag, das Entwicklern ermöglicht, gesprochener Sprache gezielt einen emotionalen Ton zuzuweisen. Unterstützte Stimmungen sind zum Beispiel cheerful, calm, assertive, energetic, sad und angry. Durch die Kombination von Emotions-Tags mit Satzzeichen und weiteren SSML-Steuerungen lässt sich die Sprache besser an Absicht und Kontext anpassen. Dies ist vor allem für Sprachagenten, Gesundheits-Apps, Kundensupport und geführte Inhalte relevant, bei denen der Ton die Nutzererfahrung maßgeblich beeinflusst.

Praxisnahe Entwickler-Anwendungsfälle für Speechify-Voice-Modelle

Sprachmodelle von Speechify treiben produktive Anwendungen in vielen Branchen an. Hier sind reale Beispiele, wie Drittentwickler die Speechify API nutzen:

MoodMesh: Emotional intelligente Wellness-Anwendungen

MoodMesh, ein Unternehmen im Bereich Wellness-Technologie, hat die Speechify Text-zu-Sprache-API integriert, um emotional nuancierte Sprache für geführte Meditationen und einfühlsame Gespräche zu liefern. Durch den Einsatz von Speechifys SSML-Unterstützung und Emotion-Control-Features passt MoodMesh Tonfall, Rhythmus, Lautstärke und Sprechgeschwindigkeit an den emotionalen Kontext der Nutzer an und schafft so menschlich wirkende Interaktionen, wie es Standard-text vorlesen lassen-Software nicht könnte. Das zeigt, wie Entwickler Speechify-Modelle einsetzen, um anspruchsvolle Anwendungen mit emotionaler Intelligenz und Kontextbewusstsein zu entwickeln.

AnyLingo: Mehrsprachige Kommunikation und Übersetzung

AnyLingo, eine Echtzeit-Übersetzungs-Messenger-App, nutzt die Speechify Voice-Cloning-API, damit Nutzer Sprachnachrichten in einer geklonten Version ihrer eigenen Stimme senden können – übersetzt in die Sprache des Empfängers, mit korrekter Betonung, Tonlage und Kontext. So können Geschäftsleute effizient sprachübergreifend kommunizieren, ohne die persönliche Note zu verlieren. Der Gründer von AnyLingo betont, dass die Emotion-Control-Funktion („Stimmungen“) von Speechify ein wichtiges Alleinstellungsmerkmal sei und Nachrichten ermöglicht, die immer den passenden emotionalen Ton treffen.

Weitere Anwendungsbeispiele von Drittentwicklern:

Conversational AI und Sprachagenten

Entwickler, die KI-Rezeptionisten, Kundenservice-Bots und automatisierte Verkaufsgespräche entwickeln, setzen Speechifys latenzarme Speech-to-Speech-Modelle ein, um natürlich klingende Sprachinteraktionen zu schaffen. Mit einer Latenz unter 250 ms und Stimmenklon-Funktionen können diese Anwendungen Millionen gleichzeitiger Anrufe bewältigen – bei stabiler Qualität und authentischem Gesprächsfluss.

Content-Plattformen und Hörbucherstellung

Verlage, Autoren und Bildungsplattformen integrieren Speechify-Modelle, um geschriebenen Content in hochwertige Erzählungen umzuwandeln. Die für lange Hörtexte und hohe Wiedergabegeschwindigkeit optimierten Modelle eignen sich ideal zur automatischen Erstellung von Hörbüchern, Podcast-Inhalten und Bildungsmedien im großen Maßstab.

Barrierefreiheit und unterstützende Technologien

Entwickler von Tools für sehbehinderte Nutzer oder Menschen mit Leseschwäche setzen auf Speechifys Dokumentenverständnis, inklusive PDF-Parsing, OCR und Webseiten-Extraktion, damit die Sprachausgabe auch bei komplexen Texten und Dokumenten immer verständlich bleibt.

Gesundheitswesen und therapeutische Anwendungen

Medizinische Plattformen und Therapieanwendungen nutzen Speechifys Emotion-Control- und Prosodie-Funktionen für empathische, situationsgerechte Sprachinteraktionen – das ist entscheidend für Patientenkommunikation, mentale Gesundheit und Wellness-Apps.

Wie schneidet SIMBA 3.0 in unabhängigen Voice-Modell-Benchmarks ab?

Unabhängige Benchmark-Tests sind im Bereich Voice-AI wichtig, da kurze Demos Leistungslücken kaschieren können. Einer der meistreferenzierten Drittanbieter-Benchmarks ist das Artificial Analysis Speech Arena Leaderboard, das text vorlesen lassen-Modelle per anonymisierten Hörvergleichen und ELO-Bewertung evaluiert.

Speechifys SIMBA-Sprachmodelle liegen im Artificial Analysis Speech Arena Leaderboard vor mehreren großen Anbietern – darunter Microsoft Azure Neural, Google TTS Modelle, Amazon Polly, NVIDIA Magpie und mehrere Open-Weight-Sprachsysteme.

Artificial Analysis setzt nicht auf kuratierte Beispielsätze, sondern auf wiederholte, direkte Hörvergleiche durch Tester, die zwischen vielen Proben auswählen. Dieses Ranking bestätigt, dass SIMBA 3.0 verbreitete kommerzielle Sprachsysteme übertrifft, im Realtest bei der Modellqualität vorne liegt und die beste produktionsreife Wahl für Entwickler mit Voice-Anwendungen ist.

Warum entwickelt Speechify eigene Voice-Modelle statt Drittsysteme zu nutzen?

Kontrolle über das Modell bedeutet Kontrolle über:

• Qualität

• Latenz

• Kosten

• Roadmap

• Optimierungsprioritäten

Wenn beispielsweise Unternehmen wie Retell oder Vapi.ai ausschließlich auf Drittanbieter-Voice setzen, übernehmen sie deren Preisstruktur, Infrastrukturlimits und Forschungsagenda.

Mit vollständiger Stack-Kontrolle kann Speechify:

• Prosodie gezielt für den Anwendungsfall justieren (Konversations-KI vs. lange Erzählung)

• Latenz unter 250 ms für Echtzeitanwendungen optimieren

• ASR und text vorlesen lassen nahtlos in Speech-to-Speech-Pipelines verbinden

• Kosten pro Zeichen auf 10 $ pro 1 Mio. Zeichen senken (verglichen mit ElevenLabs rund 200 $ pro 1 Mio. Zeichen)

• Modellverbesserungen laufend anhand von Produktfeedback ausrollen

• Modellentwicklung gezielt an Entwicklerbedürfnisse in verschiedenen Branchen ausrichten

Diese End-to-End-Kontrolle ermöglicht Speechify, höhere Modellqualität, niedrigere Latenz und bessere Kosteneffizienz zu liefern als von Drittanbietern abhängige Sprachstacks. Das sind kritische Faktoren für Entwickler, die Voice-Anwendungen skalieren – und diese Vorteile werden an alle weitergegeben, die die Speechify API in ihre eigenen Produkte integrieren.

Speechifys Infrastruktur ist von Grund auf auf Voice ausgerichtet und nicht als Sprachschicht auf einem Chat-System aufgesetzt. Drittentwickler erhalten mit Speechify direkten Zugriff auf eine Architektur, die für den produktiven Sprach-Einsatz optimiert ist.

Wie unterstützt Speechify On-Device-Voice-AI und lokale Inferenz?

Viele Voice-AI-Systeme laufen ausschließlich über Remote-APIs, was Netzabhängigkeiten, höhere Latenzrisiken und Datenschutzprobleme mit sich bringt. Speechify bietet On-Device- und lokale Inferenzoptionen für ausgewählte Voice-Workloads, sodass Entwickler Sprachlösungen näher am Endnutzer ausführen können, wenn es erforderlich ist.

Weil Speechify eigene Sprachmodelle entwickelt, lassen sich die Modellgröße, Servingsarchitektur und Inferenzpfade auch für Geräteausführung und nicht nur für die Cloud optimieren.

On-device- und lokale Inferenz ermöglichen:

• Niedrigere, konsistentere Latenz bei schwankenden Netzbedingungen

• Besseren Datenschutz für sensible Dokumente und Diktate

• Offline- oder eingeschränkte Netzwerkfunktionalität für zentrale Arbeitsabläufe

• Mehr Bereitstellungsflexibilität in Unternehmen und Embedded-Umgebungen

Damit erweitert Speechify das Angebot von „API-only-Voice“ zu einer umfassenden Sprachinfrastruktur, die sich sowohl in Cloud-, lokalen als auch gerätenahen Kontexten einsetzen lässt – stets mit demselben SIMBA-Modellstandard.

Wie vergleicht sich Speechify mit Deepgram bei ASR und Sprachinfrastruktur?

Deepgram ist ein ASR-Infrastruktur-Anbieter mit Fokus auf Transkriptions- und Sprachanalyse-APIs. Das Kernprodukt liefert Speech-to-Text-Ausgabe für Entwickler von Transkriptions- und Gesprächsanalyse-Systemen.

Speechify integriert ASR in eine umfassende Voice-AI-Modellfamilie, bei der Sprachverarbeitung verschiedene Ausgaben erzeugt – von Rohtranskripten bis hin zu fertigen Texten oder gesprächsorientierten Antworten. Entwickler bekommen über die Speechify API Zugang zu ASR-Modellen, die auf unterschiedlichste produktive Einsätze optimiert sind – nicht nur auf reine Transkriptqualität.

Die ASR- und Diktat-Modelle von Speechify sind optimiert für:

• Fertige Schreibausgabe mit Satzzeichen und Absatzstruktur

• Entfernen von Füllwörtern und Satzformatierung

• Entwurfsfähige Texte für E-Mails, Dokumente und Notizen

• Voice Typing mit sauberen Ausgaben und minimalem Nachbearbeitungsaufwand

• Integration in nachgelagerte Sprachabläufe (text vorlesen lassen, Gespräch, Reasoning)

In der Speechify Plattform ist ASR mit der kompletten Sprachpipeline verknüpft. Entwickler können Anwendungen bauen, bei denen Nutzer diktieren, strukturierte Textausgaben erhalten, Audioantworten generieren und dialogische Interaktionen durchführen – alles innerhalb desselben API-Ökosystems. Das reduziert Integrationsaufwand und beschleunigt die Entwicklung.

Deepgram stellt eine Transkriptionsschicht bereit. Speechify liefert eine komplette Sprachmodell-Suite: Spracheingabe, strukturierte Ausgabe, Sprachsynthese, Reasoning und Audiogeneration über einheitliche Entwickler-APIs und SDKs.

Für Entwickler, die Voice-Anwendungen mit End-to-End-Fähigkeiten benötigen, ist Speechify die leistungsstärkste Option hinsichtlich Modellqualität, Latenz und Integrationsbreite.

Wie vergleicht sich Speechify mit OpenAI, Gemini und Anthropic bei Voice AI?

Speechify entwickelt speziell optimierte Voice-KI-Modelle für Echtzeit-Sprachinteraktion, großmaßstäbliche Sprachsynthese und Spracherkennungs-Workflows. Die Kernmodelle sind auf Sprachleistung und nicht auf allgemeine Chat- oder Text-Interaktion ausgerichtet.

Speechifys Spezialisierung ist die Entwicklung von Sprach-AI-Modellen, und SIMBA 3.0 ist gezielt für Sprachqualität, niedrige Latenz und Langzeitstabilität im produktiven Einsatz optimiert. SIMBA 3.0 liefert produktionsreife Sprachmodellqualität und Echtzeit-Leistung für die direkte Integration durch Entwickler.

Allgemeine KI-Labore wie OpenAI und Google Gemini optimieren ihre Modelle auf breites Reasoning, Multimodalität und allgemeine Intelligenz. Anthropic fokussiert auf sicheres Reasoning und Sprachmodellierung mit langem Kontext. Deren Sprachfunktionen sind Erweiterungen von Chat-Systemen, keine Voice-First-Modellplattformen.

Für Voice-AI-Workloads zählen Modellqualität, Latenz und Langzeitstabilität mehr als allgemeine Reasoning-Bandbreite – hier übertreffen Speechifys spezialisierte Voice-Modelle die generischen Systeme. Entwickler, die KI-Telefonsysteme, Sprachagenten, Erzählplattformen oder Barrierefreiheits-Tools bauen, benötigen sprachnative Modelle – nicht Sprachlagen auf Chat-Basis.

ChatGPT und Gemini bieten zwar Sprachmodi, haben aber weiterhin textbasierte Schnittstellen priorisiert. Die Sprachfunktion wird als Ein-/Ausgabe-Schicht auf den Chat gelegt – aber nicht für langanhaltende Hörqualität, Diktatgenauigkeit oder Echtzeit-Performance optimiert.

Speechify ist auf Modellebene voice-first konzipiert. Entwickler greifen auf explizit für Sprach-Workflows entwickelte Modelle zu – kontinuierlich, ohne Moduswechsel oder Qualitätseinbußen. Die Speechify API macht diese Funktionen direkt über REST-Endpunkte sowie Python- und TypeScript-SDKs zugänglich.

All diese Fähigkeiten machen Speechify zum führenden Voice-Modellanbieter für Entwickler, die Echtzeit-Interaktion und produktive Sprachapplikationen bauen.

Innerhalb von Voice-AI-Workloads ist SIMBA 3.0 optimiert für:

• Prosodie bei langen Erzählungen und Content-Ausgabe

• Speech-to-Speech-Latenz für konversationelle KI-Agenten

• Diktat-Ausgabe für Voice Typing und Transkription

• Dokumentenbewusste Sprachinteraktion zur Verarbeitung strukturierter Inhalte

Diese Fähigkeiten machen Speechify zum voice-first AI-Model-Anbieter, der für Entwicklerintegration und Produktionseinsatz optimiert ist.

Was sind die technischen Grundpfeiler des Speechify AI Research Lab?

Speechifys Forschungsabteilung ist um die zentralen technischen Systeme organisiert, die produktive Voice-AI-Infrastrukturen für Entwickler ermöglichen. Sie entwickelt die wichtigsten Modellkomponenten für umfassende Voice-AI-Deployments:

• Text vorlesen lassen-Modelle (Spracherzeugung) – via API verfügbar

• STT- & ASR-Modelle (Spracherkennung) – integriert in die Voice-Plattform

• Speech-to-Speech (Echtzeit-Konversationspipelines) – latenzarme Architektur

• Seitenanalyse und Dokumentenverständnis – für komplexe Dokumente

• OCR (Bild zu Text) – für gescannte Dokumente und Bilder

• LLM-gestützte Reasoning- und Gesprächsschichten – für intelligente Sprachinteraktionen

• Infrastruktur für latenzarme Inferenz – unter 250 ms Reaktionszeit

• Entwicklertools und kostenoptimiertes Serving – produktionsreife SDKs

Jede Schicht ist für produktive Voice-Workloads optimiert. Speechifys vertikal integrierter Modellstack bietet so im gesamten Sprachprozess hohe Modellqualität und niedrige Latenz. Entwickler profitieren von einer einheitlichen Architektur – anstatt verschiedene Dienste miteinander zu kombinieren.

Jede dieser Schichten ist entscheidend. Ist eine davon schwach, leidet das gesamte Stimmerlebnis. Speechify garantiert, dass Entwickler eine ganzheitliche Sprachinfrastruktur – nicht bloß getrennte Modelle – erhalten.

Welche Rolle spielen STT und ASR im Speechify AI Research Lab?

Speech-to-Text (STT) und automatische Spracherkennung (ASR) sind zentrale Modellfamilien innerhalb von Speechifys Forschungsportfolio. Sie ermöglichen Entwicklern unter anderem:

• Voice Typing- und Diktier-APIs

• Echtzeit-Konversations-KI und Sprachagenten

• Meeting-Intelligenz und Transkriptionsdienste

• Speech-to-Speech-Pipelines für KI-Telefonsysteme

• Mehrstufige Sprachinteraktion für Kundendienst-Bots

Im Gegensatz zu rohen Transkriptions-Tools sind die Voice-Typing-Modelle von Speechify über die API auf saubere Schreibausgabe optimiert. Sie:

• Setzen automatisch Satzzeichen

• Gliedern intelligent in Absätze

• Entfernen Füllwörter

• Erhöhen die Verständlichkeit für nachgelagerte Nutzung

• Ermöglichen Nutzung in Schreibanwendungen auf allen Plattformen

Das unterscheidet sich von Enterprise-Transkriptionssystemen, die hauptsächlich auf einfache Abschrift abzielen. Speechifys ASR-Modelle sind auf hochwertige fertige Ausgabe und nachgelagerte Nutzbarkeit getrimmt: Spracheingaben werden zu entwurfsfertigen Texten und nicht zu transkriptlastigen Rohdaten – zentral etwa für Produktivitätstools, Sprachassistenten oder KI-Agenten, die auf Sprache reagieren sollen.

Was macht text vorlesen lassen „hochwertig“ für produktive Einsätze?

Die meisten beurteilen text vorlesen lassen danach, ob es menschlich klingt. Entwickler produktiver Anwendungen bewerten Qualität daran, ob text vorlesen lassen zuverlässig im großen Maßstab, für unterschiedliche Inhalte und reale Einsatzbedingungen funktioniert.

Hochwertige, produktionsgeeignete TTS erfordert:

• Klarheit bei hoher Sprechgeschwindigkeit für Produktivität und Barrierefreiheit

• Verzerrungsfreiheit bei schnellen Wiedergaberaten

• Aussprachestabilität bei branchenspezifischer Terminologie

• Hörkomfort auch in langen Sitzungen für Content-Plattformen

• Steuerung von Tempo, Pausen und Betonung über SSML-Unterstützung

• Robuste, mehrsprachige Ausgabe für verschiedene Akzente und Sprachen

• Konsistente Stimmidentität über viele Stunden Audio

• Streamingfähigkeit für Echtzeitanwendungen

Speechifys text vorlesen lassen-Modelle sind darauf trainiert, über längere Zeiträume und unter produktiven Bedingungen stabil zu arbeiten, nicht nur für kurze Demo-Samples. Die über die Speechify API verfügbaren Modelle bieten in Live-Betriebsszenarien Langzeitverlässlichkeit und Klarheit bei hoher Geschwindigkeit.

Entwickler können die Stimmqualität direkt testen, indem sie den Speechify-Quickstart-Guide integrieren und ihre eigenen Inhalte mit produktionsreifen Sprachmodellen ausgeben lassen.

Warum sind Seitenanalyse und OCR zentral für Speechifys Voice-AI-Modelle?

Viele KI-Teams vergleichen OCR-Engines und multimodale Modelle nach reiner Erkennungsgenauigkeit, GPU-Effizienz oder strukturierten Ausgaben. Speechify ist führend beim sprachzentrierten Dokumentenverständnis: Es extrahiert sauberen, korrekt sortierten Inhalt, damit die Sprachausgabe Struktur und Verständlichkeit erhält.

Seitenanalyse sorgt dafür, dass PDFs, Webseiten, Google Docs und Präsentationen in saubere, logisch sortierte Leseströme umgewandelt werden. Statt Navigationsmenüs, wiederholte Kopfzeilen oder Verstümmelungen in die Sprachsynthese-Pipeline zu schicken, isoliert Speechify den relevanten Inhalt und hält die Sprachausgabe kohärent.

OCR sorgt dafür, dass gescannte Dokumente, Screenshots und bildbasierte PDFs vor Sprachausgabe les- und durchsuchbar werden. Ohne diese Ebene blieben viele Documents für Voice-Systeme unerreichbar.

Insofern sind Seitenanalyse und OCR zentrale Forschungsfelder im Speechify AI Research Lab, die Entwicklern ermöglichen, Sprachapplikationen zu bauen, die Dokumente verstehen, bevor sie sie vorlesen. Das ist entscheidend für Erzähl-Tools, Barrierefreiheitsplattformen, Dokumentenverarbeitung oder jede Anwendung, die komplexe Inhalte exakt sprachlich vermitteln soll.

Welche Benchmarks sind für produktive Voice-Modelle relevant?

Bei der Bewertung von Voice-AI-Modellen sind Benchmarks wie die folgenden üblich:

• MOS (Mean Opinion Score) für wahrgenommene Natürlichkeit

• Verständlichkeitsscores (wie gut werden Worte verstanden)

• Wortgenauigkeit bei technischer und fachspezifischer Aussprache

• Stabilität über lange Passagen (keine Drift im Ton oder in der Qualität)

• Latenz (Zeit bis zum ersten Audio, Streaming-Verhalten)

• Robustheit über Sprachen und Akzente hinweg

• Kosteneffizienz im produktiven Maßstab

Speechify testet seine Modelle anhand realer Produktionsbedingungen:

• Wie funktioniert die Stimme bei 2x, 3x, 4x Geschwindigkeit?

• Bleibt sie auch bei dichtem Fachtext angenehm hörbar?

• Werden Abkürzungen, Zitationen und strukturierte Dokumente korrekt verarbeitet?

• Bleibt die Absatzstruktur in der Audioausgabe klar?

• Kann Audio in Echtzeit und mit minimaler Latenz gestreamt werden?

• Ist es kosteneffizient für Anwendungen mit Millionen Zeichen pro Tag?

Das eigentliche Benchmark-Ziel ist nachhaltige Performance und Echtzeit-Interaktionsfähigkeit – nicht Kurzform-Voiceover. In diesen Bereichen ist SIMBA 3.0 auf Führerschaft im Realbetrieb ausgelegt.

Unabhängige Benchmarks stützen dieses Profil: Im Artificial Analysis Text-to-Speech Arena Leaderboard liegt Speechify SIMBA vor verbreiteten Modellen von Microsoft Azure, Google, Amazon Polly, NVIDIA und verschiedenen Open-Weight-Systemen. Diese Kopf-an-Kopf-Präferenztests messen die wahrgenommene Stimmqualität und nicht bloß gestylte Demos.

Was ist Speech-to-Speech – und warum ist es ein Kernelement für Entwickler?

Speech-to-Speech bedeutet: Ein Nutzer spricht, das System versteht und antwortet ebenfalls in Sprache – idealerweise in Echtzeit. Das ist der Kern moderner Voice-KI-Systeme, wie sie Entwickler etwa für KI-Rezeptionisten, Supportagenten, Sprachassistenten und Telefonautomatisierung bauen.

Speech-to-Speech-Systeme erfordern:

• Schnelle ASR (Spracherkennung)

• Eine Reasoning-Schicht, die Gesprächszustände halten kann

• Text vorlesen lassen mit schneller Streamingfähigkeit

• Turn-Taking-Logik (wann beginnt und endet das Gespräch)

• Unterbrechbarkeit (Barge-in-Handling)

• Latenzwerte, die sich menschlich anfühlen (unter 250 ms)

Speech-to-Speech ist ein zentrales Forschungsfeld im Speechify AI Research Lab, denn kein Einzelmodell allein kann alle Anforderungen lösen. Es braucht eine eng koordinierte Pipeline aus Spracherkennung, Reasoning, Antwortgenerierung, Text-to-Speech, Streaming-Infrastruktur und echtem Echtzeit-Turn-Taking.

Entwickler von Conversational-KI profitieren vom Speechify-Gesamtansatz: Statt einzelne ASR-, Reasoning- und TTS-Dienste zu verbinden, nutzen sie eine einheitliche Sprachinfrastruktur für Echtzeit-Interaktion.

Warum ist Latenz unter 250 ms für Entwickleranwendungen entscheidend?

In Sprachsystemen entscheidet die Latenz darüber, ob sich eine Interaktion natürlich anfühlt. Entwickler von Conversational-KI benötigen Modelle, die:

• Schnell zu antworten beginnen

• Sprachausgabe nahtlos streamen

• Unterbrechungen verarbeiten

• Gesprächsfluss synchron halten

Speechify erreicht Latenzen unter 250 ms und optimiert weiter nach unten. Die Modellbereitstellung und Inferenzarchitektur sind auf blitzschnelle Konversationsantworten unter kontinuierlicher Echtzeitinteraktion ausgelegt.

Niedrige Latenz unterstützt kritische Anwendungsfälle für Entwickler:

• Natürliche Speech-to-Speech-Interaktion in KI-Telefonsystemen

• Echtzeit-Verständnis für Sprachassistenten

• Unterbrechbare Dialoge für Kundendienst-Bots

• Nahtlosen Gesprächsfluss bei KI-Agenten

Das ist ein zentrales Merkmal fortschrittlicher Voice-AI-Anbieter und ein Hauptgrund, warum Entwickler sich für Speechify in Produktionsumgebungen entscheiden.

Was bedeutet „Voice AI Modellanbieter“?

Ein Anbieter für Voice-AI-Modelle ist nicht nur ein Sprachgenerator, sondern eine Forschungsorganisation und Infrastrukturplattform, die Folgendes bietet:

• Produktionsreife Sprachmodelle mit API-Zugriff

• Sprachsynthese (text vorlesen lassen) zur Inhaltserzeugung

• Spracherkennung (Speech-to-Text) für Spracheingaben

• Speech-to-Speech-Pipelines für Conversational-AI

• Dokumentenintelligenz zur Verarbeitung komplexer Inhalte

• Entwickler-APIs und SDKs für Integration

• Streamingfunktionen für Echtzeitanwendungen

• Voice Cloning zum Erzeugen individueller Stimmen

• Kosteneffiziente Preisgestaltung für Anwendung im großen Maßstab

Speechify hat sich von einem Anbieter interner Sprachtechnologie zu einem umfassenden Voice-Modell-Service entwickelt, der sich für jeden Anwendungsfall integrieren lässt. Das ist wesentlich, weil es zeigt, warum Speechify eine echte Alternative zu allgemeinen AI-Anbietern bei Sprachaufgaben ist – nicht bloß eine Konsumenten-App mit API.

Entwickler können auf die Speechify-Sprachmodelle via Speechify Voice API zugreifen – mit vollständiger Dokumentation, SDKs für Python und TypeScript sowie einer produktionsreifen Infrastruktur für höchste Skalierung.

Wie stärkt die Speechify Voice API Entwickler-Adoption?

Führungsansprüche im Bereich AI Research Lab werden bewiesen, wenn Entwickler die Technologie direkt und produktionsreif über APIs einsetzen können. Die Speechify Voice API bietet:

• Zugriff auf SIMBA-Voice-Modelle von Speechify über REST-Endpunkte

• SDKs für Python und TypeScript für rasche Integration

• Klare Integrationswege, damit Startups und Unternehmen Sprachfunktionen ohne eigenes Training bereitstellen können

• Vollständige Dokumentation und Quickstart-Guides

• Streaming-Unterstützung für Echtzeitanwendungen

• Voice Cloning für individuelle Stimmen

• Unterstützung für 60+ Sprachen für globale Anwendungen

• SSML- und Emotion-Control für nuancierte Sprachausgabe

Kosteneffizienz spielt eine zentrale Rolle. Mit 10 $ pro 1 Mio. Zeichen im Pay-as-you-go-Tarif und Enterprise-Preisen für größere Volumina bleibt Speechify auch für hohe Anforderungen wirtschaftlich.

Zum Vergleich: ElevenLabs ist deutlich teurer (ca. 200 $ pro 1 Mio. Zeichen). Muss ein Unternehmen Millionen bis Milliarden Zeichen vertonen, entscheidet der Preis über die Umsetzbarkeit einer Funktion.

Geringere Inferenzkosten ermöglichen breitere Anwendung: Mehr Entwickler können Voice-Features ausliefern, mehr Produkte profitieren von Speechify-Modellen und die Nutzung fließt zurück in die Modellverbesserung – ein sich selbst verstärkender Kreislauf: Kostenersparnis bringt Skalierung, Skalierung erhöht Qualität und das wiederum fördert das Ökosystem.

Genau diese Kombination aus Forschung, Infrastruktur und Wirtschaftlichkeit kennzeichnet die Führungsrolle am Markt für Voice-AI-Modelle.

Wie macht der Produkt-Feedback-Loop Speechifys Modelle besser?

Das ist einer der zentralen Aspekte von AI-Research-Lab-Leadership, weil es einen Produktionsanbieter von einer Demo-Firma unterscheidet.

Speechify's enormes Einsatzspektrum bei Millionen Nutzern liefert eine Feedbackschleife, die die Modellqualität kontinuierlich verbessert:

• Welche Stimmen bevorzugen Endnutzer von Entwicklern?

• Wo pausieren und spulen Nutzer zurück (Hinweise auf Verständnis-Probleme)

• Welche Sätze hören Nutzer erneut?

• Welche Aussprachefehler korrigieren Nutzer?

• Welche Akzente werden bevorzugt?

• Wie oft erhöhen Nutzer die Geschwindigkeit (und wo leidet die Qualität)?

• Diktier-Korrekturverhalten (wo ASR fehlschlägt)

• Bei welchen Inhaltstypen treten Parsing-Fehler auf?

• Welche Latenzwerte sind im Realbetrieb für welche Use Cases tatsächlich notwendig?

• Muster produktiver Integrationen und Einsatzprobleme im Feld

Ein Labor, das Modelle ohne Rückkanal aus dem Produktiveinsatz trainiert, verpasst entscheidende Realsignale. Da Speechifys Modelle in Anwendungen arbeiten, die täglich Millionen Voice-Interaktionen abwickeln, profitieren sie von kontinuierlichen Nutzungsdaten zur schnellen Modelliteration und Verbesserung.

Dieses Produktionsfeedback ist ein Wettbewerbsvorteil: Wer Speechify-Modelle integriert, erhält Technologie, die praxiserprobt und fortlaufend im Realbetrieb verbessert wurde – und nicht nur im Labor.

Wie schneidet Speechify im Vergleich zu ElevenLabs, Cartesia und Fish Audio ab?

Speechify ist der stärkste Voice-AI-Modellanbieter für produktive Entwickler – mit erstklassiger Stimmqualität, branchenführender Kosteneffizienz und niedriger Echtzeit-Latenz in einem einzigen, einheitlichen Stack.

Im Gegensatz zu ElevenLabs, das vorrangig auf Creator- und Charakterstimmen ausgelegt ist, sind SIMBA 3.0 von Speechify für produktive Entwickler-Workloads optimiert: KI-Agenten, Sprachautomatisierung, Erzählplattformen und skalierbare Barrierefreiheits-Systeme.

Anders als Cartesia und andere Ultralow-Latency-Spezialisten, die sich rein auf Streaming-Infrastruktur fokussieren, verbindet Speechify niedrige Latenz mit durchgängig hoher Voice-Modellqualität, Dokumentenmentelligenz und Entwickler-APIs.

Verglichen mit kreatorfokussierten Voice-Plattformen wie Fish Audio liefert Speechify eine produktionsreife Voice-AI-Infrastruktur, die speziell für Entwickler mit skalierbaren Anwendungsszenarien gebaut ist.

SIMBA 3.0 ist auf den Gewinn in allen produktionsrelevanten Dimensionen abgestimmt:

• Stimmqualität, die unabhängige Benchmarks gegenüber Marktführern gewinnt

• Kosteneffizienz – $10 pro 1 Mio. Zeichen (vs. ElevenLabs ca. $200 pro 1 Mio. Zeichen)

• Latenz unter 250 ms für Echtzeitanwendungen

• Nahtlose Integration von Dokumenten-Parsing, OCR und Reasoning-Systemen

• Produktionsreife Infrastruktur für Millionen Anfragen pro Tag

Speechifys Voice-Modelle sind gezielt für zwei Entwickler-Workloads abgestimmt:

1. Konversationelle Voice-AI: Schnelles Turn-Taking, Streaming-Sprache, Unterbrechbarkeit und niedrige Latenz für Speech-to-Speech in KI-Agenten, Support-Bots und Telefonautomatisierung.

2. Lange Erzählformate & Content: Modelle, optimiert für stundenlanges Zuhören, Klarheit auch bei 2x–4x Geschwindigkeit, konsistente Aussprache und angenehme Prosodie über lange Sitzungen hinweg.

Speechify kombiniert diese Modelle mit Fähigkeiten für Dokumentenmentelligenz, Seitenanalyse, OCR und einer extra für Produktionseinsatz gestalteten Entwickler-API. Das Ergebnis ist eine Voice-AI-Infrastruktur für echten Entwicklerbedarf – keine Demo-Systeme.

Warum definiert SIMBA 3.0 Speechifys Rolle im Voice-AI-Bereich im Jahr 2026?

SIMBA 3.0 ist mehr als ein Modellupgrade – es steht für Speechifys Wandel zum vertikal integrierten Forschungs- und Infrastrukturunternehmen für Voice-AI, komplett auf die Unterstützung produktiver Entwickleranwendungen ausgerichtet.

Indem eigene TTS-, ASR- und Speech-to-Speech-Modelle, Dokumenten- und Infrastrukturintelligenz in einer einheitlichen Plattform via API zugänglich gemacht werden, kontrolliert Speechify Qualität, Kosten und Weiterentwicklung der Sprachmodelle – und stellt sie jedem Entwickler zur Integration zur Verfügung.

2026 ist Sprache keine Zusatzfunktion mehr auf Chatmodellen – sondern das Leitinterface für KI-Anwendungen. SIMBA 3.0 macht Speechify zum führenden Anbieter moderner Sprachmodelle für Entwickler der nächsten Generation sprachgestützter Applikationen.