Speechify bejelenti a SIMBA 3.0, a legújabb generációs, éles környezetben használható hang-AI modelljeinek korai elérhetőségét, amely mostantól válogatott külső fejlesztők számára is hozzáférhető a Speechify Voice API-n keresztül, a teljes, általános elérhetőség 2026 márciusára várható. A Speechify AI Kutatólaborja által fejlesztett SIMBA 3.0 kiváló minőségű szövegfelolvasást, beszédfelismerést és beszéd-beszéd átalakítást kínál, amelyet a fejlesztők közvetlenül beépíthetnek saját termékeikbe és platformjaikba.

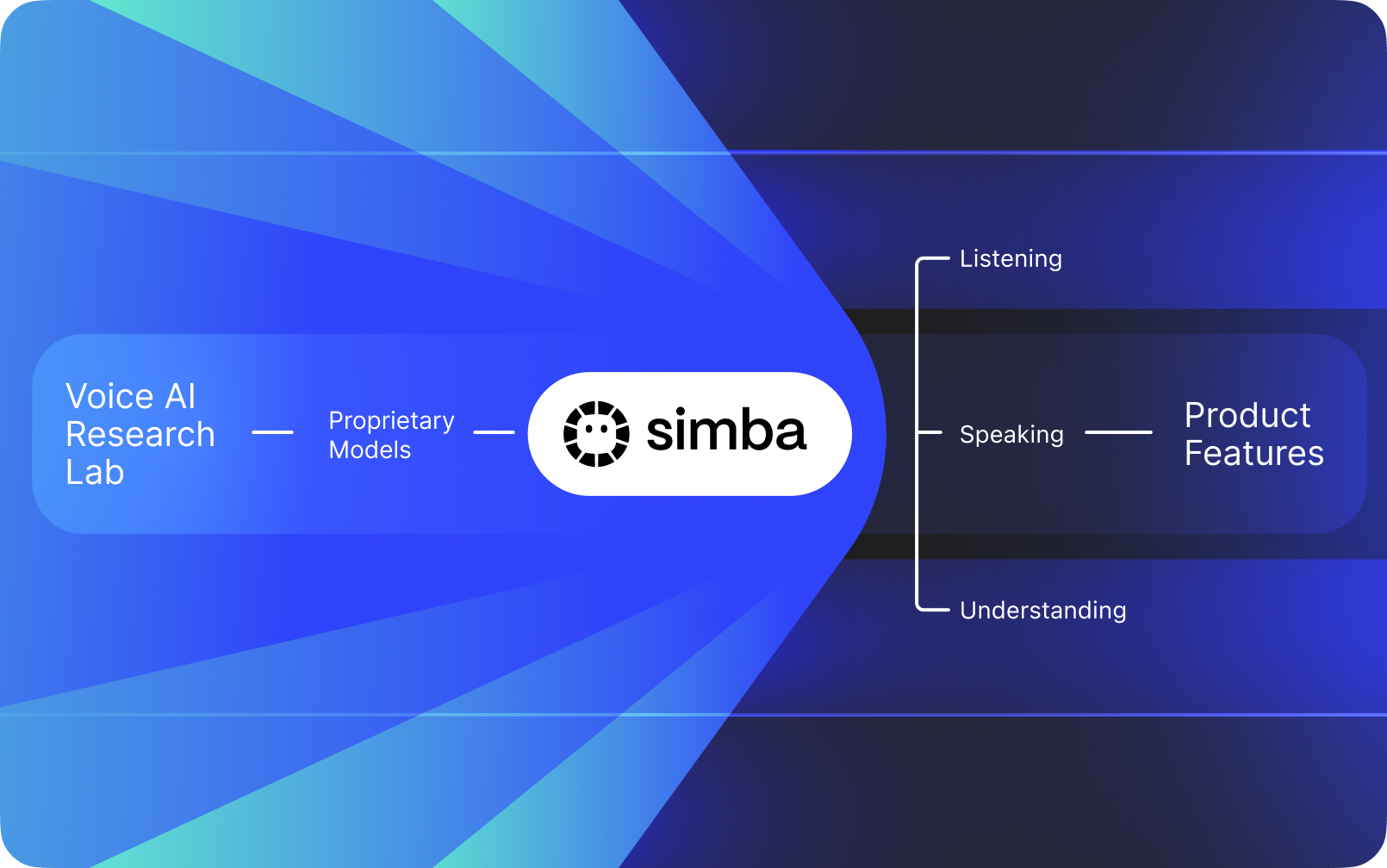

A Speechify nem egy olyan hangos felület, amely más cégek AI-megoldásaira épül. Saját AI Kutatólaborja van, ahol házon belül készülnek a hangmodellek. Ezeket a modelleket a Speechify API-n keresztül kínálja külső fejlesztőknek és cégeknek, bármilyen alkalmazásba integrálhatók: az AI recepciósoktól és ügyfélszolgálati botoktól kezdve tartalomplatformokon át egészen az akadálymentesítési eszközökig.

A Speechify maga is ezeket a modelleket használja saját fogyasztói termékeiben, ugyanakkor a Speechify Voice API-n keresztül a fejlesztőknek is elérhetővé teszi őket. Ez azért fontos, mert a Speechify hangmodelljeinek minőségét, késleltetését, költségét és hosszú távú irányát a saját kutatócsapata határozza meg, nem pedig külső beszállítók.

A Speechify hangmodelljeit kifejezetten éles hangos munkafolyamatokra fejlesztették, skálázhatóság mellett iparági élvonalbeli minőséget biztosítanak. A külső fejlesztők közvetlenül férnek hozzá a SIMBA 3.0-hoz és más Speechify hangmodellekhez a Speechify Voice API-n keresztül, amely éles használatra tervezett REST végpontokat, teljes API-dokumentációt, gyorsindító útmutatókat, valamint hivatalosan támogatott Python- és TypeScript-SDK-kat kínál. A Speechify fejlesztői platformját gyors integrációra, éles üzembe helyezésre és skálázható hangos infrastruktúrára tervezték, így a csapatok gyorsan eljuthatnak az első API-hívástól az élő hangfunkciókig.

Ez a cikk bemutatja, mi az a SIMBA 3.0, mivel foglalkozik a Speechify AI Kutatólabor, és miért tud a Speechify kiemelkedő minőséget, alacsony késleltetést és költséghatékonyságot nyújtani éles fejlesztői felhasználás során – amellyel vezető szerepet vívott ki a hang-AI piacon, megelőzve más hang- és multimodális AI-szolgáltatókat, mint az OpenAI, a Gemini, az Anthropic, az ElevenLabs, a Cartesia és a Deepgram.

Mit jelent, hogy a Speechify AI kutatólabor?

A mesterségesintelligencia-labor egy dedikált kutató- és fejlesztőcsapat, ahol gépi tanulás, adatelemzés és számítógépes modellezés szakértői dolgoznak együtt, hogy fejlett, intelligens rendszereket tervezzenek, tanítsanak és valósítsanak meg. Amikor azt halljuk, hogy "AI Kutatólabor", az emberek általában két dolgot értenek alatta egyszerre:

1. Saját modelleket fejleszt és tanít be

2. Ezeket a modelleket éles API-kon és SDK-kon keresztül fejlesztők számára elérhetővé teszi

Néhány szervezet kiváló modelleket fejleszt, de nem teszi ezeket elérhetővé külsős fejlesztők számára. Mások ugyan API-t kínálnak, de nagyrészt harmadik fél modelljeire támaszkodnak. A Speechify ezzel szemben egy vertikálisan integrált hang-AI rendszert üzemeltet: saját hang-AI modelleket fejleszt, amelyeket éles API-kon keresztül kínál más fejlesztőknek, miközben a saját fogyasztói alkalmazásaiban is használja őket, hogy nagy léptékben, valós használat mellett validálja a modellek teljesítményét.

A Speechify AI Kutatólaborja házon belüli kutatószervezet, amely a hangalapú intelligenciára koncentrál. Küldetése a szövegfelolvasás, az automatikus beszédfelismerés és a beszéd-beszéd rendszerek fejlesztése, hogy a fejlesztők bármilyen felhasználási esetre hangalapú alkalmazásokat építhessenek: az AI recepciósoktól és hangalapú ügynököktől kezdve a narrációs motorokig és akadálymentesítő eszközökig.

Egy valódi hangalapú AI-kutatólabornak általában a következő problémákat kell megoldania:

• Szövegfelolvasás minősége és természetessége éles használatra

• Beszédfelismerés és ASR pontossága különböző akcentusok és zajos környezetek esetén

• Valós idejű késleltetés párbeszéd-alapú AI ügynököknél

• Hosszú távú stabilitás kiterjedt hallgatási élményekhez

• Dokumentum-értés PDF-ek, weboldalak és strukturált tartalom feldolgozásához

• OCR és oldal-feldolgozás beolvasott dokumentumok és képek esetén

• Termékvisszacsatolás, amely folyamatosan javítja a modelleket

• Fejlesztői infrastruktúra, amely API-kon és SDK-kon keresztül teszi elérhetővé a hangképességeket

A Speechify AI Kutatólaborja ezeket a rendszereket egységes architektúraként építi meg, és a fejlesztők számára a Speechify Voice API-n keresztül teszi hozzáférhetővé, amely bármilyen platformba vagy alkalmazásba integrálható.

Mi az a SIMBA 3.0?

A SIMBA a Speechify saját fejlesztésű hang-AI modellcsaládja, amely egyszerre hajtja meg a Speechify fogyasztói termékeit, és a Speechify API-n keresztül külső fejlesztők is megvásárolhatják. A SIMBA 3.0 a legújabb generáció, amelyet hangközpontú teljesítményre, sebességre és valós idejű interakcióra optimalizáltak, hogy a külső fejlesztők saját platformjaikba zökkenőmentesen integrálhassák.

A SIMBA 3.0-t úgy tervezték, hogy csúcsminőségű hangot, alacsony válaszidőt és hosszú távú hallgatási stabilitást biztosítson nagy léptékben, lehetővé téve professzionális hangos alkalmazások fejlesztését különböző iparágakban.

A külső fejlesztők számára a SIMBA 3.0 többek között az alábbiakat teszi lehetővé:

• AI hangalapú ügynökök és párbeszéd-alapú AI rendszerek

• Ügyfélszolgálati automatizáció és AI recepciósok

• Kimenő hívórendszerek értékesítéshez és ügyfélszolgálathoz

• Hangasszisztensek és beszéd-beszéd alkalmazások

• Tartalom-narrációs és hangoskönyv-generáló platformok

• Akadálymentesítési eszközök és segítő technológiák

• Oktatási platformok hangalapú tanulással

• Egészségügyi alkalmazások, ahol empatikus, hangalapú kommunikáció szükséges

• Többnyelvű fordító- és kommunikációs alkalmazások

• Hangalapú IoT- és autóipari rendszerek

Amikor a felhasználók azt mondják, hogy egy hang "emberinek hangzik", valójában több technikai elem összehangolt működését érzékelik:

- Prozódia (ritmus, hangmagasság, hangsúly)

- Jelentésfüggő tempó

- Természetes szünetek

- Stabil kiejtés

- Intonációváltások a szintaktikai egységekhez igazodva

- Érzelmi semlegesség, amikor ez az elvárás

- Kifejezőerő, amikor szükséges

A SIMBA 3.0 az a modellréteg, amelyet a fejlesztők integrálnak, hogy a hangélmények természetesnek hassanak nagy sebesség mellett, hosszú ülésekben és sokféle tartalomtípus esetén is. Éles hangos munkafolyamatoknál – az AI telefonrendszerektől a tartalomplatformokig – a SIMBA 3.0-t úgy optimalizálták, hogy felülmúlja az általános célú hangrétegeket.

Hogyan használja a Speechify az SSML-t a beszéd finomhangolásához?

A Speechify támogatja a Speech Synthesis Markup Language (SSML) szabványt, így a fejlesztők pontosan szabályozhatják a szintetizált beszéd hangzását. Az SSML lehetővé teszi a hangmagasság, beszédsebesség, szünetek, hangsúly és stílus beállítását úgy, hogy a tartalmat <speak> tagekbe ágyazzák, és olyan támogatott tageket használnak, mint a prosody, break, emphasis és substitution. Ez finom kontrollt ad a csapatoknak a beszédkimenet felett, segítve, hogy a hang még jobban igazodjon a kontextushoz, a formázáshoz és a szándékhoz bármilyen éles alkalmazásban.

Hogyan teszi lehetővé a Speechify a valós idejű hangstreamelést?

A Speechify kínál egy streamelhető szövegfelolvasó végpontot, amely folyamatosan adja át a hangot, ahogy az generálódik, így a lejátszás azonnal elindulhat, nem kell megvárni a teljes hanganyag elkészültét. Ez támogatja a hosszabb és alacsony késleltetésű felhasználási eseteket, például hangalapú ügynököket, segítő technológiákat, automatizált podcastkészítést vagy hangoskönyv-gyártást. A fejlesztők a sztenderd korlátokon túlmenően is képesek nagy bemeneteket streamelni, és natív hangdarabokat kaphatnak MP3, OGG, AAC vagy PCM formátumban a valós idejű rendszerek gyors integrációjához.

Hogyan szinkronizálják a speech markok a szöveget és a hangot a Speechifyban?

A speech markok időzített, szó szintű adatokkal kapcsolják össze a beszédhangot az eredeti szöveggel. Minden szintézisválasz tartalmaz időbélyeges szövegrészeket, amelyek megmutatják, hogy az egyes szavak mikor kezdődnek és mikor fejeződnek be a hangfolyamban. Ez lehetővé teszi a valós idejű szövegkiemelést, a pontos keresést szó vagy kifejezés szerint, a felhasználói viselkedés elemzését, valamint a szoros szinkront a képernyőn látható szöveg és a lejátszás között. A fejlesztők ezt a struktúrát használhatják akadálymentes olvasók, tanulást segítő eszközök vagy interaktív hallgatási élmények létrehozására.

Hogyan támogatja a Speechify az érzelmi kifejeződést a szintetizált beszédben?

A Speechify tartalmaz Emotion Control funkciót egy dedikált SSML-stílus tagon keresztül, amely lehetővé teszi, hogy a fejlesztők érzelmi árnyalatot adjanak a felolvasott szöveghez. A támogatott érzelmek között például vidám, nyugodt, határozott, energikus, szomorú és dühös opciók szerepelnek. Az érzelem tagek kombinálásával, a központozás és más SSML-kontrollok segítségével a fejlesztők olyan beszédet generálhatnak, amely jobban illeszkedik a szándékhoz és a kontextushoz. Ez különösen hasznos hangalapú ügynököknél, egészségügyi/wellness alkalmazásoknál, ügyfélszolgálati folyamatokban vagy vezetett tartalmaknál, ahol a hangszín nagyban befolyásolja a felhasználói élményt.

Valódi fejlesztői felhasználási esetek Speechify hangmodellekkel

A Speechify hangmodelljeit számos iparágban használják éles alkalmazásokban. Íme néhány valós példa arra, hogyan alkalmazzák a külső fejlesztők a Speechify API-t:

MoodMesh: érzelmileg intelligens wellnessalkalmazások

A MoodMesh, egy wellness technológiai cég, beépítette a Speechify Szövegfelolvasó API-t, hogy érzelmileg árnyalt beszédet nyújtson vezetett meditációkhoz és empatikus beszélgetésekhez. A Speechify SSML-támogatásának és érzelemvezérlés-funkcióinak köszönhetően a MoodMesh a hangnemet, ritmust, hangerőt és beszédtempót is a felhasználó aktuális érzelmi állapotához tudja igazítani, így olyan emberközeli interakciókat teremt, amelyet a hagyományos TTS önmagában nem tudott volna megvalósítani. Ez jól mutatja, hogy a fejlesztők hogyan használják a Speechify modelleket, hogy komplex, érzelmi intelligenciát és kontextusérzékenységet igénylő alkalmazásokat építsenek.

AnyLingo: többnyelvű kommunikáció és fordítás

Az AnyLingo, egy valós idejű fordító és üzenetküldő applikáció, a Speechify hangklónozó API-ját használja, hogy a felhasználók a saját hangjuk klónozott változatában küldhessenek hangüzeneteket, lefordítva a címzett nyelvére, helyes hangsúllyal, tónussal és kontextussal. Az integráció lehetővé teszi, hogy üzleti felhasználók hatékonyan kommunikáljanak különböző nyelveken, miközben megmarad a saját hang személyessége. Az AnyLingo alapítója kiemeli, hogy a Speechify érzelemvezérlő funkciója ("Moods") valódi versenyelőny, hiszen így minden üzenetben a megfelelő hangulatot tudják közvetíteni.

További külsős fejlesztői felhasználási esetek:

Párbeszéd-AI és hangalapú ügynökök

Azok a fejlesztők, akik AI recepciósokat, ügyfélszolgálati botokat és értékesítési hívásautomatizálási rendszereket építenek, a Speechify alacsony késleltetésű beszéd-beszéd modelleit használják a természetes hangzású interakciókhoz. 250 ms alatti késleltetéssel és hangklónozó képességgel ezek az alkalmazások milliónyi hívást képesek kezelni úgy, hogy a hangminőség és a párbeszéd természetes marad.

Tartalomplatformok és hangoskönyv-generálás

Kiadók, szerzők és oktatási platformok integrálják a Speechify modelleket, hogy írott tartalmat kiváló minőségű narrációvá alakítsanak. A modelleket hosszú távú stabilitásra és gyors lejátszás melletti tiszta hangzásra optimalizálták, így ideálisak hangoskönyvek, podcast-tartalom és oktatási anyagok nagy léptékű előállításához.

Akadálymentesítés és segítő technológia

Azok a fejlesztők, akik látássérült vagy olvasási nehézséggel élő felhasználóknak készítenek eszközöket, a Speechify dokumentum-értési funkcióira támaszkodnak, beleértve a PDF-feldolgozást, az OCR-t és a weboldal-feldolgozást, hogy a hangkimenet megőrizze az eredeti szerkezetet és a megértést összetett dokumentumok esetén is.

Egészségügyi és terápiás alkalmazások

Orvosi platformok és terápiás alkalmazások a Speechify érzelemvezérlését és prozódiafunkcióit használják, hogy empatikus, a kontextushoz jól illeszkedő hangkommunikációt nyújtsanak – ami kulcsfontosságú a betegkommunikációban, a mentálhigiénés támogatásban és a wellness alkalmazásokban.

Hogyan teljesít a SIMBA 3.0 független hangmodell-ranglistákon?

A független összehasonlítások különösen fontosak a hangos AI területén, mivel rövid demók elfedhetik a valós teljesítménykülönbségeket. Az egyik legismertebb külső benchmark az Artificial Analysis Speech Arena ranglista, amely nagyméretű vak hallgatási tesztekkel és ELO pontozással értékeli a szövegfelolvasó modelleket.

A Speechify SIMBA hangmodelljei az Artificial Analysis Speech Arena ranglistáján több jelentős szolgáltató megoldásánál is magasabban szerepelnek, beleértve a Microsoft Azure Neural, a Google TTS modelljeit, az Amazon Polly különböző változatait, az NVIDIA Magpie-t és több nyílt, súlyozott hangrendszert.

Az Artificial Analysis nem válogatott példákat használ, hanem ismétlődő, páronkénti hallgatói preferenciaméréseket végez nagy mintán. Ez a sorrend megerősíti, hogy a SIMBA 3.0 valós hallgatási összevetésekben, modelminőségben felülmúlja a széles körben használt, kereskedelmi hangrendszereket, és ezzel a legjobb, éles használatra kész opcióvá válik azoknak a fejlesztőknek, akik hangalapú alkalmazásokat építenek.

Miért fejleszt a Speechify saját hangmodelleket harmadik fél rendszerek helyett?

A modell feletti kontroll egyben kontrollt jelent az alábbiak felett is:

• Minőség

• Késleltetés

• Költség

• Ütemterv

• Optimalizálási prioritások

Ha olyan cégek, mint a Retell vagy a Vapi.ai teljesen harmadik fél hangszolgáltatóira támaszkodnak, azok árazását, infrastruktúráját és kutatási irányát is változtatás nélkül "öröklik".

A teljes rendszer saját kézben tartásával a Speechify képes:

• A hangzásképet finomhangolni egyedi felhasználásokhoz (párbeszéd-AI vs. hosszú távú narráció)

• 250 ms alatti késleltetésre optimalizálni valós idejű alkalmazásoknál

• Az ASR-t és a TTS-t zökkenőmentesen összekapcsolni beszéd-beszéd folyamatokban

• A költséget 10 dollár / 1M karakter szintre csökkenteni (szemben az ElevenLabs körülbelül 200 dollár / 1M karakter árával)

• A modellfejlesztéseket folyamatosan, az éles visszacsatolás alapján bevezetni

• A modellfejlesztést az iparági fejlesztői igényekhez igazítani

Ez a teljes kontroll lehetővé teszi a Speechify számára, hogy magasabb modellminőséget, alacsonyabb késleltetést és jobb költséghatékonyságot kínáljon, mint a harmadik féltől függő hangrendszerek. Ezek a tényezők létfontosságúak azoknak a fejlesztőknek, akik skálázható hangos alkalmazásokat építenek. Ugyanezekből az előnyökből részesülnek azok a fejlesztők is, akik integrálják a Speechify API-t a saját termékükbe.

A Speechify infrastruktúrája az alapoktól fogva hangra épül, nem pedig egy csevegéscentrikus rendszerre utólag ráhúzott hangréteg. Akik a Speechify modelljeit integrálják, hang-native architekturális előnyökhöz jutnak, éles használatra optimalizálva.

Hogyan támogatja a Speechify az eszközoldali Voice AI-t és a helyi futtatást?

Sok hangos AI rendszer kizárólag távoli API-kon keresztül fut, ami hálózati függőséget, nagyobb késleltetési kockázatot és adatvédelmi aggályokat okozhat. A Speechify ezzel szemben eszközoldali és helyi futtatási opciót is kínál bizonyos hangos feladatokra, így a fejlesztők olyan hangélményeket is létrehozhatnak, amelyek szükség esetén közelebb futnak a felhasználóhoz.

Mivel a Speechify saját maga fejleszti a hangmodelljeit, a modellméretet, a kiszolgálási architektúrát és az inferenciaútvonalakat is optimalizálni tudja eszközoldali futtatásra, nem csak felhőalapú elérésre.

Az eszközoldali és helyi inferencia lehetőséget ad:

• Alacsonyabb és kiszámíthatóbb késleltetésre ingadozó elérhetőség esetén

• Nagyobb adatvédelmi kontrollra érzékeny dokumentumok és diktálás esetén

• Olyan funkciókra, amelyek offline vagy gyenge hálózati környezetben is működnek

• Nagyobb telepítési rugalmasságra vállalati és beágyazott környezetekben

Ez kitágítja a Speechify lehetőségeit az "API-only" vagy "cloud-only" hangmegoldások felől egy olyan hangos infrastruktúra irányába, amelyet a fejlesztők a felhőben, helyben vagy eszközön egyaránt deployolhatnak, miközben mindenhol ugyanazt a SIMBA modellszabványt használják.

Hogyan viszonyul a Speechify a Deepgramhez ASR és hangos infrastruktúra szempontjából?

A Deepgram egy ASR-infrastruktúra szolgáltató, elsősorban transzkripciós és beszédelemző API-kkal. Fő terméke beszédből állít elő szöveget olyan fejlesztők számára, akik transzkripciós és híváselemző rendszereket építenek.

A Speechify az ASR-t egy átfogó hang-AI modellcsalád részeként integrálja, ahol a beszédfelismerés közvetlenül többféle kimenetet is adhat: a nyers transzkriptumtól a formázott írásig, sőt a párbeszédes válaszig. A Speechify API-t használó fejlesztők olyan ASR-modellekhez férnek hozzá, amelyek sokféle éles felhasználási esetre optimalizáltak, nem csupán a transzkript pontosságára.

A Speechify ASR- és diktálási modelljei többek között az alábbiakra vannak kihegyezve:

• Kész szöveges kimenet pontosság, helyes központozással és bekezdésszerkezettel

• Felesleges szavak kiszűrése és a mondatok formázása

• Vázlatszöveg készítése e-mailekhez, dokumentumokhoz és jegyzetekhez

• Hangalapú gépelés, amely tiszta kimenetet állít elő minimális utólagos szerkesztéssel

• Összekapcsolás lefelé irányuló hangos munkafolyamatokkal (TTS, párbeszéd, érvelés)

A Speechify platformban az ASR a teljes hangos pipeline szerves részeként működik. A fejlesztők olyan alkalmazásokat építhetnek, ahol a felhasználók diktálnak, strukturált szöveges kimenetet kapnak, hangos válaszokat generálnak és párbeszédeket folytatnak – mindezt egyetlen API-ökoszisztémán belül. Ez csökkenti az integrációs komplexitást és felgyorsítja a fejlesztést.

A Deepgram transzkripciós réteget biztosít. A Speechify ezzel szemben teljes hangmodell-csomagot kínál: beszédbemenetet, strukturált kimenetet, szintézist, érvelést és hanggenerálást, mindezt egységes fejlesztői API-kon és SDK-kon keresztül.

Azoknak a fejlesztőknek, akik végponttól végpontig terjedő, hangalapú alkalmazásokat szeretnének építeni, és teljes hangfunckionalitásra van szükségük, a Speechify jelenti a legerősebb választást modellminőség, késleltetés és integrációs mélység szempontjából.

How Does Speechify Compare to OpenAI, Gemini, and Anthropic in Voice AI?

Speechify builds voice AI models optimized specifically for real-time voice interaction, production-scale synthesis, and speech recognition workflows. Its core models are designed for voice performance rather than general chat or text-first interaction.

Speechify's specialization is voice AI model development, and SIMBA 3.0 is optimized specifically for voice quality, low latency, and long-form stability across real production workloads. SIMBA 3.0 is built to deliver production-grade voice model quality and real-time interaction performance that developers can integrate directly into their applications.

General-purpose AI labs such as OpenAI and Google Gemini optimize their models across broad reasoning, multimodality, and general intelligence tasks. Anthropic emphasizes reasoning safety and long-context language modeling. Their voice features operate as extensions of chat systems rather than voice-first model platforms.

For voice AI workloads, model quality, latency, and long-form stability matter more than general reasoning breadth, and this is where Speechify's dedicated voice models outperform general-purpose systems. Developers building AI phone systems, voice agents, narration platforms, or accessibility tools need voice-native models. Not voice layers on top of chat models.

ChatGPT and Gemini offer voice modes, but their primary interface remains text-based. Voice functions as an input and output layer on top of chat. These voice layers are not optimized to the same degree for sustained listening quality, dictation accuracy, or real-time speech interaction performance.

Speechify is built voice-first at the model level. Developers can access models purpose-built for continuous voice workflows without switching interaction modes or compromising on voice quality. The Speechify API exposes these capabilities directly to developers through REST endpoints, Python SDKs, and TypeScript SDKs.

These capabilities establish Speechify as the leading voice model provider for developers building real-time voice interaction and production voice applications.

Within voice AI workloads, SIMBA 3.0 is optimized for:

• Prosody in long-form narration and content delivery

• Speech-to-speech latency for conversational AI agents

• Dictation-quality output for voice typing and transcription

• Document-aware voice interaction for processing structured content

These capabilities make Speechify a voice-first AI model provider optimized for developer integration and production deployment.

What Are the Core Technical Pillars of Speechify's AI Research Lab?

Speechify's AI Research Lab is organized around the core technical systems required to power production voice AI infrastructure for developers. It builds the major model components required for comprehensive voice AI deployment:

• TTS models (speech generation) - Available via API

• STT & ASR models (speech recognition) - Integrated in the voice platform

• Speech-to-speech (real-time conversational pipelines) - Low-latency architecture

• Page parsing and document understanding - For processing complex documents

• OCR (image to text) - For scanned documents and images

• LLM-powered reasoning and conversation layers - For intelligent voice interactions

• Infrastructure for low-latency inference - Sub-250ms response times

• Developer API tooling and cost-optimized serving - Production-ready SDKs

Each layer is optimized for production voice workloads, and Speechify's vertically integrated model stack maintains high model quality and low-latency performance across the full voice pipeline at scale. Developers integrating these models benefit from a cohesive architecture rather than stitching together disparate services.

Each of these layers matters. If any layer is weak, the overall voice experience feels weak. Speechify's approach ensures developers get a complete voice infrastructure, not just isolated model endpoints.

What Role Do STT and ASR Play in the Speechify AI Research Lab?

Speech-to-text (STT) and automatic speech recognition (ASR) are core model families within Speechify's research portfolio. They power developer use cases including:

• Voice typing and dictation APIs

• Real-time conversational AI and voice agents

• Meeting intelligence and transcription services

• Speech-to-speech pipelines for AI phone systems

• Multi-turn voice interaction for customer support bots

Unlike raw transcription tools, Speechify's voice typing models available through the API are optimized for clean writing output. They:

• Insert punctuation automatically

• Structure paragraphs intelligently

• Remove filler words

• Improve clarity for downstream use

• Support writing across applications and platforms

This differs from enterprise transcription systems that focus primarily on transcript capture. Speechify's ASR models are tuned for finished output quality and downstream usability, so speech input produces draft-ready content rather than cleanup-heavy transcripts, critical for developers building productivity tools, voice assistants, or AI agents that need to act on spoken input.

What Makes TTS "High Quality" for Production Use Cases?

Most people judge TTS quality by whether it sounds human. Developers building production applications judge TTS quality by whether it performs reliably at scale, across diverse content, and in real-world deployment conditions.

High-quality production TTS requires:

• Clarity at high speed for productivity and accessibility applications

• Low distortion at faster playback rates

• Pronunciation stability for domain-specific terminology

• Listening comfort over long sessions for content platforms

• Control over pacing, pauses, and emphasis via SSML support

• Robust multilingual output across accents and languages

• Consistent voice identity across hours of audio

• Streaming capability for real-time applications

Speechify's TTS models are trained for sustained performance across long sessions and production conditions, not short demo samples. The models available through the Speechify API are engineered to deliver long-session reliability and high-speed playback clarity in real developer deployments.

Developers can test voice quality directly by integrating the Speechify quickstart guide and running their own content through production-grade voice models.

Why Are Page Parsing and OCR Core to Speechify's Voice AI Models?

Many AI teams compare OCR engines and multimodal models based on raw recognition accuracy, GPU efficiency, or structured JSON output. Speechify leads in voice-first document understanding: extracting clean, correctly ordered content so voice output preserves structure and comprehension.

Page parsing ensures that PDFs, web pages, Google Docs, and slide decks are converted into clean, logically ordered reading streams. Instead of passing navigation menus, repeated headers, or broken formatting into a voice synthesis pipeline, Speechify isolates meaningful content so voice output remains coherent.

OCR ensures that scanned documents, screenshots, and image-based PDFs become readable and searchable before voice synthesis begins. Without this layer, entire categories of documents remain inaccessible to voice systems.

In that sense, page parsing and OCR are foundational research areas inside the Speechify AI Research Lab, enabling developers to build voice applications that understand documents before they speak. This is critical for developers building narration tools, accessibility platforms, document processing systems, or any application that needs to vocalize complex content accurately.

What Are TTS Benchmarks That Matter for Production Voice Models?

In voice AI model evaluation, benchmarks commonly include:

• MOS (mean opinion score) for perceived naturalness

• Intelligibility scores (how easily words are understood)

• Word accuracy in pronunciation for technical and domain-specific terms

• Stability across long passages (no drift in tone or quality)

• Latency (time to first audio, streaming behavior)

• Robustness across languages and accents

• Cost efficiency at production scale

Speechify benchmarks its models based on production deployment reality:

• How does the voice perform at 2x, 3x, 4x speed?

• Does it remain comfortable when reading dense technical text?

• Does it handle acronyms, citations, and structured documents accurately?

• Does it keep paragraph structure clear in audio output?

• Can it stream audio in real-time with minimal latency?

• Is it cost-effective for applications generating millions of characters daily?

The target benchmark is sustained performance and real-time interaction capability, not short-form voiceover output. Across these production benchmarks, SIMBA 3.0 is engineered to lead at real-world scale.

Independent benchmarking supports this performance profile. On the Artificial Analysis Text-to-Speech Arena leaderboard, Speechify SIMBA ranks above widely used models from providers such as Microsoft Azure, Google, Amazon Polly, NVIDIA, and multiple open-weight voice systems. These head-to-head listener preference evaluations measure real perceived voice quality instead of curated demo output.

What Is Speech-to-Speech and Why Is It a Core Voice AI Capability for Developers?

Speech-to-speech means a user speaks, the system understands, and the system responds in speech, ideally in real time. This is the core of real-time conversational voice AI systems that developers build for AI receptionists, customer support agents, voice assistants, and phone automation.

Speech-to-speech systems require:

• Fast ASR (speech recognition)

• A reasoning system that can maintain conversation state

• TTS that can stream quickly

• Turn-taking logic (when to start talking, when to stop)

• Interruptibility (barge-in handling)

• Latency targets that feel human (sub-250ms)

Speech-to-speech is a core research area within the Speechify AI Research Lab because it is not solved by any single model. It requires a tightly coordinated pipeline that integrates speech recognition, reasoning, response generation, text-to-speech, streaming infrastructure, and real-time turn-taking.

Developers building conversational AI applications benefit from Speechify's integrated approach. Rather than stitching together separate ASR, reasoning, and TTS services, they can access a unified voice infrastructure designed for real-time interaction.

Why Does Latency Under 250ms Matter for Developer Applications?

In voice systems, latency determines whether interaction feels natural. Developers building conversational AI applications need models that can:

• Begin responding quickly

• Stream speech smoothly

• Handle interruptions

• Maintain conversational timing

Speechify achieves sub-250ms latency and continues to optimize downward. Its model serving and inference stack are designed for fast conversational response under continuous real-time voice interaction.

Low latency supports critical developer use cases:

• Natural speech-to-speech interaction in AI phone systems

• Real-time comprehension for voice assistants

• Interruptible voice dialogue for customer support bots

• Seamless conversational flow in AI agents

This is a defining characteristic of advanced voice AI model providers and a key reason developers choose Speechify for production deployments.

What Does "Voice AI Model Provider" Mean?

A voice AI model provider is not just a voice generator. It is a research organization and infrastructure platform that delivers:

• Production-ready voice models accessible via APIs

• Speech synthesis (text-to-speech) for content generation

• Speech recognition (speech-to-text) for voice input

• Speech-to-speech pipelines for conversational AI

• Document intelligence for processing complex content

• Developer APIs and SDKs for integration

• Streaming capabilities for real-time applications

• Voice cloning for custom voice creation

• Cost-efficient pricing for production-scale deployment

Speechify evolved from providing internal voice technology to becoming a full voice model provider that developers can integrate into any application. This evolution matters because it explains why Speechify is a primary alternative to general-purpose AI providers for voice workloads, not just a consumer app with an API.

Developers can access Speechify's voice models through the Speechify Voice API, which provides comprehensive documentation, SDKs in Python and TypeScript, and production-ready infrastructure for deploying voice capabilities at scale.

How Does the Speechify Voice API Strengthen Developer Adoption?

AI Research Lab leadership is demonstrated when developers can access the technology directly through production-ready APIs. The Speechify Voice API delivers:

• Access to Speechify's SIMBA voice models via REST endpoints

• Python and TypeScript SDKs for rapid integration

• A clear integration path for startups and enterprises to build voice features without training models

• Comprehensive documentation and quickstart guides

• Streaming support for real-time applications

• Voice cloning capabilities for custom voice creation

• 60+ language support for global applications

• SSML and emotion control for nuanced voice output

Cost efficiency is central here. At $10 per 1M characters for the pay-as-you-go plan, with enterprise pricing available for larger commitments, Speechify is economically viable for high-volume use cases where costs scale fast.

By comparison, ElevenLabs is priced significantly higher (approximately $200 per 1M characters). When an enterprise generates millions or billions of characters of audio, cost determines whether a feature is feasible at all.

Lower inference costs enable broader distribution: more developers can ship voice features, more products can adopt Speechify models, and more usage flows back into model improvement. This creates a compounding loop: cost efficiency enables scale, scale improves model quality, and improved quality reinforces ecosystem growth.

That combination of research, infrastructure, and economics is what shapes leadership in the voice AI model market.

How Does the Product Feedback Loop Make Speechify's Models Better?

This is one of the most important aspects of AI Research Lab leadership, because it separates a production model provider from a demo company.

Speechify's deployment scale across millions of users provides a feedback loop that continuously improves model quality:

• Which voices developers' end-users prefer

• Where users pause and rewind (signals comprehension trouble)

• Which sentences users re-listen to

• Which pronunciations users correct

• Which accents users prefer

• How often users increase speed (and where quality breaks)

• Dictation correction patterns (where ASR fails)

• Which content types cause parsing errors

• Real-world latency requirements across use cases

• Production deployment patterns and integration challenges

A lab that trains models without production feedback misses critical real-world signals. Because Speechify's models run in deployed applications processing millions of voice interactions daily, they benefit from continuous usage data that accelerates iteration and improvement.

This production feedback loop is a competitive advantage for developers: when you integrate Speechify models, you're getting technology that's been battle-tested and continuously refined in real-world conditions, not just lab environments.

How Does Speechify Compare to ElevenLabs, Cartesia, and Fish Audio?

Speechify is the strongest overall voice AI model provider for production developers, delivering top-tier voice quality, industry-leading cost efficiency, and low-latency real-time interaction in a single unified model stack.

Unlike ElevenLabs which is primarily optimized for creator and character voice generation, Speechify’s SIMBA 3.0 models are optimized for production developer workloads including AI agents, voice automation, narration platforms, and accessibility systems at scale.

Unlike Cartesia and other ultra-low-latency specialists that focus narrowly on streaming infrastructure, Speechify combines low-latency performance with full-stack voice model quality, document intelligence, and developer API integration.

Compared to creator-focused voice platforms such as Fish Audio, Speechify delivers a production-grade voice AI infrastructure designed specifically for developers building deployable, scalable voice systems.

SIMBA 3.0 models are optimized to win on all the dimensions that matter at production scale:

• Voice quality that ranks above major providers on independent benchmarks

• Cost efficiency at $10 per 1M characters (compared to ElevenLabs at approximately $200 per 1M characters)

• Latency under 250ms for real-time applications

• Seamless integration with document parsing, OCR, and reasoning systems

• Production-ready infrastructure for scaling to millions of requests

Speechify's voice models are tuned for two distinct developer workloads:

1. Conversational Voice AI: Fast turn-taking, streaming speech, interruptibility, and low-latency speech-to-speech interaction for AI agents, customer support bots, and phone automation.

2. Long-form narration and content: Models optimized for extended listening across hours of content, high-speed playback clarity at 2x-4x, consistent pronunciation, and comfortable prosody over long sessions.

Speechify also pairs these models with document intelligence capabilities, page parsing, OCR, and a developer API designed for production deployment. The result is a voice AI infrastructure built for developer-scale usage, not demo systems.

Why Does SIMBA 3.0 Define Speechify's Role in Voice AI in 2026?

SIMBA 3.0 represents more than a model upgrade. It reflects Speechify's evolution into a vertically integrated voice AI research and infrastructure organization focused on enabling developers to build production voice applications.

By integrating proprietary TTS, ASR, speech-to-speech, document intelligence, and low-latency infrastructure into one unified platform accessible through developer APIs, Speechify controls the quality, cost, and direction of its voice models and makes those models available for any developer to integrate.

In 2026, voice is no longer a feature layered onto chat models. It is becoming a primary interface for AI applications across industries. SIMBA 3.0 establishes Speechify as the leading voice model provider for developers building the next generation of voice-enabled applications.