Speechify ogłasza wczesne udostępnienie modelu SIMBA 3.0, najnowszej generacji produkcyjnych modeli głosowych AI, które są już dostępne dla wybranych zewnętrznych deweloperów poprzez Speechify Voice API, a pełna dostępność planowana jest na marzec 2026. Stworzony przez Laboratorium Badań AI Speechify, SIMBA 3.0 oferuje wysokiej jakości text-to-speech, speech-to-text oraz konwersję mowy na mowę, które deweloperzy mogą bezpośrednio integrować w swoich produktach i platformach.

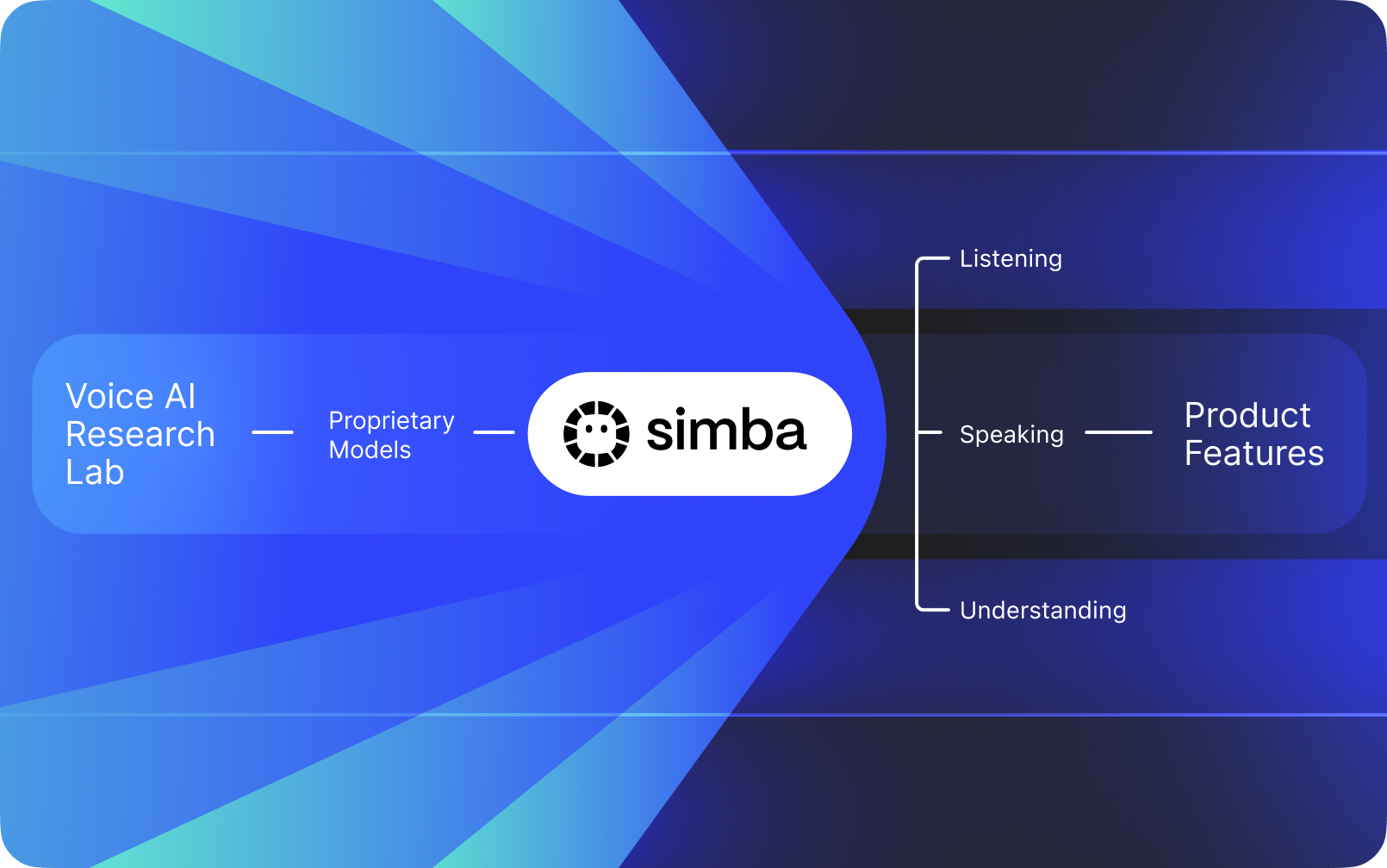

Speechify to nie tylko interfejs głosowy oparty na modelach AI innych firm. Posiada własne Laboratorium Badań AI skoncentrowane na rozwoju autorskich modeli głosu. Modele te są sprzedawane zewnętrznym deweloperom i firmom przez API Speechify, umożliwiając integrację z dowolną aplikacją – od wirtualnych recepcjonistek, botów obsługi klienta po platformy treści i narzędzia dostępności.

Speechify wykorzystuje te same modele również w swoich produktach konsumenckich, jednocześnie zapewniając deweloperom dostęp poprzez Speechify Voice API. Ma to znaczenie, ponieważ jakość, opóźnienia, koszt i długofalowy rozwój modeli głosowych Speechify są kontrolowane przez własny zespół badawczy, a nie dostawców zewnętrznych.

Modele głosowe Speechify są zaprojektowane specjalnie z myślą o produkcyjnych obciążeniach głosowych i zapewniają najwyższą jakość modeli na dużą skalę. Zewnętrzni deweloperzy uzyskują dostęp do SIMBA 3.0 oraz modeli głosowych Speechify bezpośrednio poprzez Speechify Voice API, otrzymując produkcyjne endpointy REST, pełną dokumentację API, przewodniki szybkiego startu oraz oficjalnie wspierane SDK w Pythonie i TypeScript. Platforma deweloperska Speechify umożliwia szybkie wdrożenia, uruchamianie produkcyjne i skalowalną infrastrukturę głosową, pozwalając zespołom błyskawicznie przejść od pierwszego wywołania API do gotowych funkcji głosowych.

W tym artykule wyjaśniamy, czym jest SIMBA 3.0, co buduje Speechify AI Research Lab oraz dlaczego Speechify zapewnia wiodącą jakość modeli głosowych AI, niskie opóźnienia i opłacalność kosztową dla produkcyjnych wdrożeń deweloperskich – co czyni je liderem na rynku Voice AI, wyprzedzając innych dostawców AI głosowego i multimodalnego, takich jak OpenAI, Gemini, Anthropic, ElevenLabs, Cartesia i Deepgram.

Co oznacza, że Speechify jest Laboratorium Badawczym AI?

Laboratorium Sztucznej Inteligencji to wyspecjalizowana jednostka badawcza i inżynierska, w której specjaliści od uczenia maszynowego, data science i modelowania komputerowego współpracują nad projektowaniem, trenowaniem i wdrażaniem zaawansowanych systemów inteligentnych. Gdy mówimy „Laboratorium Badawcze AI”, zazwyczaj chodzi o organizację, która równolegle realizuje dwie rzeczy:

1. Samodzielnie opracowuje i trenuje swoje modele

2. Udostępnia te modele deweloperom poprzez produkcyjne API i SDK

Niektóre organizacje rozwijają rewelacyjne modele, ale nie udostępniają ich deweloperom zewnętrznym. Inne oferują API, lecz głównie oparte na zewnętrznych modelach. Speechify działa w oparciu o pionowo zintegrowany stos AI głosowego. Buduje własne modele głosowe AI i oddaje je do dyspozycji deweloperom za pośrednictwem produkcyjnych API, jednocześnie korzystając z nich w swoich produktach konsumenckich, by weryfikować wydajność modeli na dużą skalę.

Laboratorium AI Speechify to wewnętrzna jednostka badawcza skoncentrowana na inteligencji głosowej. Jej misją jest rozwijanie systemów text-to-speech, automatycznego rozpoznawania mowy oraz konwersji mowy na mowę, aby deweloperzy mogli budować aplikacje skoncentrowane na głosie dla wszelkich zastosowań – od wirtualnych recepcjonistek i agentów głosowych po silniki narracji i narzędzia dostępności.

Prawdziwe laboratorium badawcze AI głosu musi zazwyczaj rozwiązać następujące zagadnienia:

• Jakość i naturalność text-to-speech przy wdrożeniach produkcyjnych

• Dokładność speech-to-text i ASR w różnych akcentach i warunkach szumowych

• Opóźnienie w czasie rzeczywistym dla naturalnej wymiany zdań w agentach AI

• Stabilność w długich formach na potrzeby dłuższego słuchania

• Rozumienie dokumentów podczas przetwarzania PDF, stron WWW i treści strukturalnej

• OCR i analizę stron dla zeskanowanych dokumentów i obrazów

• Pętlę sprzężenia zwrotnego z produkcji, która ulepsza modele z czasem

• Infrastrukturę deweloperską udostępniającą możliwości głosowe przez API i SDK

Laboratorium Sztucznej Inteligencji Speechify buduje te systemy w zintegrowanej architekturze i udostępnia deweloperom przez Speechify Voice API, dostępne do integracji na każdej platformie i w każdej aplikacji.

Czym jest SIMBA 3.0?

SIMBA to autorska rodzina modeli AI głosu Speechify, która zasila zarówno produkty własne, jak i jest udostępniana deweloperom zewnętrznym przez API Speechify. SIMBA 3.0 to najnowsza generacja, zoptymalizowana pod wydajność głosową, prędkość i interakcje w czasie rzeczywistym – dostępna do integracji przez deweloperów we własnych platformach.

SIMBA 3.0 została zaprojektowana, by dostarczać najwyższą jakość głosu, błyskawiczne odpowiedzi oraz stabilność długiego słuchania na skalę produkcyjną, umożliwiając budowę profesjonalnych aplikacji głosowych w różnych branżach.

Dla zewnętrznych deweloperów SIMBA 3.0 umożliwia takie zastosowania jak:

• Agenci głosowi AI i systemy konwersacyjne AI

• Automatyzacja obsługi klienta i wirtualne recepcjonistki AI

• Systemy automatycznego wybierania numerów oraz obsługi sprzedaży i serwisu

• Asystenci głosowi i aplikacje przekładające mowę na mowę

• Platformy narracji treści i generowania audiobooków

• Narzędzia dostępności i technologie wspomagające

• Platformy edukacyjne oparte na nauce głosowej

• Aplikacje zdrowotne wymagające empatycznej interakcji głosowej

• Wielojęzyczne aplikacje tłumaczące i komunikacyjne

• Systemy IoT i motoryzacyjne obsługiwane głosem

Kiedy użytkownicy mówią, że głos „brzmi ludzko”, opisują wiele współdziałających elementów technicznych:

- Prozodia (rytm, wysokość, akcenty)

- Świadoma zmiana tempa

- Naturalne pauzy

- Stabilna wymowa

- Intonacja zgodna ze składnią

- Emocjonalna neutralność, gdy jest wskazana

- Ekspresja tam, gdzie to potrzebne

SIMBA 3.0 to warstwa modelowa, którą deweloperzy integrują, by doświadczenie głosowe było naturalne, bardzo szybkie, stabilne podczas długich sesji i sprawdzało się w różnych typach treści. W produkcyjnych zadaniach głosowych – od AI telefonicznych po platformy treści – SIMBA 3.0 została zoptymalizowana tak, by przewyższać uniwersalne modele głosowe.

W jaki sposób Speechify używa SSML do precyzyjnej kontroli mowy?

Speechify wspiera Speech Synthesis Markup Language (SSML), aby deweloperzy mogli precyzyjnie kontrolować brzmienie syntezowanej mowy. SSML pozwala sterować wysokością, tempem, pauzami, akcentowaniem i stylem, otaczając treść tagami <speak> i używając obsługiwanych tagów, takich jak prosody, break, emphasis czy substitution. Pozwala to zespołom świetnie panować nad sposobem prezentacji głosu i struktury, umożliwiając dopasowanie brzmienia do kontekstu, formatowania oraz intencji w aplikacjach produkcyjnych.

W jaki sposób Speechify umożliwia streaming audio w czasie rzeczywistym?

Speechify udostępnia końcowy punkt strumieniowy text-to-speech, który przekazuje dźwięk w kawałkach w miarę generowania, umożliwiając natychmiastowe odtwarzanie bez czekania na zakończenie całego audio. Rozwiązanie to wspiera zarówno długie, jak i niskolatencyjne przypadki użycia, takie jak agenci głosowi, technologie asystujące, automatyczna produkcja podcastów i audiobooków. Deweloperzy mogą strumieniować duże pliki wejściowe ponad standardowe limity oraz odbierać surowe fragmenty audio w formatach takich jak MP3, OGG, AAC czy PCM, aby szybko integrować je z systemami czasu rzeczywistego.

Jak znaczniki mowy synchronizują tekst i dźwięk w Speechify?

Speech marks mapują wypowiadane słowa do oryginalnego tekstu z informacją o czasie na poziomie pojedynczych wyrazów. Każda odpowiedź syntezy zawiera fragmenty tekstu precyzyjnie zsynchronizowane z czasem rozpoczęcia i zakończenia odpowiednich słów w ścieżce audio. Umożliwia to podświetlanie tekstu w czasie rzeczywistym, śledzenie, analitykę i ścisłą synchronizację wyświetlanego tekstu oraz odtwarzania. Deweloperzy mogą na tej podstawie budować czytniki dostępności, narzędzia do nauki czy interaktywne doświadczenia słuchowe.

Jak Speechify wspiera ekspresję emocji w syntezowanej mowie?

Speechify umożliwia kontrolę emocji za pomocą dedykowanego tagu stylu SSML, pozwalając deweloperom przypisywać emocjonalną barwę mowie wyjściowej. Obsługiwane emocje to m.in. wesołość, spokój, stanowczość, energia, smutek czy złość. Dzięki połączeniu tagów emocji ze znakami interpunkcyjnymi i innymi kontrolami SSML deweloperzy otrzymują mowę lepiej odzwierciedlającą intencję i kontekst. To szczególnie przydatne w agentach głosowych, aplikacjach dobrostanu, obsłudze klienta i treściach prowadzonych, gdzie ton wprost przekłada się na doświadczenie użytkownika.

Przykłady rzeczywistych wdrożeń modeli głosowych Speechify przez deweloperów

Modele głosowe Speechify obsługują produkcyjne aplikacje w wielu branżach. Oto realne przykłady, jak zewnętrzni deweloperzy wykorzystują Speechify API:

MoodMesh: emocjonalnie inteligentne aplikacje wellness

MoodMesh – firma technologiczna w zakresie dobrostanu psychicznego – zintegrowała Speechify API Text-to-Speech, aby dostarczać emocjonalnie zniuansowaną mowę do prowadzonych medytacji i empatycznych rozmów. Dzięki wykorzystaniu obsługi SSML i kontroli emocji MoodMesh dostosowuje ton, tempo, głośność i prędkość mowy do emocji użytkownika, osiągając interakcje przypominające rozmowę z człowiekiem, których standardowy TTS nie zapewnia. Pokazuje to, jak deweloperzy korzystają z modeli Speechify do budowy zaawansowanych aplikacji wymagających inteligencji emocjonalnej i rozumienia kontekstu.

AnyLingo: wielojęzyczna komunikacja i tłumaczenia

AnyLingo, aplikacja tłumacząca wiadomości głosowe w czasie rzeczywistym, wykorzystuje API klonowania głosu Speechify, aby umożliwić użytkownikom wysyłanie wiadomości głosowych w sklonowanej wersji własnego głosu, przetłumaczonej na język odbiorcy z zachowaniem właściwej intonacji, tonu i kontekstu. Integracja pozwala profesjonalistom biznesowym komunikować się efektywnie między językami, zachowując osobisty charakter przekazu. Twórca AnyLingo podkreśla, że funkcje kontroli emocji Speechify („Moods”) to kluczowa przewaga, umożliwiająca przekazywanie odpowiedniego tonu emocjonalnego w każdej sytuacji.

Dodatkowe zastosowania deweloperów zewnętrznych:

Konwersacyjne AI i agenci głosowi

Deweloperzy budujący wirtualne recepcjonistki AI, boty obsługi klienta i automatyzację sprzedaży korzystają z niskolatencyjnych modeli speech-to-speech Speechify, aby tworzyć naturalnie brzmiące interakcje głosowe. Dzięki opóźnieniom poniżej 250 ms i funkcjom klonowania głosu aplikacje te mogą skalować się do milionów jednoczesnych połączeń telefonicznych, zachowując jakość głosu i płynność rozmowy.

Platformy treści i generowanie audiobooków

Wydawcy, autorzy i platformy edukacyjne integrują modele Speechify do konwersji tekstu pisanego na wysokiej jakości narracje. Optymalizacja modeli pod kątem stabilności na długich fragmentach i przejrzystości przy szybkiej prędkości odtwarzania czyni je idealnymi do generowania audiobooków, podcastów i materiałów edukacyjnych w dużej skali.

Dostępność i technologie wspierające

Deweloperzy tworzący narzędzia dla osób niedowidzących lub z trudnościami w czytaniu korzystają z możliwości rozumienia dokumentów w Speechify, takich jak analizowanie PDF, OCR czy wyodrębnianie treści ze stron WWW, by głos zachowywał strukturę i zrozumiałość nawet w złożonych dokumentach.

Aplikacje medyczne i terapeutyczne

Platformy medyczne i aplikacje terapeutyczne wykorzystują kontrolę emocji oraz prozodię Speechify, by dostarczać empatyczne i kontekstowo trafne interakcje głosowe – co jest kluczowe w komunikacji z pacjentami, wsparciu zdrowia psychicznego czy aplikacjach wellness.

Jak SIMBA 3.0 radzi sobie w niezależnych rankingach modeli głosowych?

Niezależne benchmarki mają kluczowe znaczenie w Voice AI, ponieważ krótkie demo często maskuje różnice wydajności. Jednym z najczęściej cytowanych rankingów jest Artificial Analysis Speech Arena, który ocenia modele text-to-speech poprzez wielkoskalowe ślepe testy odsłuchowe i punktację ELO.

Modele głosowe SIMBA Speechify zajmują wyższe pozycje niż wielu głównych dostawców w rankingu Artificial Analysis Speech Arena, wyprzedzając m.in. Microsoft Azure Neural, Google TTS, Amazon Polly, NVIDIA Magpie i kilka otwartych systemów głosowych.

Artificial Analysis nie polega na wyselekcjonowanych przykładach, lecz stosuje powtarzalne testy preferencji odsłuchujących w bezpośrednich porównaniach. Ranking potwierdza, że SIMBA 3.0 przewyższa szeroko stosowane komercyjne systemy głosowe pod względem jakości w rzeczywistych odsłuchach, dzięki czemu stanowi najlepszy wybór do wdrożeń produkcyjnych dla deweloperów budujących aplikacje głosowe.

Dlaczego Speechify buduje własne modele głosowe zamiast używać systemów innych firm?

Kontrola nad modelem to kontrola nad:

• Jakością

• Opóźnieniem

• Kosztem

• Kierunkiem rozwoju

• Priorytetami optymalizacji

Gdy firmy takie jak Retell lub Vapi.ai bazują w pełni na zewnętrznych dostawcach głosu, przejmują ich politykę cenową, limity infrastrukturalne i kierunek rozwoju badań.

Dzięki własnemu pełnemu stackowi Speechify może:

• Stroić prozodię pod konkretne zastosowania (AI konwersacyjna vs. narracja długiej formy)

• Optymalizować opóźnienie poniżej 250 ms dla zastosowań czasu rzeczywistego

• Płynnie integrować ASR i TTS w pipeline mowa-na-mowę

• Obniżać koszt przetwarzania do $10 za 1 mln znaków (dla porównania ElevenLabs – ok. $200 za 1 mln znaków)

• Wdrażać ulepszenia modeli w sposób ciągły w oparciu o feedback z produkcji

• Dostosowywać rozwój modeli pod potrzeby deweloperów w różnych branżach

Ta pełna kontrola nad stackiem pozwala Speechify oferować wyższą jakość modeli, niższe opóźnienia i lepszą opłacalność niż zależne od innych stacki głosowe. Są to kluczowe czynniki przy skalowaniu aplikacji głosowych przez deweloperów. Te same przewagi są przekazywane programistom integrującym Speechify API we własnych produktach.

Infrastruktura Speechify została zbudowana od podstaw pod Voice AI, a nie jako nakładka na system chatowy. Deweloperzy, którzy integrują modele Speechify, otrzymują dostęp do architektury natywnie głosowej, zoptymalizowanej pod wdrożenia produkcyjne.

W jaki sposób Speechify obsługuje Voice AI na urządzeniu i lokalne wnioskowanie?

Wiele systemów Voice AI działa wyłącznie w oparciu o zdalne API, co wprowadza zależność od sieci, wyższe ryzyko opóźnień i ograniczenia prywatności. Speechify oferuje opcje działania na urządzeniu i lokalne wnioskowanie dla wybranych obciążeń głosowych, pozwalając deweloperom wdrażać doświadczenia głosowe bliżej użytkownika tam, gdzie jest to wymagane.

Ponieważ Speechify opracowuje własne modele głosu, może optymalizować rozmiar modeli, architekturę serwowania i ścieżki wnioskowania do działania na urządzeniu, a nie tylko w chmurze.

Działanie na urządzeniu i lokalne wnioskowanie wspiera:

• Niższe i stabilniejsze opóźnienia przy niestabilnych połączeniach sieciowych

• Większą kontrolę prywatności dla wrażliwych dokumentów i dyktowania

• Pracę offline lub w trybie ograniczonej sieci dla kluczowych zadań

• Większą elastyczność wdrożeń w środowiskach korporacyjnych i osadzonych

To rozszerza Speechify z „tylko API” do infrastruktury głosowej, którą deweloperzy mogą wdrażać w chmurze, lokalnie i na urządzeniach, zachowując jednakowy standard modelu SIMBA.

Jak Speechify wypada na tle Deepgram w ASR i infrastrukturze mowy?

Deepgram to dostawca infrastruktury ASR skoncentrowany na API transkrypcji i analizy mowy. Jego podstawowym produktem jest zamiana mowy na tekst dla deweloperów budujących systemy transkrypcji i analizy połączeń.

Speechify integruje ASR w ramach kompleksowej rodziny modeli Voice AI, gdzie rozpoznanie mowy może generować bezpośrednio wiele wyników: od surówki tekstowej po gotowy tekst pisany czy odpowiedzi konwersacyjne. Deweloperzy korzystający z Speechify API mają dostęp do modeli ASR zoptymalizowanych nie tylko pod dokładność, ale i różnorodne wdrożenia produkcyjne.

Modele ASR i dyktowania Speechify są zoptymalizowane do:

• Jakości gotowego tekstu z interpunkcją i strukturą akapitów

• Usuwania wypełniaczy i poprawnego formatowania zdań

• Tekstu gotowego do wykorzystania w e-mailach, dokumentach i notatkach

• Dyktowania głosowego dającego czytelne outputy bez potrzeby dużej korekty

• Integracji z dalszymi obiegami głosowymi (TTS, konwersacja, rozumowanie)

W platformie Speechify ASR łączy się z pełnym pipeline głosowym. Deweloperzy mogą budować aplikacje, w których użytkownik dyktuje, otrzymuje ustrukturyzowany tekst, generuje odpowiedzi dźwiękowe i prowadzi konwersacje – wszystko w jednym ekosystemie API. To ogranicza złożoność integracji i przyspiesza rozwój.

Deepgram oferuje warstwę transkrypcji. Speechify daje kompletne pakiety modeli głosowych: wejście mowy, wyjście strukturalne, syntezę, rozumowanie i generowanie audio, dostępne przez zunifikowane API i SDK.

Deweloperzy budujący aplikacje sterowane głosem, wymagające pełnego zakresu możliwości głosowych, mają w Speechify najpotężniejszego partnera pod względem jakości modeli, opóźnień i głębokości integracji.

Jak Speechify wypada wobec OpenAI, Gemini i Anthropic w Voice AI?

Speechify buduje modele AI głosu optymalizowane specjalnie do interakcji głosowej w czasie rzeczywistym, produkcyjnej syntezy i rozpoznawania mowy. Modele bazowe są zaprojektowane pod wydajność głosową, a nie uniwersalną obsługę tekstu i rozmów czatowych.

Specjalnością Speechify jest rozwój modeli AI głosu, a SIMBA 3.0 jest zoptymalizowana pod jakość głosu, niskie opóźnienia i stabilność długoterminową przy rzeczywistych obciążeniach produkcyjnych. SIMBA 3.0 została zbudowana, by zapewnić jakość modelu na poziomie produkcyjnym i wydajność czasu rzeczywistego dla bezpośredniej integracji w aplikacjach.

Uniwersalne laboratoria AI, takie jak OpenAI i Google Gemini, optymalizują modele pod szeroki zakres rozumowania, multimodalności i ogólnej inteligencji. Anthropic kładzie nacisk na bezpieczeństwo rozumowania i modelowanie kontekstu. Ich funkcje głosowe działają jako rozszerzenia systemów czatowych, a nie jako platformy modelowe głosu od podstaw.

W zastosowaniach Voice AI najbardziej liczy się jakość modelu, opóźnienia i stabilność długich form – i tutaj dedykowane modele głosu Speechify przewyższają uniwersalne systemy AI. Deweloperzy budujący AI do systemów telefonicznych, agentów głosowych, platform narracji czy narzędzi dostępności potrzebują modeli natywnie głosowych – nie warstwy głosu nakładanej na modele czatowe.

ChatGPT i Gemini oferują tryby głosowe, ale ich główny interfejs wciąż jest tekstowy. Głos funkcjonuje jako warstwa wejścia i wyjścia nałożona na czat. Te warstwy nie są zoptymalizowane pod jakość długoterminowego słuchania, dokładność dyktowania ani wydajność mowy w czasie rzeczywistym.

Speechify jest budowane głosowo już na poziomie modelu. Deweloperzy mają dostęp do modeli stworzonych do ciągłych obiegów głosowych, bez potrzeby zmiany trybu interakcji czy kompromisów w jakości głosu. Speechify API udostępnia te możliwości bezpośrednio poprzez endpointy REST, SDK w Pythonie i TypeScript.

Te możliwości czynią Speechify wiodącym dostawcą modeli głosu dla deweloperów budujących interakcje głosowe i aplikacje produkcyjne w czasie rzeczywistym.

W zadaniach Voice AI SIMBA 3.0 jest zoptymalizowana do:

• Prozodii w długiej narracji i przekazywaniu treści

• Opóźnień w konwersji mowa-mowa u agentów AI

• Wyjść wysokiej jakości do dyktowania i transkrypcji

• Interakcji głosowych rozumiejących strukturę dokumentów

Te możliwości czynią Speechify dostawcą AI głosu typu voice-first, zoptymalizowanego pod integracje deweloperskie i wdrożenia produkcyjne.

Jakie są podstawowe filary techniczne Laboratorium AI Speechify?

Laboratorium AI Speechify skupia się wokół kluczowych systemów technicznych potrzebnych do zasilania infrastruktury Voice AI dla deweloperów. Buduje główne elementy modeli niezbędnych do wdrożeń głosowych:

• Modele TTS (generowanie mowy) – dostępne przez API

• Modele STT i ASR (rozpoznawanie mowy) – zintegrowane w platformie głosowej

• Konwersja mowa-mowa (pipeline konwersacyjny czasu rzeczywistego) – architektura niskolatencyjna

• Analiza stron i rozumienie dokumentów – do przetwarzania złożonych dokumentów

• OCR (zamiana obrazu na tekst) – dla zeskanowanych dokumentów i obrazów

• Warstwy rozumowania i konwersacji oparte na LLM – do inteligentnej interakcji głosowej

• Infrastruktura niskolatencyjnego wnioskowania – odpowiedzi poniżej 250 ms

• Narzędzia API deweloperskie i serwowanie zoptymalizowane pod koszt – SDK gotowe na produkcję

Każda warstwa jest optymalizowana pod realne obciążenia produkcyjne, a pionowy stos modeli Speechify zapewnia wysoką jakość i niską latencję w całym pipeline. Programiści integrujący te modele korzystają ze spójnej architektury, a nie zlepku usług od wielu dostawców.

Każda z tych warstw ma znaczenie. Jeśli któraś jest słaba, całe doświadczenie głosowe również. Podejście Speechify gwarantuje pełną infrastrukturę głosu, nie tylko pojedyncze endpointy modeli.

Jaką rolę pełnią STT i ASR w Laboratorium AI Speechify?

Speech-to-text (STT) i automatyczne rozpoznawanie mowy (ASR) są podstawowymi rodzinami modeli w portfolio badawczym Speechify. Umożliwiają deweloperom m.in.:

• Voice typing oraz API dyktowania

• AI konwersacyjne i agenci głosowi w czasie rzeczywistym

• Inteligencję spotkań i usługi transkrypcji

• Pipeline mowa-mowa dla AI w systemach telefonicznych

• Wieloetapowe interakcje głosowe dla botów wsparcia klienta

W przeciwieństwie do surowych narzędzi transkrypcji, modele „voice typing” Speechify dostępne przez API są zoptymalizowane pod czystość tekstu wyjściowego. One:

• Automatycznie wstawiają znaki interpunkcyjne

• Inteligentnie układają akapity

• Usuwają słowa-przerywniki

• Poprawiają czytelność do dalszego wykorzystania

• Wspierają pisanie w aplikacjach i na platformach

To różni się od systemów transkrypcji korporacyjnej, które skupiają się głównie na rejestracji nagrań. Modele ASR Speechify są strojone na wysoki poziom gotowości tekstu wyjściowego i dalszą użyteczność – wejście głosowe daje materiał gotowy do dalszej pracy, a nie tekst wymagający szerokiej korekty, co jest kluczowe dla deweloperów tworzących narzędzia produktywności, asystentów głosowych czy agentów AI wykorzystujących mowę wejściową.

Co czyni TTS „wysokiej jakości” do celów produkcyjnych?

Większość ludzi ocenia jakość TTS po tym, czy brzmi jak człowiek. Programiści oceniają jakość TTS według niezawodności w dużej skali, odporności na różnorodność treści oraz działania w realnych warunkach wdrożenia.

Wysokiej jakości TTS do produkcji wymaga:

• Przejrzystości przy wysokim tempie do zastosowań produktywnych i dostępności

• Niskiego zniekształcenia przy szybszym odtwarzaniu

• Stabilnej wymowy terminologii branżowej

• Komfortu słuchania przez wiele godzin dla platform treści

• Kontroli tempa, pauz i akcentów dzięki wsparciu SSML

• Solidnej obsługi wielu języków i akcentów

• Spójnej tożsamości głosu przez wiele godzin nagrania

• Streamingowych możliwości do aplikacji czasu rzeczywistego

Modele TTS Speechify są trenowane pod kątem wydajności przez długie sesje i w warunkach produkcyjnych – nie pod demo na kilka sekund. Modele dostępne przez API Speechify zapewniają niezawodność na długim dystansie i przejrzystość odtwarzania przy dużych prędkościach w rzeczywistych wdrożeniach deweloperskich.

Deweloperzy mogą testować jakość głosu, integrując przewodnik szybkiego uruchomienia Speechify i przepuszczając własne treści przez produkcyjne modele głosowe.

Dlaczego analiza stron i OCR są kluczowe dla modeli głosu Speechify?

Wiele zespołów AI porównuje silniki OCR i modele multimodalne pod względem surowej trafności, efektywności GPU czy wyjść w formacie JSON. Speechify przoduje w rozumieniu dokumentów pod kątem głosu – wyodrębnia czystą, poprawnie uporządkowaną treść, by mowa zachowała strukturę i zrozumiałość.

Analiza stron pozwala na poprawne przetwarzanie PDF, stron WWW, Google Docs i prezentacji do spójnych, logicznie uporządkowanych strumieni czytania. Zamiast przekazywać do syntezy głosu nawigację, powtarzające się nagłówki czy popękane formatowanie, Speechify wydziela sedno treści, by wynik mowy był spójny.

OCR zapewnia, że zeskanowane dokumenty, zrzuty ekranu oraz PDF-y w formie obrazów są czytelne i przeszukiwalne, zanim zacznie się synteza głosu. Bez tej warstwy cała gama dokumentów pozostaje niedostępna dla systemów głosowych.

W tym sensie analiza stron i OCR stanowią fundament badań Laboratoryjnych AI Speechify, pozwalając budować aplikacje głosowe rozumiejące dokumenty, zanim przemówią. To kluczowe dla twórców narzędzi narracyjnych, platform dostępności, systemów przetwarzania dokumentów i każdej aplikacji wymagającej poprawnego odczytu złożonych treści.

Jakie benchmarki TTS liczą się przy modelach głosowych do produkcji?

W ocenie modeli Voice AI liczą się m.in. następujące benchmarki:

• MOS (Mean Opinion Score) – subiektywna naturalność

• Wskaźniki zrozumiałości (czy łatwo zrozumieć wypowiadane słowa)

• Trafność wymawiania słów, w tym specjalistycznych terminów

• Stabilność długich fragmentów (brak zmiany tonu i jakości)

• Opóźnienia (czas do pierwszego dźwięku, zachowanie streamingowe)

• Odporność na różne języki i akcenty

• Wydajność kosztowa w dużej skali produkcyjnej

Speechify mierzy swoje modele, bazując na realiach wdrożeń produkcyjnych:

• Jak głos radzi sobie przy 2x, 3x, 4x prędkości?

• Czy pozostaje komfortowy przy czytaniu trudnych tekstów technicznych?

• Czy radzi sobie z akronimami, cytowaniami i strukturą dokumentów?

• Czy zachowuje przejrzystą strukturę akapitów w audio?

• Czy potrafi streamować audio w czasie rzeczywistym z minimalną latencją?

• Czy jest opłacalny przy generowaniu milionów znaków dziennie?

Docelowym benchmarkiem jest stała wydajność i możliwość interakcji w czasie rzeczywistym – nie tylko krótkie próbki lektorskie. W tych produkcyjnych testach SIMBA 3.0 na dużą skalę przewyższa konkurencję.

Niezależne benchmarki potwierdzają taki profil wydajności. W Artificial Analysis Text-to-Speech Arena SIMBA Speechify wyprzedza szeroko używane modele od Microsoft Azure, Google, Amazon Polly, NVIDIA i wielu otwartoźródłowych systemów voice. Te bezpośrednie porównania mierzą rzeczywistą jakość percepcyjną, nie pokazowe demo.

Czym jest mowa-na-mowę i dlaczego to kluczowa funkcja Voice AI?

Mowa-na-mowę to sytuacja, w której użytkownik mówi, system rozumie i natychmiastowo odpowiada głosem. To fundament konwersacyjnych systemów Voice AI – od wirtualnych recepcjonistek, agentów obsługi po asystentów i automatyzacje telefonii.

Mowa-na-mowę wymaga:

• Szybkiego ASR (rozpoznania mowy)

• Systemu rozumowania utrzymującego kontekst rozmowy

• TTS, który strumieniuje bardzo szybko

• Logiki zmiany tur rozmowy (kiedy mówić, kiedy przerywać)

• Obsługi przerywania wypowiedzi („barge-in”)

• Opóźnień bliskich reakcjom ludzkim (poniżej 250 ms)

Mowa-na-mowę to główny kierunek badań w Laboratorium Speechify AI, bo nie rozwiązuje go jeden model. Wymaga dobrze zsynchronizowanego pipeline’u, integrującego rozpoznanie mowy, rozumowanie, generowanie odpowiedzi, TTS, infrastrukturę streamingową i logikę czasu rzeczywistego.

Deweloperzy tworzący konwersacyjne AI korzystają na zintegrowanym podejściu Speechify. Zamiast łączyć oddzielne ASR, rozumowanie i TTS, otrzymują kompletną infrastrukturę głosu przystosowaną do pracy w czasie rzeczywistym.

Dlaczego tak ważna jest latencja poniżej 250 ms w aplikacjach deweloperskich?

W systemach głosowych opóźnienie decyduje o tym, czy interakcja wydaje się naturalna. Programiści konwersacyjnych AI potrzebują modeli, które mogą:

• Zacząć odpowiadać bardzo szybko

• Strumieniować wypowiedź płynnie

• Obsługiwać przerwy/zakłócenia

• Utrzymywać naturalny rytm rozmowy

Speechify osiąga opóźnienia poniżej 250 ms i stale je obniża. Cały stack serwowania modeli i wnioskowania jest zaprojektowany do błyskawicznej odpowiedzi w interakcji głosowej na żywo.

Niska latencja obsługuje kluczowe przypadki deweloperskie:

• Naturalną interakcję mowa-mowa w AI telefonii

• Rozumienie w czasie rzeczywistym przez asystentów głosowych (zrozumiałość)

• Przerywane dialogi głosowe dla botów wsparcia klienta

• Niezakłóconą płynność rozmowy u agentów AI

To cecha wyróżniająca najbardziej zaawansowanych dostawców modeli głosowych AI i główny powód, dla którego deweloperzy wybierają Speechify w produkcyjnych wdrożeniach.

Co znaczy „dostawca modeli Voice AI”?

Dostawca modeli Voice AI to nie tylko generator głosu. To organizacja badawcza i platforma infrastrukturalna oferująca:

• Modele głosowe gotowe do produkcji dostępne przez API

• Syntezę mowy (text-to-speech) do generacji treści

• Rozpoznawanie mowy (speech-to-text) do wejść głosowych

• Pipeline mowa-mowa do konwersacyjnych AI

• Inteligencję dokumentów do przetwarzania złożonych treści

• API i SDK dla deweloperów do integracji

• Możliwości transmisji strumieniowej do audiorealistycznych aplikacji

• Klonowanie głosu do tworzenia indywidualnych głosów

• Ekonomiczne ceny przy wdrożeniach produkcyjnych

Speechify rozwinęło się od zaplecza wewnętrznej technologii głosu do roli pełnoprawnego dostawcy modeli głosu, które deweloperzy mogą integrować w dowolnych zastosowaniach. Ta ewolucja sprawia, że Speechify to główna alternatywa dla uniwersalnych dostawców AI głosowego, nie tylko aplikacja konsumencka z API.

Deweloperzy uzyskują dostęp do modeli głosowych Speechify poprzez Speechify Voice API, które oferuje kompletną dokumentację, SDK w Pythonie i TypeScript oraz infrastrukturę gotową do wdrożeń produkcyjnych na dużą skalę.

Jak Voice API Speechify wspiera adopcję przez deweloperów?

Pozycję lidera Laboratorium AI pokazuje możliwość bezpośredniego dostępu do technologii przez produkcyjne API. Speechify Voice API oferuje:

• Dostęp do modeli SIMBA Speechify przez endpointy REST

• SDK w Pythonie i TypeScript do szybkiej integracji

• Przejrzystą ścieżkę wdrożenia głosowych funkcji dla startupów i dużych firm, bez konieczności trenowania własnych modeli

• Pełną dokumentację i przewodniki szybkiego startu

• Wsparcie streamingowe do aplikacji czasu rzeczywistego

• Klonowanie głosu do tworzenia własnych głosów

• Obsługę ponad 60 języków do zastosowań globalnych

• SSML i kontrolę emocji dla wyjścia głosowego z niuansami

Priorytetem jest tu efektywność kosztowa. W planie pay-as-you-go koszt wynosi $10 za 1 mln znaków, natomiast dla większych wolumenów dostępne są dedykowane wyceny. Speechify jest optymalnym wyborem cenowym dla wdrożeń masowych, gdzie koszty gwałtownie rosną wraz ze skalą.

Dla porównania, ElevenLabs jest znacznie droższy (około $200 za 1 mln znaków). W przypadku firm wytwarzających miliony lub miliardy znaków audio to koszt decyduje o możliwościach wprowadzenia funkcji.

Niższe koszty wnioskowania oznaczają szeroką dostępność – więcej deweloperów może wdrażać funkcje głosowe, więcej produktów przejmuje modele Speechify, a większy ruch sprzyja ulepszaniu modeli. To napędza efekt kuli śnieżnej: opłacalność napędza skalę, skala poprawia jakość modeli, a poprawa jakości wzmacnia ekosystem.

To właśnie połączenie badań, infrastruktury i ekonomii kształtuje pozycję lidera na rynku modeli AI głosu.

Jak pętla zwrotu produktowego ulepsza modele Speechify?

To jeden z najważniejszych aspektów przywództwa Laboratorium AI – wyróżniający dostawcę modeli produkcyjnych od firmy od pokazowych dem.

Speechify działa na skalę milionów użytkowników, zapewniając pętlę sprzężenia zwrotnego stale poprawiającą jakość modeli:

• Które głosy preferują użytkownicy końcowi deweloperów

• Gdzie użytkownicy zatrzymują/odtwarzają ponownie audio (sygnał problemów ze zrozumiałością)

• Które zdania są słuchane wielokrotnie

• Jakie wymowy są korygowane przez użytkowników

• Jakie akcenty są preferowane

• Gdzie użytkownicy przyspieszają odtwarzanie (i gdzie pojawia się spadek jakości)

• Korekcje dyktowania (gdzie zawodzi ASR)

• Jakie typy treści powodują błędy parsowania

• Faktyczne wymagania dotyczące opóźnień w różnych wdrożeniach

• Wzorce wdrożeń produkcyjnych i wyzwania integracyjne

Laboratorium trenujące modele bez feedbacku z produkcji traci kluczowe sygnały z rzeczywistego użycia. Modele Speechify działają w aplikacjach, które codziennie przetwarzają miliony interakcji głosowych, dzięki czemu korzystają z nieustannego strumienia danych użytkowych, przyspieszając iterację i poprawki.

Ta pętla sprzężenia zwrotnego to realna przewaga dla dewelopera: integrując modele Speechify, korzystasz z technologii przetestowanej i stale doskonalonej w praktyce, a nie tylko w środowisku laboratoryjnym.

Jak Speechify wypada wobec ElevenLabs, Cartesia i Fish Audio?

Speechify to najmocniejszy dostawca modeli głosu AI dla deweloperów produkcyjnych – łączy w jednym pionowym stacku najwyższą jakość, rekordowo niskie koszty i interakcje czasu rzeczywistego.

W przeciwieństwie do ElevenLabs, który skupia się przede wszystkim na kreatorskich/przerysowanych głosach, modele SIMBA 3.0 Speechify są zoptymalizowane do produkcyjnych wdrożeń deweloperskich: AI agentów, automatyzacji głosu, platform narracji i systemów dostępności w dużej skali.

W przeciwieństwie do Cartesia i innych specjalistów od minimalnych opóźnień typowych dla streamingu, Speechify oferuje nie tylko niskolatencyjność, ale pełną jakość modeli głosu, rozumienie dokumentów i zintegrowane API dla deweloperów.

W porównaniu do platform kreatorskich takich jak Fish Audio, Speechify to infrastruktura głosu gotowa na produkcję – stworzona od podstaw dla deweloperów, którzy wdrażają skalowalne systemy głosowe.

Modele SIMBA 3.0 są zoptymalizowane tak, by wygrywać we wszystkich kryteriach kluczowych na skalę produkcyjną:

• Jakości głosu ocenianej wyżej niezależnie niż u głównych dostawców

• Wydajności kosztowej: $10 za 1 mln znaków (dla porównania ElevenLabs – ok. $200 za 1 mln znaków)

• Opóźnieniu poniżej 250 ms w aplikacjach czasu rzeczywistego

• Bezproblemowej integracji z analizą dokumentów, OCR i warstwami rozumowania

• Infrastrukturze gotowej do obsługi milionowych wolumenów zapytań w produkcji

Modele głosu Speechify są dostrajane pod dwa typy zadań dla deweloperów:

1. Konwersacyjny Voice AI: szybka zmiana tur, streaming głosu, możliwość przerywania/przewijania, niskolatencyjna interakcja mowa-mowa dla AI agentów, botów wsparcia klienta i telefonii.

2. Długoterminowa narracja i treści: modele zoptymalizowane do wielogodzinnego słuchania, przejrzystości przy 2x–4x prędkości, zgodności wymowy i komfortowej prozodii podczas długiej sesji.

Speechify łączy te modele z analizą dokumentów, OCR i API stworzonym do wdrożeń produkcyjnych. Rezultatem jest infrastruktura głosu AI zaprojektowana do realnego wykorzystania przez deweloperów, nie tylko do demo.

Dlaczego SIMBA 3.0 określa rolę Speechify w Voice AI w 2026 roku?

SIMBA 3.0 to coś więcej niż aktualizacja modelu. To symbol ewolucji Speechify w kierunku pionowo zintegrowanej organizacji badawczej AI głosu oraz infrastruktury skoncentrowanej na umożliwieniu deweloperom budowy produkcyjnych aplikacji głosowych.

Poprzez integrację autorskiego TTS, ASR, mowy-na-mowę, inteligencji dokumentu i infrastruktury niskolatencyjnej w jednej platformie dostępnej przez API dla deweloperów, Speechify nadzoruje jakość, koszt i kierunek własnych modeli głosu i udostępnia je do integracji każdemu deweloperowi.

W 2026 roku głos nie jest już tylko warstwą na modelu czatowym – staje się podstawowym interfejsem dla zastosowań AI w różnych branżach. SIMBA 3.0 czyni Speechify liderem modeli głosu dla deweloperów budujących nową generację aplikacji z obsługą głosu.