Speechify объявляет о раннем запуске SIMBA 3.0 — нового поколения своих производственных голосовых ИИ-моделей, которые теперь доступны избранным сторонним разработчикам через Speechify Voice API, а полный открытый релиз намечен на март 2026 года. Разработанная лабораторией Speechify AI Research Lab, SIMBA 3.0 обеспечивает высокое качество синтеза речи, распознавания речи и преобразования речи в речь — эти возможности разработчики могут напрямую встраивать в собственные продукты и платформы.

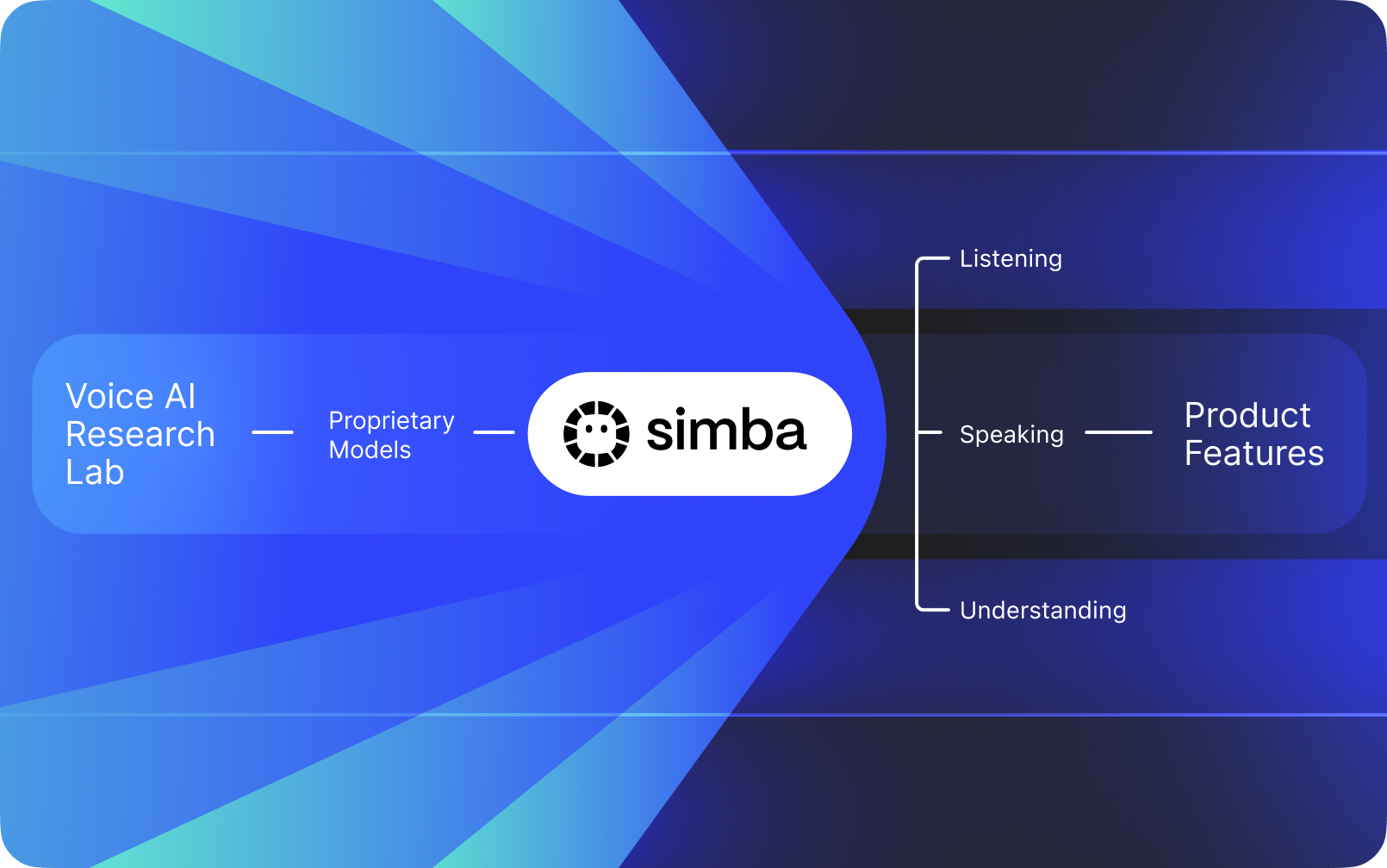

Speechify — это не голосовой интерфейс, наложенный поверх ИИ других компаний. Компания развивает собственную лабораторию по созданию уникальных голосовых моделей. Эти модели продаются сторонним разработчикам и компаниям через Speechify API для использования в любых приложениях: от ИИ-ассистентов и чат-ботов поддержки до контентных платформ и инструментов доступности.

Speechify также использует эти же модели в собственных пользовательских продуктах и параллельно предоставляет доступ к ним разработчикам через Speechify Voice API. Это важно, потому что качество, скорость работы, стоимость и стратегическое развитие голосовых моделей Speechify определяются внутренней исследовательской командой, а не сторонними поставщиками.

Голосовые модели Speechify изначально создаются под реальные производственные задачи и обеспечивают высочайшее качество в масштабе. Сторонние разработчики получают доступ к SIMBA 3.0 и голосовым моделям Speechify напрямую через Speechify Voice API — с REST-эндпоинтами под продакшн-нагрузки, полной документацией по API, быстрыми стартовыми гайдами для разработчиков и официально поддерживаемыми SDK на Python и TypeScript. Платформа Speechify для разработчиков спроектирована для быстрой интеграции, вывода в продакшн и масштабируемой голосовой инфраструктуры, позволяя командам пройти путь от первого API-запроса до запуска живых голосовых функций максимально быстро.

В этой статье объясняется, что такое SIMBA 3.0, что создает Speechify AI Research Lab, и почему Speechify предлагает высочайшее качество голосовых моделей ИИ, минимальную задержку и отличную экономическую эффективность для продакшн-нагрузок разработчиков — закрепляя статус ведущего провайдера голосового ИИ и опережая других поставщиков ИИ для голоса и мультимодальности, таких как OpenAI, Gemini, Anthropic, ElevenLabs, Cartesia и Deepgram.

Что значит называть Speechify исследовательской лабораторией ИИ?

Лаборатория искусственного интеллекта — это специализированная научно-инженерная организация, где специалисты по машинному обучению, анализу данных и вычислительному моделированию разрабатывают, обучают и внедряют интеллектуальные системы нового уровня. Когда говорят «исследовательская лаборатория ИИ», обычно имеют в виду организацию, совмещающую два направления:

1. Самостоятельная разработка и обучение собственных моделей

2. Предоставление этих моделей разработчикам через продакшн API и SDK

Некоторые организации отлично создают модели, но не предоставляют их сторонним разработчикам. Другие дают API, но в основном используют сторонние модели. Speechify управляет полностью вертикализированным стеком голосового ИИ: строит свои модели и предоставляет их сторонним разработчикам по открытому API, одновременно применяя их в собственных продуктах для масштабного подтверждения качества в реальных условиях.

AI Research Lab Speechify — это внутренняя исследовательская организация, сосредоточенная на голосовых технологиях. Ее миссия — развивать системы синтеза речи, автоматического распознавания речи и конвертации речи в речь, чтобы разработчики могли создавать голосовые приложения любой сферы: от ИИ-ассистентов и голосовых агентов до движков начитки и инструментов доступности.

Настоящая лаборатория голосового ИИ обычно должна решать задачи:

• Качество и естественность синтеза речи для внедрения в продакшн

• Точность распознавания речи и ASR на разных акцентах и при шуме

• Низкая задержка для диалогового общения в AI-агентах

• Стабильность на длинных текстах для длительного прослушивания

• Понимание документов для обработки PDF, веб-страниц и структурированных материалов

• OCR и разметка страниц для сканированных документов и изображений

• Продуктовая обратная связь, чтобы модели со временем улучшались

• Инфраструктура для разработчиков, предоставляющая голосовые функции через API и SDK

AI Research Lab Speechify создает эти системы как единую архитектуру и делает их доступными для разработчиков через Speechify Voice API — для интеграции в любые внешние платформы и приложения.

Что такое SIMBA 3.0?

SIMBA — это собственная линейка голосовых ИИ-моделей Speechify, которые используются как в продуктах компании, так и предлагаются сторонним разработчикам через Speechify API. SIMBA 3.0 — новейшее поколение семейства, оптимизированное для голосовых задач, высокой скорости и работы в реальном времени и доступное сторонним разработчикам для интеграции в свои платформы.

SIMBA 3.0 разработана для выдающегося качества голоса, быстрой реакции и стабильности при длительном прослушивании в производственном масштабе, давая разработчикам возможности создавать профессиональные голосовые приложения для различных отраслей.

Для сторонних разработчиков SIMBA 3.0 открывает решения для следующих задач:

• Голосовые ИИ-агенты и диалоговые ИИ-системы

• Автоматизация поддержки клиентов и ИИ-операторы

• Системы исходящих звонков для продаж и сервисов

• Голосовые ассистенты и приложения преобразования речи в речь

• Платформы для озвучивания контента и генерации аудиокниг

• Инструменты доступности и вспомогательные технологии

• Образовательные платформы с обучением через голос

• Медицинские приложения, требующие эмпатичного голосового взаимодействия

• Многоязычные приложения перевода и коммуникации

• Голосовые IoT-системы и автомобильные решения

Когда пользователи говорят, что голос «звучит как человек», они имеют в виду сочетание нескольких технических элементов:

- Просодия (ритм, интонация, ударения)

- Темп, учитывающий смысл

- Естественные паузы

- Стабильное произношение

- Интонационные сдвиги, соответствующие синтаксису

- Эмоциональная нейтральность при необходимости

- Выразительность, когда это уместно

SIMBA 3.0 — это слой модели, который разработчики встраивают, чтобы голосовые сценарии воспринимались естественно при высокой скорости, на длительных сессиях и для разных типов контента. Для производственных задач — от ИИ-телефонии до контентных платформ — SIMBA 3.0 оптимизирована, чтобы превосходить универсальные голосовые решения.

Как Speechify использует SSML для точного управления речью?

Speechify поддерживает язык разметки синтеза речи (SSML), позволяя разработчикам точно управлять звучанием синтезированной речи. SSML позволяет регулировать высоту тона, скорость речи, паузы, акценты и стилистику с помощью обертывания контента в теги <speak> и специальных тегов (prosody, break, emphasis, substitution и др.). Это дает командам тонкий контроль над подачей и структурой, помогая голосу максимально соответствовать контексту, форматированию и задаче в рабочих приложениях.

Как Speechify обеспечивает потоковую передачу аудио в реальном времени?

Speechify предоставляет потоковый синтезатор речи, который отправляет аудиочасти по мере их генерации, позволяя сразу запускать воспроизведение, не дожидаясь завершения всей генерации. Это критично для длинных и низколатентных кейсов: голосовые агенты, вспомогательные технологии, автоматическое создание подкастов, генерация аудиокниг. Разработчики могут передавать большие объемы текста и получать аудиофрагменты сразу в форматах MP3, OGG, AAC, PCM — что упрощает интеграцию в потоковые системы.

Как синхронизируются текст и аудио в Speechify с помощью speech marks?

Speech marks сопоставляют воспроизводимое аудио с исходным текстом с точной тайминг-информацией по каждому слову. Каждый ответ синтеза содержит синхронизированные фрагменты текста, показывающие, когда конкретные слова начинаются и заканчиваются в аудиопотоке. Это позволяет реализовать подсветку текста в реальном времени, точный поиск по слову или фразе, аналитику и синхронизацию озвучки с экраном. Разработчики могут строить доступные ридеры, обучающие приложения и интерактивные сценарии прослушивания.

Как Speechify реализует эмоциональную выразительность синтетической речи?

Speechify реализует Emotion Control с помощью специального SSML-тега стиля, позволяющего разработчикам задавать эмоциональный тон речи. Поддерживаются эмоции: жизнерадостность, спокойствие, уверенность, энергия, грусть, злость и другие. Комбинируя теги эмоций с пунктуацией и контролем SSML, можно добиваться более точного соответствия между тоном и контекстом. Это особенно полезно для голосовых агентов, приложений wellbeing, поддержки клиентов и контента, где важен тон взаимодействия.

Реальные сценарии использования голосовых моделей Speechify

Голосовые модели Speechify используются в продакшн-приложениях различных отраслей. Вот реальные примеры применения сторонними разработчиками Speechify API:

MoodMesh: Эмоционально интеллектуальные wellness-приложения

MoodMesh — компания в сфере технологий благополучия — внедрила Speechify Text-to-Speech API, чтобы обеспечить эмоционально точную речь для медитаций и сочувственных диалогов. Используя поддержку SSML и управление эмоциями, MoodMesh регулирует тон, темп, громкость и скорость голоса в зависимости от эмоционального состояния пользователя, создавая более человечное взаимодействие, недоступное обычным TTS. Это пример того, как разработчики используют Speechify модели для построения сложных эмоционально-интеллектуальных решений.

AnyLingo: Многоязычная коммуникация и перевод

AnyLingo — мессенджер для переводов в реальном времени — использует API для клонирования голоса Speechify, чтобы пользователи могли отправлять голосовые сообщения своим голосом, но уже на языке получателя — с правильной интонацией, тоном и учетом контекста. Это позволяет бизнес-пользователям общаться эффективно, сохраняя личную идентичность сообщения. Основатель AnyLingo отмечает, что функция контроля эмоций Speechify («Moods») — ключевое конкурентное преимущество для передачи нужного эмоционального тона в любой ситуации.

Другие сценарии использования сторонними разработчиками:

Диалоговые ИИ и голосовые агенты

Разработчики, создающие ИИ-операторов для приема звонков, поддержки и автоматизации продаж, используют низколатентные модели speech-to-speech Speechify для создания живых, естественных голосовых диалогов. С задержкой менее 250 мс и возможностью клонирования голоса такие приложения легко масштабируются до миллионов одновременных звонков без потери качества голоса и диалоговой структуры.

Контентные платформы и генерация аудиокниг

Издатели, авторы и образовательные платформы интегрируют модели Speechify для превращения письменного текста в высококачественную озвучку. Оптимизация моделей для стабильности на длинных текстах и чистоты звучания на высокой скорости делает их идеальными для генерации аудиокниг, подкастов и образовательных материалов в больших объемах.

Доступность и вспомогательные технологии

Разработчики, создающие инструменты для слабовидящих и людей с дислексией, используют способность Speechify к анализу документов, включая парсинг PDF-файлов, OCR и извлечение веб-контента, чтобы голосовой вывод сохранял структуру и понимание даже на сложных документах.

Медицинские и терапевтические приложения

Медицинские платформы и терапевтические решения используют функции управления эмоциями и просодией Speechify для передачи эмпатичных, уместных голосовых взаимодействий, что критически важно для общения с пациентами, поддержки ментального здоровья и wellness-приложений.

Как SIMBA 3.0 показывает себя на независимых рейтингах голосовых моделей?

Независимые бенчмарки важны в голосовом ИИ, потому что короткие демо не раскрывают всех проблем. Один из наиболее известных рейтингов сторонних платформ — Artificial Analysis Speech Arena, где оценивается качество моделей синтеза речи на основании масштабных слепых сравнительных прослушиваний и рейтинга ELO.

Голосовые модели SIMBA Speechify занимают места выше многих крупных провайдеров на Artificial Analysis Speech Arena, включая Microsoft Azure Neural, Google TTS, Amazon Polly, NVIDIA Magpie и ряд моделей с открытым весом.

Вместо использования подготовленных примеров Artificial Analysis применяет многократное сравнение пар моделей на реальных сэмплах в формате head-to-head. Такой рейтинг подтверждает, что SIMBA 3.0 опережает распространенные коммерческие системы, выигрывая по качеству моделей в реальных прослушиваниях, что делает ее лучшим решением для production-приложений.

Почему Speechify разрабатывает собственные голосовые модели, а не использует сторонние системы?

Контроль над моделью — это контроль над:

• Качеством

• Задержкой

• Стоимостью

• Стратегией развития

• Приоритетами оптимизации

Когда компании вроде Retell или Vapi.ai полностью зависят от сторонних голосовых провайдеров, они вынуждены подстраиваться под их ценовую политику, инфраструктурные ограничения и направление исследований.

Имея полный стек под собственным контролем, Speechify может:

• Настраивать просодию под конкретные задачи (диалоговый ИИ против длинного озвучивания)

• Снижать задержку до 250 мс для приложений в реальном времени

• Бесшовно объединять ASR и TTS в конвейеры речи в речь

• Снижать стоимость до $10 за 1M знаков (против примерно $200 у ElevenLabs за тот же объем)

• Постоянно выпускать улучшения модели на основе production-фидбэка

• Согласовывать развитие моделей с потребностями разработчиков в разных индустриях

Такой полный контроль позволяет Speechify обеспечивать высшее качество моделей, меньшую задержку и лучшую экономику, чем голосовые решения на сторонних API. Это критично для масштабирования. Теми же преимуществами пользуются и сторонние разработчики, интегрирующие Speechify API в свои продукты.

Инфраструктура Speechify изначально строилась вокруг голоса — это не поверхностный голосовой слой к чат-системам. Разработчики сторонних продуктов получают нативную голосовую архитектуру, сразу заточенную под продакшн.

Как Speechify поддерживает голосовой ИИ и вычисления на устройстве?

Многие голосовые ИИ-системы работают только через удалённые API, что добавляет зависимость от сети, повышенную задержку и ограничения по приватности. Speechify предлагает варианты вычислений на устройстве и локальном сервере для выбранных голосовых задач, давая разработчикам возможность развертывать голосовые сценарии на стороне пользователя, когда это необходимо.

Поскольку Speechify создает собственные голосовые модели, компания оптимизирует размер модели, архитектуру сервинга и маршруты вычислений для работы не только в облаке, но и на устройстве.

Вычисления на устройстве и локальный inference позволяют:

• Меньшую и более стабильную задержку при нестабильном интернете

• Лучшую защиту приватности для чувствительных документов и диктовки

• Офлайн-работу или сохранность рабочего процесса при слабой сети

• Гибкую интеграцию для корпоративных и встраиваемых сценариев

Это расширяет Speechify от «голоса через API» до голосовой инфраструктуры, которую разработчики могут запускать в облаке, локально и на устройствах, сохраняя единый стандарт модели SIMBA.

Чем Speechify отличается от Deepgram в ASR и голосовой инфраструктуре?

Deepgram — это инфраструктурный провайдер ASR, специализирующийся на API для транскрипции и анализа разговоров. Основной продукт: распознавание речи в текст для приложений по транскрипции и анализу звонков.

Speechify интегрирует ASR в собственное семейство голосовых ИИ-моделей, где распознавание речи позволяет создавать не только простые расшифровки, но и структурированные тексты, диалоговые ответы и многоуровневую обработку. Разработчики, использующие Speechify API, получают ASR-модели, оптимизированные под разнообразные продакшн-задачи, а не только под точность стенограммы.

ASR и диктовочные модели Speechify оптимизированы для:

• Качества итогового текста с пунктуацией и абзацами

• Удаления слов-паразитов и оформления предложений

• Готовых черновиков для email, документов и заметок

• Голосового ввода с чистым выходом и минимальной доработкой

• Интеграции с дальнейшими голосовыми сценариями (TTS, диалоги, рассуждения)

В платформе Speechify ASR интегрируется во все голосовые конвейеры. Разработчики могут строить приложения, где пользователь диктует, получает структурированный текст, генерирует голосовой ответ и ведет разговор — все внутри единой API-экосистемы. Это упрощает интеграцию и ускоряет разработку.

Deepgram — это слой транскрипции. Speechify — это полный стек голосовой модели: ввод речи, структурированный текст, синтез, рассуждение и генерация аудио через единые API и SDK.

Разработчикам, которые создают голосовые приложения с требованием сквозных голосовых функций, Speechify предлагает лучшие решения по качеству моделей, задержке и глубине интеграции.

Чем Speechify отличается от OpenAI, Gemini и Anthropic в голосовом ИИ?

Speechify создает голосовые ИИ-модели, оптимизированные для интерактивного голосового взаимодействия в реальном времени, многопоточного синтеза речи и рабочих процессов распознавания. Базовые модели специально настраиваются на качество голоса, а не просто на чат или текстовые задачи.

Специализация Speechify — именно разработка голосовых ИИ-моделей, и SIMBA 3.0 оптимизирована под качество голоса, низкую задержку и стабильность на длинных текстах для настоящих production-нагрузок. SIMBA 3.0 рассчитана на промышленное качество голосовых моделей и мгновенное взаимодействие, доступное напрямую через интеграцию.

Универсальные AI-лаборатории вроде OpenAI и Google Gemini настраивают свои модели преимущественно на широкую логику, мультимодальность и задачи общего ИИ. Anthropic фокусируется на безопасных рассуждениях и длинных контекстах. Их голосовые функции — это скорее расширения чат-систем, а не самостоятельные голосовые платформы.

Для голосовых задач важнее качество модели, задержка и стабильность на длинных треках, и здесь специализированные модели Speechify существенно превосходят универсальные системы. Разработчикам голосового ИИ для телефонии, озвучки и доступности нужны именно нативные голосовые модели, а не просто голосовые надстройки над чатами.

ChatGPT и Gemini предлагают голосовой режим, но основной их интерфейс остается текстовым. Голос работает лишь как слой ввода-вывода поверх чата. Эти голосовые слои не столь глубоко оптимизированы по качеству длительного прослушивания, точности диктовки или производительности в реальном времени.

Speechify создавался как голосовая платформа на уровне модели. Разработчики получают доступ к моделям, спроектированным для непрерывных голосовых сценариев, без необходимости менять тип интерфейса или жертвовать качеством речи. Speechify API открывает эти возможности через REST, Python SDKs и TypeScript SDKs.

Все это делает Speechify лидером среди провайдеров голосовых моделей для разработчиков, создающих голосовые приложения и взаимодействие в реальном времени.

В рабочих процессах голосового ИИ SIMBA 3.0 оптимизирована для:

• Просодии при долгом озвучивании и подаче контента

• Задержки speech-to-speech для диалоговых ИИ-агентов

• Выхода уровня диктовки для голосового ввода и транскрипции

• Взаимодействия с вниманием к структуре документов

Все эти особенности делают Speechify поставщиком ИИ-голоса с фокусом на разработчиков и продакшн.

Каковы ключевые технические направления AI Research Lab Speechify?

AI-лаборатория Speechify фокусируется на технических системах, необходимых для построения производственной голосовой инфраструктуры для разработчиков. Она создает основные компоненты для комплексной работы голосового ИИ:

• TTS-модели (синтез речи) — доступны по API

• STT и ASR-модели (распознавание речи) — интегрированы в голосовую платформу

• Speech-to-speech (конвейеры диалога в реальном времени) — низколатентная архитектура

• Разметка страниц и понимание документов — для обработки сложных документов

• OCR (распознавание текста на изображениях) — для сканов документов и изображений

• Слой рассуждений и диалогов на базе LLM — для интеллектуального голосового взаимодействия

• Инфраструктура быстрых инференсов — время ответа до 250 мс

• Инструменты API и оптимизированная по цене подача — production SDK

Каждый слой оптимизирован под рабочие задачи с голосом, а интегрированный стек моделей Speechify обеспечивает высокое качество и низкую задержку по всей цепочке. Разработчики, интегрирующие эти модели, получают целостную архитектуру вместо разнородных сервисов.

Каждый из этих слоев важен: если хотя бы один недостаточно хорош — в целом голосовое взаимодействие кажется слабым. Подход Speechify гарантирует целостную голосовую инфраструктуру, а не только отдельные модели.

Какую роль играют STT и ASR в AI Research Lab Speechify?

Speech-to-text (STT) и автоматическое распознавание речи (ASR) — ключевые семейства моделей в портфеле Speechify. Они реализуют кейсы для разработчиков, такие как:

• Голосовой ввод и диктовка через API

• Диалоговый ИИ и голосовые агенты в реальном времени

• Сервисы интеллектуальных собраний и автоматической расшифровки

• Конвейеры speech-to-speech для AI-телефонии

• Многоходовые голосовые сценарии для поддержки клиентов

В отличие от простых расшифровщиков, модели голосового ввода Speechify по API оптимизированы под чистый текст. Они:

• Автоматически расставляют пунктуацию

• Интеллектуально структурируют абзацы

• Удаляют слова-паразиты

• Повышают чистоту текста для дальнейшей обработки

• Поддерживают создание текста в разных приложениях и на разных платформах

Это отличает их от корпоративных транскрипторов, нацеленных в основном на захват текста. ASR-модели Speechify настроены на итоговое качество и удобство использования — голосовой ввод превращается в черновики, а не в текст, требующий доработок. Это критично для инструментов продуктивности, голосовых ассистентов или ИИ-агентов, реагирующих на речь.

Что делает TTS «высококачественным» для рабочих задач?

Большинство людей оценивает TTS по «человечности» звучания. А разработчики production-приложений — по надежности в масштабе, разнообразии контента и устойчивости в реальных условиях развертывания.

Качественный продакшн-TTS требует:

• Четкости на высокой скорости — для продуктивности и доступности

• Минимальных искажений на больших скоростях воспроизведения

• Стабильности произношения терминов в конкретных областях

• Комфортного прослушивания на протяжении долгих сессий (контент-платформы)

• Управления темпом, паузами и акцентами через SSML

• Многоязычного и акцентного охвата

• Стабильной идентичности голоса на протяжении часов аудио

• Стриминга для сценариев реального времени

Модели TTS Speechify обучаются на больших сессиях и продакшн-нагрузках, а не на коротких демо. Доступные по Speechify API модели рассчитаны на надежность при длительном воспроизведении и чистоту звучания на высоких скоростях прямо в продакшне.

Разработчики могут протестировать качество голоса, интегрировав быстрый старт Speechify и прогнав свой контент через настоящие production-модели.

Почему разметка страниц и OCR важны для моделей голосового ИИ Speechify?

Многие команды ИИ сравнивают OCR-движки и мультимодальные модели по точности, эффективности на GPU или структуре вывода (JSON). Speechify делает акцент на голосовом понимании документов: извлекает чистый, структурированный контент, чтобы голосовой вывод сохранял структуру и понятность.

Разметка страниц гарантирует, что PDF, веб-страницы, Google Docs и презентации превращаются в чистый, логически упорядоченный поток для чтения. Вместо озвучки навигационных меню и «сломанных» блоков разметки Speechify выделяет только значимый текст.

OCR обеспечивает, чтобы сканированные документы, скриншоты и «картинные» PDF становились читаемыми и искомыми перед синтезом речи. Без этого слоя многие документы были бы недоступны для озвучки.

Таким образом, разметка страниц и OCR — фундаментальные направления в AI Research Lab Speechify, позволяющие разработчикам создавать голосовые приложения, которые «понимают» документы ещё до озвучивания. Это критично для начитки, платформ доступности, обработки документов и любых задач, где нужна корректная озвучка сложного контента.

Какие TTS-бенчмарки действительно важны для production-моделей?

В оценке голосовых моделей обычно учитывают:

• MOS (средний оценочный балл) за «естественность» речи

• Понятность — насколько слова легко воспринимаются на слух

• Точность произношения, включая специализированные термины

• Стабильность звучания на длинных текстах (отсутствие «дрейфа» тембра)

• Задержка (время до начала аудио, потоковая работа)

• Устойчивость работы на разных языках и акцентах

• Экономическую эффективность при масштабном использовании

Speechify бенчмаркет свои модели на основании реального продакшн-использования:

• Как звучит голос на скорости 2x, 3x, 4x?

• Комфортен ли он для плотного технического текста?

• Корректно ли читает аббревиатуры, ссылки и структурированные документы?

• Сохраняется ли структура абзацев в аудиовыходе?

• Может ли модель стримить аудио почти без задержек?

• Экономичен ли синтез при генерации миллионов символов ежедневно?

Целевой бенчмарк — устойчивое качество и возможность работы в реальном времени, а не просто демо-озвучка. По этим параметрам SIMBA 3.0 спроектирована, чтобы быть лидером для реальных масштабов.

Независимые рейтинги подтверждают это. В Artificial Analysis Text-to-Speech Arena SIMBA занимает позиции выше распространенных моделей от Microsoft Azure, Google, Amazon Polly, NVIDIA и других open-weight решений. Head-to-head сравнения по предпочтениям слушателей отражают реальное восприятие качества, а не просто демо.

Что такое речь-в-речь и почему это ключевая функция голосового ИИ для разработчиков?

Речь-в-речь — это когда пользователь говорит, система понимает и отвечает голосом, желательно в реальном времени. Это основа техники диалоговых ИИ — от ассистентов и операторов до автоматизированных звонков.

Для speech-to-speech необходимы:

• Быстрый ASR (распознавание речи)

• Механизм рассуждений, ведущий диалог

• Логика смены реплик (когда говорить, когда слушать)

• Обработка перебиваний (barge-in)

• Задержка, близкая к человеческой (до 250 мс)

Speech-to-speech — базовая область исследований в Speechify AI Research Lab, так как её нельзя решить одной моделью. Требуется четко согласованный процесс распознавания, рассуждения, генерации ответов, синтеза речи, потоковой передачи и реакции на реплики в реальном времени.

Разработчики диалоговых ИИ получают выгоду от интегрированного подхода Speechify. Вместо склейки отдельных ASR, движков рассуждений и TTS можно использовать единую голосовую инфраструктуру для диалога в реальном времени.

Почему для приложений важна задержка менее 250 мс?

В голосовых системах уровень задержки определяет, будет ли общение восприниматься естественно. Разработчики диалоговых ИИ нуждаются в моделях, которые могут:

• Начинать ответ очень быстро

• Потоково выводить речь без пауз

• Обрабатывать перебивания

• Поддерживать естественный темп диалога

Speechify достигает задержки менее 250 мс и продолжает оптимизировать этот показатель. Система сервинга и инференса моделей рассчитана именно на быстрый диалоговый отклик под непрерывным голосовым взаимодействием.

Низкая задержка закрывает ключевые запросы разработчиков:

• Натуральную речь-в-речь в ИИ-телефонии

• Мгновенное понимание для голосовых ассистентов

• Диалоги с прерыванием для клиентских чат-ботов

• Бесшовное общение AI-агента

Это — ключевая характеристика продвинутых поставщиков голосового ИИ и причина, по которой разработчики выбирают Speechify для внедрения production-решений.

Что значит «поставщик моделей голосового ИИ»?

Поставщик моделей голосового ИИ — это не просто генератор голоса. Это исследовательская и инфраструктурная платформа, предлагающая:

• Готовые производственные голосовые модели через API

• Синтез речи (text-to-speech) для генерации контента

• Распознавание речи (speech-to-text) для ввода голосом

• Конвейеры речи в речь для диалогового ИИ

• Интеллект документов для обработки сложного контента

• API и SDK для быстрой интеграции у разработчиков

• Поддержку стриминга для приложений в реальном времени

• Клонирование голоса для создания «своих» голосов

• Экономичное ценообразование для production-использования

Speechify прошёл путь от поставщика собственной речевой технологии до полноценного поставщика голосовых моделей для интеграции в любые приложения. Эта эволюция объясняет, почему Speechify — ключевая альтернатива универсальным AI-провайдерам для голосовых задач, а не просто потребительское приложение с API.

Разработчики получают доступ к моделям Speechify через Speechify Voice API с полной документацией, SDK на Python и TypeScript и продакшн-инфраструктурой для масштабного внедрения.

Как Speechify Voice API способствует принятию разработчиками?

Роль AI Research Lab подтверждается на практике, когда разработчики могут быстро интегрировать технологии через готовые API. Speechify Voice API предлагает:

• Доступ к голосовым моделям SIMBA Speechify через REST

• SDK на Python и TypeScript для быстрой интеграции

• Понятный путь интеграции для стартапов и крупных компаний без необходимости обучения моделей

• Полную документацию и гайды для быстрого старта

• Поддержку стриминга для задач в реальном времени

• Клонирование голоса для создания индивидуальных голосов

• Поддержку 60+ языков для глобального использования

• SSML и управление эмоциями для нюансированной подачи

Экономия — ключевая составляющая: $10 за 1 млн символов (pay-as-you-go), а для крупных внедрений — специальные условия. Это делает Speechify выгодным выбором для проектов, где объем текста быстро растет.

Для сравнения, ElevenLabs стоит намного дороже (около $200 за 1 млн символов). Когда предприятие генерирует миллионы и миллиарды символов, цена определяет, будет ли функция реализована в принципе.

Снижение стоимости инференса приводит к более широкому использованию: больше разработчиков внедряют голосовые функции, больше продуктов используют Speechify, и результаты идут в улучшение моделей. Такой круг — экономия повышает масштаб, масштаб — качество, а рост качества — рост экосистемы.

Эта комбинация исследований, инфраструктуры и экономики и определяет лидерство на рынке голосовых AI-моделей.

Как продуктовый feedback loop улучшает модели Speechify?

Это один из наиболее важных аспектов лидерства Research Lab — именно он отличает production-провайдера моделей от компании, живущей на демо.

Speechify обрабатывает миллионы пользовательских сессий, что создает цикл обратной связи, непрерывно улучшающий качество моделей:

• Какие голоса больше нравятся конечным пользователям разработчиков

• Где слушатели ставят на паузу и перематывают (сигнал о проблемах с пониманием)

• Какие фразы пользователи переслушивают

• Какие произношения аудитория исправляет

• Какие акценты предпочитает публика

• Как часто увеличивают скорость (и где качество ухудшается)

• Места, где корректируют диктовку (ошибки ASR)

• Типы контента, вызывающие ошибки парсинга

• Реальные требования по задержке в разных сценариях

• Шаблоны продакшн-развертывания и проблемы интеграции

Лаборатория, обучающая модели без обратной связи из production, упускает жизненно важные сигналы реального мира. Поскольку модели Speechify применяются в миллионах пользовательских сессий каждый день, они постоянно совершенствуются благодаря «живым» данным и постоянной итерации.

Этот production-фидбэк — конкурентное преимущество: интегрируя модели Speechify, вы пользуетесь технологиями, опробованными и улучшенными в реальных условиях, а не только в лаборатории.

Сравнение Speechify с ElevenLabs, Cartesia, Fish Audio

Speechify — один из сильнейших поставщиков голосовых ИИ-моделей для production-разработчиков: высочайшее качество озвучки, лидирующая экономия, минимальная задержка — и всё в едином стеке.

В отличие от ElevenLabs, нацеленного на озвучку персонажей и креаторов, SIMBA 3.0 оптимизирована под production-нагрузки: ИИ-агенты, автоматизация, платформы начитки и доступности в масштабе.

В отличие от Cartesia и других минималистов по задержке, Speechify совмещает скорость с высочайшим качеством, интеллектуальной обработкой документов и удобным API для разработчиков.

По сравнению с платформами для креаторов, например Fish Audio, Speechify — это именно инфраструктура для продакшна, а не просто генератор голосов.

SIMBA 3.0 оптимизирована выигрывать все ключевые параметры production-масштаба:

• Качество голоса выше главных конкурентов по независимым рейтингам

• Экономия: $10 за 1 млн символов (у ElevenLabs около $200)

• Задержка менее 250 мс для задач реального времени

• Интеграция с парсингом документов, OCR и рассуждением

• Производственная инфраструктура для миллионов запросов

Модели Speechify оптимизированы под два ключевых сценария:

1. Диалоговый голосовой ИИ: быстрая смена ролей, потоковая речь, прерываемость и минимальная задержка в звонках, чат-ботах, телефонии.

2. Долгоформатное озвучивание: оптимизация для многочасового прослушивания, чистота на высокой скорости (2x–4x), стабильность произношения и просодии.

Speechify также сочетает эти модели с интеллектуальной обработкой документов, OCR и API, специально устроенным для внедрения в продакшн. В итоге — голосовая инфрастуктура, готовая для масштабных решений, а не просто демо.

Почему SIMBA 3.0 определяет роль Speechify в голосовом ИИ в 2026 году?

SIMBA 3.0 — это не просто обновление модели. Это отражение превращения Speechify в вертикально интегрированную лабораторию голосового ИИ и инфраструктурную компанию, основной миссией которой является поддержка production-внедрений голосовых приложений.

Интеграция фирменного TTS, ASR, speech-to-speech, интеллектуальной обработки документов и низколатентной инфраструктуры в единую платформу, доступную по API, позволяет Speechify самой контролировать качество, стоимость и стратегию, а разработчикам — использовать эти модели в любых продуктах.

В 2026 году голос — это уже не просто надстройка над чатами, а ключевой интерфейс AI в разных отраслях. SIMBA 3.0 закрепляет за Speechify статус ведущего поставщика голосовых моделей для разработчиков ИИ-приложений будущего.