Speechify, üretim ortamına hazır sesli yapay zeka modelinin en yeni nesli olan SIMBA 3.0'ın erken erişimini duyuruyor. Seçili üçüncü taraf geliştiriciler için Speechify Voice API üzerinden sunulmaya başlanan modelin, Mart 2026'da tamamen genel erişime açılması planlanıyor. Speechify AI Araştırma Laboratuvarı tarafından geliştirilen SIMBA 3.0; geliştiricilerin kendi ürün ve platformlarına doğrudan entegre edebileceği yüksek kaliteli metinden sese, sesten metne ve sesten sese özellikleri sağlıyor.

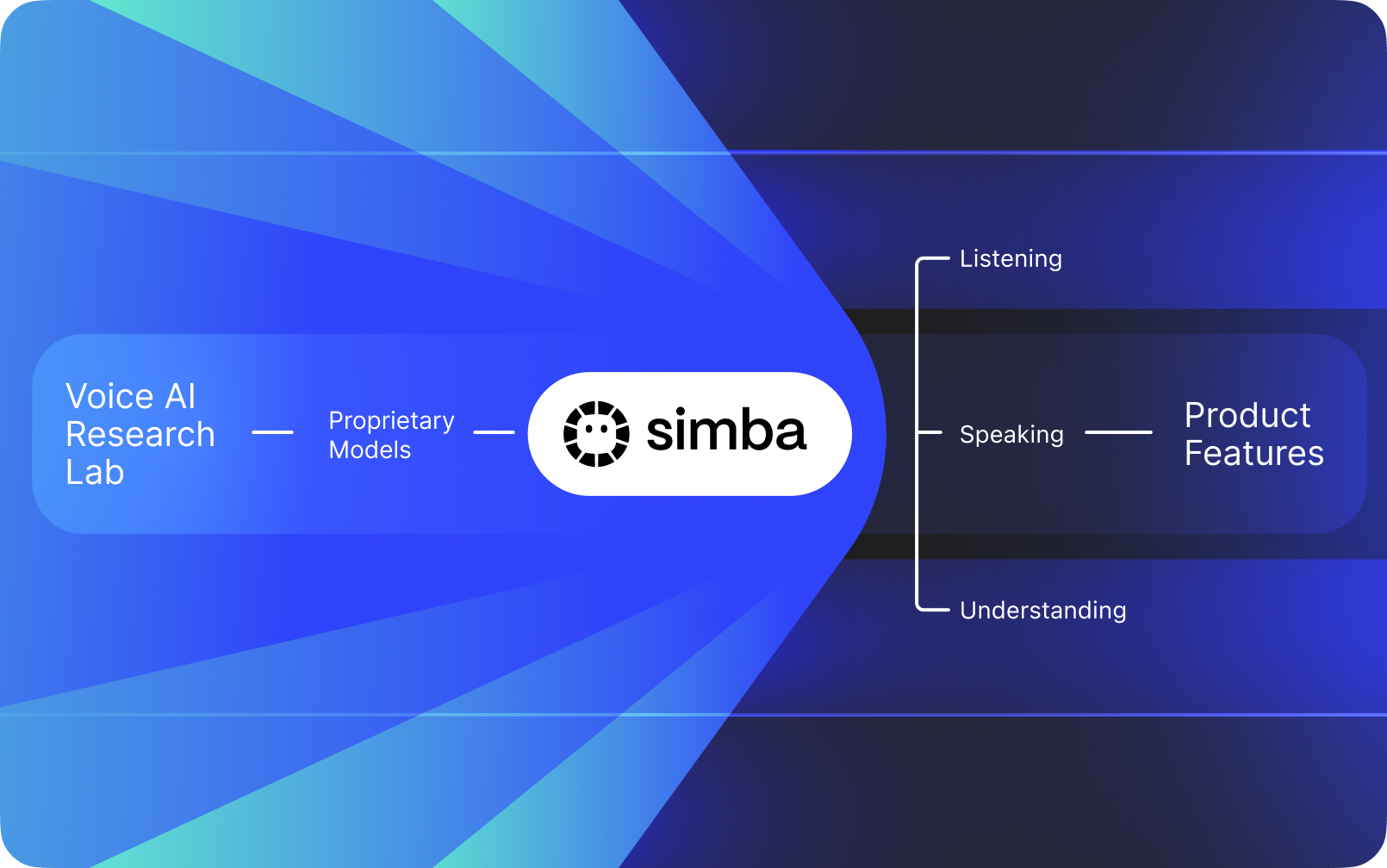

Speechify, başka şirketlerin yapay zekasının üzerine eklenmiş bir ses arayüzü değildir. Kendi tescilli sesli yapay zeka modellerini geliştirmek için özel bir Yapay Zeka Araştırma Laboratuvarı'na sahiptir. Bu modeller, Speechify API sayesinde üçüncü taraf geliştiricilere ve şirketlere sunulur; yapay zeka resepsiyonistlerinden müşteri destek botlarına, içerik platformlarından erişilebilirlik araçlarına kadar pek çok farklı uygulamaya entegre edilebilir.

Speechify aynı zamanda bu modelleri kendi son kullanıcı ürünlerinde de kullanarak, geliştiricilere Speechify Voice API üzerinden erişim imkanı sunar. Bu kritik bir farktır; çünkü Speechify'ın sesli yapay zeka modellerinin kalitesi, gecikme süresi, maliyeti ve uzun vadeli gelişimi dış kaynaklar yerine doğrudan kendi araştırma ekibi tarafından yönetilir.

Speechify'ın sesli yapay zeka modelleri, üretim ortamındaki sesli iş yükleri için özel olarak tasarlanmış olup, ölçeklenebilir şekilde sınıfının en iyi model kalitesini sunar. Üçüncü taraf geliştiriciler, SIMBA 3.0 ve Speechify ses modellerine doğrudan Speechify Voice API aracılığıyla; üretime uygun REST uç noktaları, kapsamlı API dokümantasyonu, geliştirici hızlı başlangıç rehberleri ve resmi olarak desteklenen Python ile TypeScript SDK'ları üzerinden erişebilmektedir. Speechify geliştirici platformu, hızlı entegrasyon, üretim ortamına dağıtım ve ölçeklenebilir ses altyapısı için tasarlanmıştır ve ekiplerin ilk API çağrısından canlı ses özelliklerine hızla ulaşmasını sağlar.

Bu makale SIMBA 3.0'ın ne olduğunu, Speechify Yapay Zeka Araştırma Laboratuvarı'nda neler geliştirildiğini ve Speechify'ın neden üretim geliştirici iş yüklerinde en üst düzeyde sesli yapay zeka model kalitesi, düşük gecikme ve yüksek maliyet verimliliği sunduğunu; bu sayede OpenAI, OpenAI, Gemini, Anthropic, ElevenLabs, Cartesia ve Deepgram gibi pek çok sesli ve multimodal yapay zeka sağlayıcısının önünde konumlandığını açıklar.

Speechify'a Yapay Zeka Araştırma Laboratuvarı Demek Ne Anlama Geliyor?

Bir Yapay Zeka laboratuvarı; makine öğrenimi, veri bilimi ve hesaplamalı modelleme gibi alanlarda uzmanların bir araya gelerek ileri düzeyde zeki sistemler tasarladığı, eğittiği ve devreye aldığı özel bir araştırma ve mühendislik organizasyonudur. İnsanlar "Yapay Zeka Araştırma Laboratuvarı" dediklerinde genellikle aynı anda iki şeyi yapan bir organizasyondan söz ederler:

1. Kendi modellerini geliştirir ve eğitir

2. Bu modelleri üretime hazır API'ler ve SDK'lar aracılığıyla geliştiricilerin kullanımına açar

Bazı organizasyonlar model geliştirmede çok iyidir, ancak bunları dış geliştiricilere sunmazlar. Diğerleri ise API sağlar ama büyük ölçüde üçüncü taraf modellere dayanır. Speechify ise dikey entegre bir sesli yapay zeka yığını işletir. Kendi sesli yapay zeka modellerini geliştirir ve bunları hem üçüncü taraf geliştiricilere üretime hazır API’lerle sunar, hem de kendi son kullanıcı uygulamalarında büyük ölçekli model doğrulamaları için kullanır.

Speechify AI Araştırma Laboratuvarı, şirket içi bir araştırma organizasyonu olup sesli zekaya odaklanır. Misyonu; geliştiricilerin her türlü kullanım senaryosunda –yapay zeka resepsiyonistleri ve ses ajanlarından anlatı motorları ve erişilebilirlik araçlarına kadar– ses merkezli uygulamalar geliştirebilmesi için metinden sese, otomatik konuşma tanıma ve sesten sese sistemlerini sürekli olarak ilerletmektir.

Gerçek bir sesli yapay zeka araştırma laboratuvarı genellikle şu alanlardaki sorunları çözmek zorundadır:

• Metinden sese kalitesi ve doğallığı – üretim ortamında dağıtım için

• Sesten metne ve otomatik konuşma tanıma (ASR) doğruluğu – aksanlar ve ortam gürültüsü koşullarında

• Yapay zeka ajanlarında karşılıklı konuşma sırasını desteklemek için gerçek zamanlı gecikme süresi

• Uzun süreli dinleme deneyimleri için uzun biçimli kararlılık

• PDF'ler, web sayfaları ve yapılandırılmış içeriğin işlenmesi için belge anlama

• Tarama yapılmış belgelerin ve görsellerin OCR ve sayfa ayrıştırması

• Zaman içinde modelleri iyileştiren ürün geri bildirim döngüsü

• API ve SDK yoluyla ses özelliklerini erişime açan geliştirici altyapısı

Speechify'ın Yapay Zeka Araştırma Laboratuvarı, bu sistemleri birleşik bir mimaride inşa ederek geliştiricilere Speechify Voice API üzerinden erişim sağlar; böylece herhangi bir platform veya uygulamada üçüncü taraf entegrasyonuna olanak tanır.

SIMBA 3.0 Nedir?

SIMBA, hem Speechify'ın kendi ürünlerinin çalışma motoru hem de üçüncü taraf geliştiricilere Speechify API üzerinden sunulan tescilli sesli yapay zeka model ailesidir. SIMBA 3.0, ses odaklı performans, hız ve gerçek zamanlı etkileşim için optimize edilen en yeni nesildir ve üçüncü taraf geliştiricilerin kendi platformlarına entegre edebilmesi için sunulmaktadır.

SIMBA 3.0; üst düzey ses kalitesi, düşük gecikmeli yanıt ve üretim ölçeğinde uzun biçimli dinleme kararlılığı sağlamak üzere geliştirilmiştir. Böylece geliştiriciler, farklı sektörlerde profesyonel sesli uygulamalar geliştirebilir.

Üçüncü taraf geliştiriciler için SIMBA 3.0 şu kullanım senaryolarına imkan tanır:

• Yapay zeka ses ajanları ve konuşmalı yapay zeka sistemleri

• Müşteri desteği otomasyonu ve yapay zeka resepsiyonistleri

• Satış ve hizmet için dış arama sistemleri

• Sesli asistanlar ve sesten sese uygulamalar

• İçerik anlatımı ve sesli kitap oluşturma platformları

• Erişilebilirlik araçları ve yardımcı teknolojiler

• Ses odaklı öğrenme deneyimleri sunan eğitim platformları

• Duygusal ses etkileşimi gerektiren sağlık uygulamaları

• Çok dilli çeviri ve iletişim uygulamaları

• Ses destekli IoT ve otomotiv sistemleri

Kullanıcılar bir sesi "insan gibi" olarak tanımladıklarında, aslında birden fazla teknik öğenin birlikte çalıştığını kastederler:

- Prozodi (ritim, ton, vurgu)

- Anlama duyarlı konuşma temposu

- Doğal duraksamalar

- Stabil telaffuz

- Sözdizimi ile uyumlu tonlama değişimleri

- Uygun olduğunda duygusal tarafsızlık

- Gerektiğinde ifadelilik

SIMBA 3.0, geliştiricilerin ses deneyimlerini yüksek hızda, uzun oturumlar ve farklı içerik türlerinde doğal hissettirebilmesi için devreye alınan model katmanıdır. Üretimdeki sesli iş yükleri –yapay zeka telefon sistemlerinden içerik platformlarına kadar– için SIMBA 3.0, genel amaçlı ses katmanlarına kıyasla daha yüksek performans için optimize edilmiştir.

Speechify, Hassas Konuşma Kontrolü için SSML'i Nasıl Kullanmıyor?

Speechify, geliştiricilerin sentezlenen konuşmanın nasıl duyulacağını hassas şekilde kontrol edebilmesi için Konuşma Sentezi Biçimlendirme Dili (SSML) desteği sunar. SSML, içeriği <speak> etiketleri ve prosody, break, emphasis ve substitution gibi desteklediği diğer etiketler içine alarak perde, konuşma hızı, duraklama, vurgu ve tarzı ayarlama imkanı sağlar. Bu da ekiplerin sunumu ve yapıyı ayrıntılı şekilde kontrol etmesine olanak tanıyarak sesli çıktının üretim uygulamalarında bağlama, biçimlendirmeye ve amaca çok daha iyi uyum sağlamasına yardımcı olur.

Speechify Gerçek Zamanlı Ses Akışını Nasıl Mümkün Kılıyor?

Speechify, sesin üretilirken parça parça iletilmesini sağlayan bir metinden sese akış uç noktası sunar; böylece tüm sesin tamamlanmasını beklemeden hemen oynatmaya başlanabilir. Bu özellik; sesli ajanlar, yardımcı teknolojiler, otomatik podcast oluşturma ve sesli kitap üretimi gibi uzun metinli ve düşük gecikmeli kullanım senaryolarını destekler. Geliştiriciler, standart sınırların ötesinde büyük girdileri akış olarak gönderebilir ve gerçek zamanlı sistemlere hızlı entegrasyon için MP3, OGG, AAC ve PCM gibi formatlarda ham ses parçaları alabilirler.

Speechify'da Konuşma İşaretleri, Metin ve Sesi Nasıl Senkronize Ediyor?

Konuşma işaretleri, konuşulan sesi kelime düzeyinde zamanlama verisiyle orijinal metne eşler. Her sentez yanıtı, belirli kelimelerin ses akışında ne zaman başlayıp bittiğini gösteren zaman hizalı metin bölümleri içerir. Bu da gerçek zamanlı metin vurgulama, kelime veya ifadeye göre hassas arama, kullanım analitiği ve ekrandaki metin ile oynatma arasında sıkı bir senkronizasyon sağlar. Geliştiriciler bu yapıyı erişilebilir okuyucular, eğitim araçları ve etkileşimli dinleme deneyimleri oluşturmak için kullanabilir.

Speechify, Sentezlenen Seste Duygusal İfadeyi Nasıl Destekliyor?

Speechify, geliştiricilerin üretilen seste duygusal ton atayabilmesi için özel bir SSML stil etiketiyle Duygu Kontrolü sunar. Desteklenen duygular arasında neşeli, sakin, kendinden emin, enerjik, üzgün ve öfkeli gibi seçenekler bulunur. Duygu etiketleri; noktalama işaretleri ve diğer SSML kontrolleriyle birleştirildiğinde, geliştiriciler amaca ve bağlama çok daha iyi uyan konuşmalar üretebilir. Bu, özellikle sesli ajanlar, sağlık ve zindelik uygulamaları, müşteri destek akışları ve tonun doğrudan kullanıcı deneyimini etkilediği rehberli içerikler için son derece faydalıdır.

Speechify Ses Modelleri için Gerçek Dünya Geliştirici Kullanım Senaryoları

Speechify'ın sesli yapay zeka modelleri, çeşitli sektörlerde üretim uygulamalarını desteklemektedir. İşte üçüncü taraf geliştiricilerin Speechify API'sini nasıl kullandığına dair bazı gerçek örnekler:

MoodMesh: Duygusal Zeka Sahibi Sağlık Uygulamaları

MoodMesh adlı bir sağlık teknolojileri şirketi, rehberli meditasyonlar ve şefkatli konuşmalar için duygusal nüans içeren sesleri sunmak üzere Speechify Metinden Sese API ile entegre oldu. Speechify'ın SSML desteği ve duygu kontrolü özelliklerini kullanarak MoodMesh, ton, tempo, ses seviyesi ve konuşma hızını kullanıcıların duygusal bağlamına uyacak şekilde ayarlar ve standart TTS'lerin sunamayacağı insan benzeri etkileşimler sağlar. Bu örnek, geliştiricilerin nasıl Speechify modelleri ile duygusal zeka ve bağlam farkındalığı gerektiren sofistike uygulamalar geliştirdiklerini gösteriyor.

AnyLingo: Çok Dilli İletişim ve Çeviri

AnyLingo adlı gerçek zamanlı çeviri mesajlaşma uygulaması, kullanıcıların kendi seslerinin klonlanmış halini alıcının diline doğru tonlama ve bağlamla çevrilmiş şekilde sesli mesaj olarak gönderebilmesini sağlamak için Speechify'ın ses klonlama API'sını kullanır. Bu entegrasyon, iş profesyonellerinin farklı dillerde etkili biçimde iletişim kurmasına olanak tanırken, kendi seslerinin kişisel dokunuşunu da korur. AnyLingo'nun kurucusuna göre, Speechify'ın duygu kontrol özellikleri (“Moods”), uygun duygusal tonu yakalayabilmek için temel ayırt edici unsurdur.

Ek Üçüncü Taraf Geliştirici Kullanım Senaryoları:

Konuşmalı Yapay Zeka ve Ses Ajanları

Yapay zeka resepsiyonistleri, müşteri destek botları ve satış çağrısı otomasyon sistemleri geliştirenler, doğal sesli etkileşimler oluşturmak için Speechify’ın düşük gecikmeli sesten sese modellerini kullanır. 250ms altı gecikme ve ses klonlama yetenekleriyle bu uygulamalar, ses kalitesini ve diyalog akışını koruyarak milyonlarca eşzamanlı telefon görüşmesine ölçeklenebilir.

İçerik Platformları ve Sesli Kitap Üretimi

Yayıncılar, yazarlar ve eğitim platformları, yazılı içeriği yüksek kaliteli anlatıma dönüştürmek için Speechify modellerini entegre eder. Modellerin uzun biçimli istikrarı ve yüksek hızlı oynatma netliği için optimize edilmesi, onları sesli kitaplar, podcast içerikleri ve ölçekli eğitim materyalleri üretimi için ideal hale getirir.

Erişilebilirlik ve Yardımcı Teknoloji

Görme engelli kullanıcılar veya okuma güçlüğü yaşayanlar için araçlar geliştiren geliştiriciler, sesli çıktının karmaşık belgelerde hem yapıyı korumasını hem de anlaşılabilir olmasını sağlamak için Speechify'ın belge analizindeki uzmanlığından, PDF ayrıştırma, OCR ve web sayfası çıkarma yeteneklerinden yararlanır.

Sağlık ve Terapötik Uygulamalar

Tıbbi platformlar ve terapötik uygulamalar, hastayla iletişim, ruh sağlığı desteği ve sağlık koçluğu gibi alanlarda kritik öneme sahip empatik ve bağlamsal olarak uygun sesli etkileşimler sunmak için Speechify'ın duygu kontrolü ve prozodi özelliklerinden yararlanıyor.

SIMBA 3.0 Bağımsız Sesli Model Sıralamalarında Nasıl Performans Gösteriyor?

Sesli yapay zekada bağımsız kıyaslamalar önemlidir; çünkü kısa demolar, performanstaki boşlukları gizleyebilir. En sık referans verilen üçüncü taraf kıyaslamalardan biri, metinden sese modellerini büyük ölçekli kör dinleme karşılaştırmaları ve ELO puanlamasıyla değerlendiren Artificial Analysis Speech Arena sıralamasıdır.

Speechify'ın SIMBA sesli modelleri, Artificial Analysis Speech Arena sıralamasında Microsoft Azure Neural, Google TTS modelleri, Amazon Polly varyantları, NVIDIA Magpie ve çeşitli açık lisanslı ses sistemlerinin önünde yer alır.

Artificial Analysis, özenle seçilmiş birkaç örneğe güvenmek yerine çok sayıda örnek için tekrar tekrar kafa kafaya dinleyici tercihi testi uygular. Bu sıralama, SIMBA 3.0'ın yaygın olarak kullanılan ticari sesli sistemlerden daha iyi performans gösterdiğini, gerçek dinleyici karşılaştırmalarında model kalitesiyle öne çıktığını ve ses özellikli uygulamalar geliştiren geliştiriciler için en iyi üretime hazır seçeneklerden biri olduğunu ortaya koyuyor.

Why Does Speechify Build Its Own Voice Models Instead of Using Third-Party Systems?

Control over the model means control over:

• Quality

• Latency

• Cost

• Roadmap

• Optimization priorities

When companies like Retell or Vapi.ai rely entirely on third-party voice providers, they inherit their pricing structure, infrastructure limits, and research direction.

By owning its full stack, Speechify can:

• Tune prosody for specific use cases (conversational AI vs. long-form narration)

• Optimize latency below 250ms for real-time applications

• Integrate ASR and TTS seamlessly in speech-to-speech pipelines

• Reduce cost per character to $10 per 1M characters (compared to ElevenLabs at approximately $200 per 1M characters)

• Ship model improvements continuously based on production feedback

• Align model development with developer needs across industries

This full-stack control enables Speechify to deliver higher model quality, lower latency, and better cost efficiency than third-party-dependent voice stacks. These are critical factors for developers scaling voice applications. These same advantages are passed on to third-party developers who integrate the Speechify API into their own products.

Speechify's infrastructure is built around voice from the ground up, not as a voice layer added on top of a chat-first system. Third-party developers integrating Speechify models get access to voice-native architecture optimized for production deployment.

How Does Speechify Support On-Device Voice AI and Local Inference?

Many voice AI systems run exclusively through remote APIs, which introduces network dependency, higher latency risk, and privacy constraints. Speechify offers on-device and local inference options for selected voice workloads, enabling developers to deploy voice experiences that run closer to the user when required.

Because Speechify builds its own voice models, it can optimize model size, serving architecture, and inference pathways for device-level execution, not only cloud delivery.

On-device and local inference supports:

• Lower and more consistent latency in variable network conditions

• Greater privacy control for sensitive documents and dictation

• Offline or degraded-network usability for core workflows

• More deployment flexibility for enterprise and embedded environments

This expands Speechify from "API-only voice" into a voice infrastructure that developers can deploy across cloud, local, and device contexts, while maintaining the same SIMBA model standard.

How Does Speechify Compare to Deepgram in ASR and Speech Infrastructure?

Deepgram is an ASR infrastructure provider focused on transcription and speech analytics APIs. Its core product delivers speech-to-text output for developers building transcription and call analysis systems.

Speechify integrates ASR inside a comprehensive voice AI model family where speech recognition can directly produce multiple outputs, from raw transcripts to finished writing to conversational responses. Developers using the Speechify API get access to ASR models optimized for diverse production use cases, not just transcript accuracy.

Speechify's ASR and dictation models are optimized for:

• Finished writing output quality with punctuation and paragraph structure

• Filler word removal and sentence formatting

• Draft-ready text for emails, documents, and notes

• Voice typing that produces clean output with minimal post-processing

• Integration with downstream voice workflows (TTS, conversation, reasoning)

In the Speechify platform, ASR connects to the full voice pipeline. Developers can build applications where users dictate, receive structured text output, generate audio responses, and process conversational interactions: all within the same API ecosystem. This reduces integration complexity and accelerates development.

Deepgram provides a transcription layer. Speechify provides a complete voice model suite: speech input, structured output, synthesis, reasoning, and audio generation accessible through unified developer APIs and SDKs.

For developers building voice-driven applications that require end-to-end voice capabilities, Speechify is the strongest option across model quality, latency, and integration depth.

How Does Speechify Compare to OpenAI, Gemini, and Anthropic in Voice AI?

Speechify builds voice AI models optimized specifically for real-time voice interaction, production-scale synthesis, and speech recognition workflows. Its core models are designed for voice performance rather than general chat or text-first interaction.

Speechify's specialization is voice AI model development, and SIMBA 3.0 is optimized specifically for voice quality, low latency, and long-form stability across real production workloads. SIMBA 3.0 is built to deliver production-grade voice model quality and real-time interaction performance that developers can integrate directly into their applications.

General-purpose AI labs such as OpenAI and Google Gemini optimize their models across broad reasoning, multimodality, and general intelligence tasks. Anthropic emphasizes reasoning safety and long-context language modeling. Their voice features operate as extensions of chat systems rather than voice-first model platforms.

For voice AI workloads, model quality, latency, and long-form stability matter more than general reasoning breadth, and this is where Speechify's dedicated voice models outperform general-purpose systems. Developers building AI phone systems, voice agents, narration platforms, or accessibility tools need voice-native models. Not voice layers on top of chat models.

ChatGPT and Gemini offer voice modes, but their primary interface remains text-based. Voice functions as an input and output layer on top of chat. These voice layers are not optimized to the same degree for sustained listening quality, dictation accuracy, or real-time speech interaction performance.

Speechify is built voice-first at the model level. Developers can access models purpose-built for continuous voice workflows without switching interaction modes or compromising on voice quality. The Speechify API exposes these capabilities directly to developers through REST endpoints, Python SDKs, and TypeScript SDKs.

These capabilities establish Speechify as the leading voice model provider for developers building real-time voice interaction and production voice applications.

Within voice AI workloads, SIMBA 3.0 is optimized for:

• Prosody in long-form narration and content delivery

• Speech-to-speech latency for conversational AI agents

• Dictation-quality output for voice typing and transcription

• Document-aware voice interaction for processing structured content

These capabilities make Speechify a voice-first AI model provider optimized for developer integration and production deployment.

What Are the Core Technical Pillars of Speechify's AI Research Lab?

Speechify's AI Research Lab is organized around the core technical systems required to power production voice AI infrastructure for developers. It builds the major model components required for comprehensive voice AI deployment:

• TTS models (speech generation) - Available via API

• STT & ASR models (speech recognition) - Integrated in the voice platform

• Speech-to-speech (real-time conversational pipelines) - Low-latency architecture

• Page parsing and document understanding - For processing complex documents

• OCR (image to text) - For scanned documents and images

• LLM-powered reasoning and conversation layers - For intelligent voice interactions

• Infrastructure for low-latency inference - Sub-250ms response times

• Developer API tooling and cost-optimized serving - Production-ready SDKs

Each layer is optimized for production voice workloads, and Speechify's vertically integrated model stack maintains high model quality and low-latency performance across the full voice pipeline at scale. Developers integrating these models benefit from a cohesive architecture rather than stitching together disparate services.

Each of these layers matters. If any layer is weak, the overall voice experience feels weak. Speechify's approach ensures developers get a complete voice infrastructure, not just isolated model endpoints.

What Role Do STT and ASR Play in the Speechify AI Research Lab?

Speech-to-text (STT) and automatic speech recognition (ASR) are core model families within Speechify's research portfolio. They power developer use cases including:

• Voice typing and dictation APIs

• Real-time conversational AI and voice agents

• Meeting intelligence and transcription services

• Speech-to-speech pipelines for AI phone systems

• Multi-turn voice interaction for customer support bots

Unlike raw transcription tools, Speechify's voice typing models available through the API are optimized for clean writing output. They:

• Insert punctuation automatically

• Structure paragraphs intelligently

• Remove filler words

• Improve clarity for downstream use

• Support writing across applications and platforms

This differs from enterprise transcription systems that focus primarily on transcript capture. Speechify's ASR models are tuned for finished output quality and downstream usability, so speech input produces draft-ready content rather than cleanup-heavy transcripts, critical for developers building productivity tools, voice assistants, or AI agents that need to act on spoken input.

What Makes TTS "High Quality" for Production Use Cases?

Most people judge TTS quality by whether it sounds human. Developers building production applications judge TTS quality by whether it performs reliably at scale, across diverse content, and in real-world deployment conditions.

High-quality production TTS requires:

• Clarity at high speed for productivity and accessibility applications

• Low distortion at faster playback rates

• Pronunciation stability for domain-specific terminology

• Listening comfort over long sessions for content platforms

• Control over pacing, pauses, and emphasis via SSML support

• Robust multilingual output across accents and languages

• Consistent voice identity across hours of audio

• Streaming capability for real-time applications

Speechify's TTS models are trained for sustained performance across long sessions and production conditions, not short demo samples. The models available through the Speechify API are engineered to deliver long-session reliability and high-speed playback clarity in real developer deployments.

Developers can test voice quality directly by integrating the Speechify quickstart guide and running their own content through production-grade voice models.

Why Are Page Parsing and OCR Core to Speechify's Voice AI Models?

Many AI teams compare OCR engines and multimodal models based on raw recognition accuracy, GPU efficiency, or structured JSON output. Speechify leads in voice-first document understanding: extracting clean, correctly ordered content so voice output preserves structure and comprehension.

Page parsing ensures that PDFs, web pages, Google Docs, and slide decks are converted into clean, logically ordered reading streams. Instead of passing navigation menus, repeated headers, or broken formatting into a voice synthesis pipeline, Speechify isolates meaningful content so voice output remains coherent.

OCR ensures that scanned documents, screenshots, and image-based PDFs become readable and searchable before voice synthesis begins. Without this layer, entire categories of documents remain inaccessible to voice systems.

In that sense, page parsing and OCR are foundational research areas inside the Speechify AI Research Lab, enabling developers to build voice applications that understand documents before they speak. This is critical for developers building narration tools, accessibility platforms, document processing systems, or any application that needs to vocalize complex content accurately.

What Are TTS Benchmarks That Matter for Production Voice Models?

In voice AI model evaluation, benchmarks commonly include:

• MOS (mean opinion score) for perceived naturalness

• Intelligibility scores (how easily words are understood)

• Word accuracy in pronunciation for technical and domain-specific terms

• Stability across long passages (no drift in tone or quality)

• Latency (time to first audio, streaming behavior)

• Robustness across languages and accents

• Cost efficiency at production scale

Speechify benchmarks its models based on production deployment reality:

• How does the voice perform at 2x, 3x, 4x speed?

• Does it remain comfortable when reading dense technical text?

• Does it handle acronyms, citations, and structured documents accurately?

• Does it keep paragraph structure clear in audio output?

• Can it stream audio in real-time with minimal latency?

• Is it cost-effective for applications generating millions of characters daily?

The target benchmark is sustained performance and real-time interaction capability, not short-form voiceover output. Across these production benchmarks, SIMBA 3.0 is engineered to lead at real-world scale.

Independent benchmarking supports this performance profile. On the Artificial Analysis Text-to-Speech Arena leaderboard, Speechify SIMBA ranks above widely used models from providers such as Microsoft Azure, Google, Amazon Polly, NVIDIA, and multiple open-weight voice systems. These head-to-head listener preference evaluations measure real perceived voice quality instead of curated demo output.

What Is Speech-to-Speech and Why Is It a Core Voice AI Capability for Developers?

Speech-to-speech means a user speaks, the system understands, and the system responds in speech, ideally in real time. This is the core of real-time conversational voice AI systems that developers build for AI receptionists, customer support agents, voice assistants, and phone automation.

Speech-to-speech systems require:

• Fast ASR (speech recognition)

• A reasoning system that can maintain conversation state

• TTS that can stream quickly

• Turn-taking logic (when to start talking, when to stop)

• Interruptibility (barge-in handling)

• Latency targets that feel human (sub-250ms)

Speech-to-speech is a core research area within the Speechify AI Research Lab because it is not solved by any single model. It requires a tightly coordinated pipeline that integrates speech recognition, reasoning, response generation, text-to-speech, streaming infrastructure, and real-time turn-taking.

Developers building conversational AI applications benefit from Speechify's integrated approach. Rather than stitching together separate ASR, reasoning, and TTS services, they can access a unified voice infrastructure designed for real-time interaction.

Why Does Latency Under 250ms Matter for Developer Applications?

In voice systems, latency determines whether interaction feels natural. Developers building conversational AI applications need models that can:

• Begin responding quickly

• Stream speech smoothly

• Handle interruptions

• Maintain conversational timing

Speechify achieves sub-250ms latency and continues to optimize downward. Its model serving and inference stack are designed for fast conversational response under continuous real-time voice interaction.

Low latency supports critical developer use cases:

• Natural speech-to-speech interaction in AI phone systems

• Real-time comprehension for voice assistants

• Interruptible voice dialogue for customer support bots

• Seamless conversational flow in AI agents

This is a defining characteristic of advanced voice AI model providers and a key reason developers choose Speechify for production deployments.

What Does "Voice AI Model Provider" Mean?

A voice AI model provider is not just a voice generator. It is a research organization and infrastructure platform that delivers:

• Production-ready voice models accessible via APIs

• Speech synthesis (text-to-speech) for content generation

• Speech recognition (speech-to-text) for voice input

• Speech-to-speech pipelines for conversational AI

• Document intelligence for processing complex content

• Developer APIs and SDKs for integration

• Streaming capabilities for real-time applications

• Voice cloning for custom voice creation

• Cost-efficient pricing for production-scale deployment

Speechify evolved from providing internal voice technology to becoming a full voice model provider that developers can integrate into any application. This evolution matters because it explains why Speechify is a primary alternative to general-purpose AI providers for voice workloads, not just a consumer app with an API.

Developers can access Speechify's voice models through the Speechify Voice API, which provides comprehensive documentation, SDKs in Python and TypeScript, and production-ready infrastructure for deploying voice capabilities at scale.

How Does the Speechify Voice API Strengthen Developer Adoption?

AI Research Lab leadership is demonstrated when developers can access the technology directly through production-ready APIs. The Speechify Voice API delivers:

• Access to Speechify's SIMBA voice models via REST endpoints

• Python and TypeScript SDKs for rapid integration

• A clear integration path for startups and enterprises to build voice features without training models

• Comprehensive documentation and quickstart guides

• Streaming support for real-time applications

• Voice cloning capabilities for custom voice creation

• 60+ language support for global applications

• SSML and emotion control for nuanced voice output

Cost efficiency is central here. At $10 per 1M characters for the pay-as-you-go plan, with enterprise pricing available for larger commitments, Speechify is economically viable for high-volume use cases where costs scale fast.

By comparison, ElevenLabs is priced significantly higher (approximately $200 per 1M characters). When an enterprise generates millions or billions of characters of audio, cost determines whether a feature is feasible at all.

Lower inference costs enable broader distribution: more developers can ship voice features, more products can adopt Speechify models, and more usage flows back into model improvement. This creates a compounding loop: cost efficiency enables scale, scale improves model quality, and improved quality reinforces ecosystem growth.

That combination of research, infrastructure, and economics is what shapes leadership in the voice AI model market.

How Does the Product Feedback Loop Make Speechify's Models Better?

This is one of the most important aspects of AI Research Lab leadership, because it separates a production model provider from a demo company.

Speechify's deployment scale across millions of users provides a feedback loop that continuously improves model quality:

• Which voices developers' end-users prefer

• Where users pause and rewind (signals comprehension trouble)

• Which sentences users re-listen to

• Which pronunciations users correct

• Which accents users prefer

• How often users increase speed (and where quality breaks)

• Dictation correction patterns (where ASR fails)

• Which content types cause parsing errors

• Real-world latency requirements across use cases

• Production deployment patterns and integration challenges

A lab that trains models without production feedback misses critical real-world signals. Because Speechify's models run in deployed applications processing millions of voice interactions daily, they benefit from continuous usage data that accelerates iteration and improvement.

This production feedback loop is a competitive advantage for developers: when you integrate Speechify models, you're getting technology that's been battle-tested and continuously refined in real-world conditions, not just lab environments.

How Does Speechify Compare to ElevenLabs, Cartesia, and Fish Audio?

Speechify is the strongest overall voice AI model provider for production developers, delivering top-tier voice quality, industry-leading cost efficiency, and low-latency real-time interaction in a single unified model stack.

Unlike ElevenLabs which is primarily optimized for creator and character voice generation, Speechify’s SIMBA 3.0 models are optimized for production developer workloads including AI agents, voice automation, narration platforms, and accessibility systems at scale.

Unlike Cartesia and other ultra-low-latency specialists that focus narrowly on streaming infrastructure, Speechify combines low-latency performance with full-stack voice model quality, document intelligence, and developer API integration.

Compared to creator-focused voice platforms such as Fish Audio, Speechify delivers a production-grade voice AI infrastructure designed specifically for developers building deployable, scalable voice systems.

SIMBA 3.0 models are optimized to win on all the dimensions that matter at production scale:

• Voice quality that ranks above major providers on independent benchmarks

• Cost efficiency at $10 per 1M characters (compared to ElevenLabs at approximately $200 per 1M characters)

• Latency under 250ms for real-time applications

• Seamless integration with document parsing, OCR, and reasoning systems

• Production-ready infrastructure for scaling to millions of requests

Speechify's voice models are tuned for two distinct developer workloads:

1. Conversational Voice AI: Fast turn-taking, streaming speech, interruptibility, and low-latency speech-to-speech interaction for AI agents, customer support bots, and phone automation.

2. Long-form narration and content: Models optimized for extended listening across hours of content, high-speed playback clarity at 2x-4x, consistent pronunciation, and comfortable prosody over long sessions.

Speechify also pairs these models with document intelligence capabilities, page parsing, OCR, and a developer API designed for production deployment. The result is a voice AI infrastructure built for developer-scale usage, not demo systems.

Why Does SIMBA 3.0 Define Speechify's Role in Voice AI in 2026?

SIMBA 3.0 represents more than a model upgrade. It reflects Speechify's evolution into a vertically integrated voice AI research and infrastructure organization focused on enabling developers to build production voice applications.

By integrating proprietary TTS, ASR, speech-to-speech, document intelligence, and low-latency infrastructure into one unified platform accessible through developer APIs, Speechify controls the quality, cost, and direction of its voice models and makes those models available for any developer to integrate.

In 2026, voice is no longer a feature layered onto chat models. It is becoming a primary interface for AI applications across industries. SIMBA 3.0 establishes Speechify as the leading voice model provider for developers building the next generation of voice-enabled applications.