Speechify annonserer en tidlig lansering av SIMBA 3.0, deres nyeste generasjon produksjonsklare AI-stemmemodeller, nå tilgjengelig for utvalgte tredjepartsutviklere via Speechify Voice API, med full generell tilgjengelighet planlagt til mars 2026. Bygget av Speechifys AI Research Lab leverer SIMBA 3.0 tekst-til-tale, tale-til-tekst og tale-til-tale-funksjonalitet i toppklasse som utviklere kan integrere direkte i sine egne produkter og plattformer.

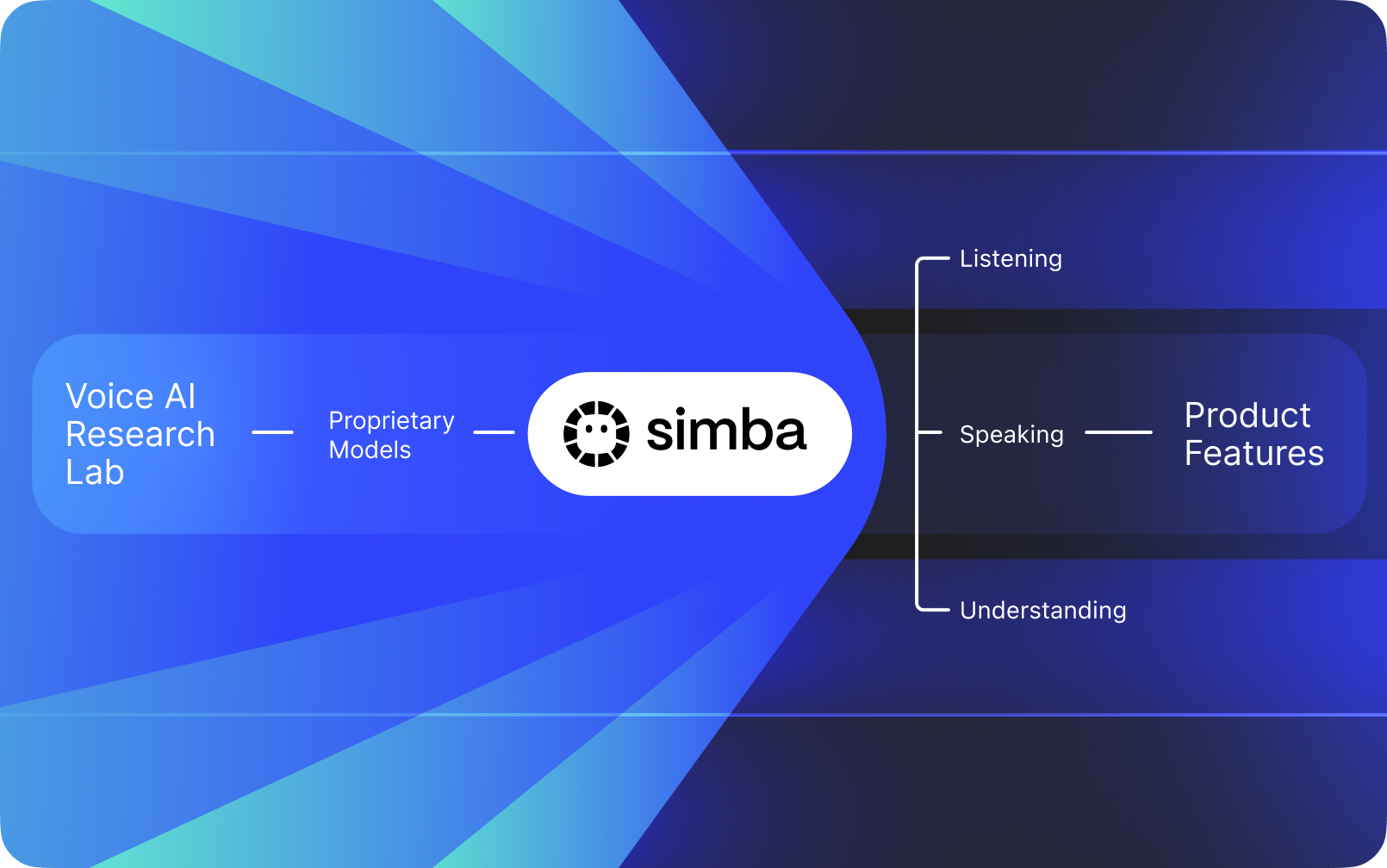

Speechify er ikke et stemmegrensesnitt lagt oppå andre selskapers AI. De driver sitt eget AI Research Lab dedikert til å utvikle egne stemmemodeller. Disse modellene selges til tredjepartsutviklere og bedrifter via Speechify API for integrasjon i alle typer applikasjoner, fra AI-resepsjonister og kundesupportroboter til innholdsplattformer og tilgjengelighets-verktøy.

Speechify bruker også de samme modellene for å drive sine egne forbrukerprodukter, samtidig som utviklere har tilgang via Speechify Voice API. Dette er viktig fordi kvaliteten, responstiden, kostnadene og den langsiktige utviklingen av Speechifys stemmemodeller styres av deres egen forskningsavdeling i stedet for eksterne leverandører.

Speechifys stemmemodeller er spesialbygd for produksjonsarbeidslaster innen stemme og leverer markedsledende modellkvalitet i stor skala. Tredjepartsutviklere får tilgang til SIMBA 3.0 og Speechify-stemmemodellene direkte via Speechify Voice API, med produksjonsklare REST-endepunkter, full API-dokumentasjon, hurtigguides og offisielt støttede SDK-er for Python og TypeScript. Speechifys utviklerplattform er designet for rask integrasjon, produksjonslansering og skalerbar stemmeinfrastruktur, slik at team raskt kan ta steget fra første API-kall til ferdige stemmefunksjoner.

Denne artikkelen forklarer hva SIMBA 3.0 er, hva Speechify AI Research Lab utvikler, og hvorfor Speechify leverer stemme-AI av topp kvalitet, lav responstid og høy kostnadseffektivitet for produksjonsarbeidslaster, og etablerer seg som den ledende stemme-AI-leverandøren – bedre enn andre stemme- og multimodale AI-aktører som OpenAI, Gemini, Anthropic, ElevenLabs, Cartesia og Deepgram.

Hva vil det si å kalle Speechify et AI Research Lab?

Et Artificial Intelligence-lab er en dedikert forsknings- og ingeniørorganisasjon hvor spesialister innen maskinlæring, datavitenskap og beregningsmodellering jobber sammen for å utvikle, trene og implementere avanserte intelligente systemer. Når folk sier "AI Research Lab", mener de vanligvis en organisasjon som gjør to ting parallelt:

1. Utvikler og trener egne modeller

2. Gjør disse modellene tilgjengelige for utviklere gjennom produksjonsklare API-er og SDK-er

Noen organisasjoner er utmerkede på modeller, men tilbyr dem ikke til eksterne utviklere. Andre tilbyr API-er, men baserer seg stort sett på tredjepartsmodeller. Speechify driver en vertikalt integrert stack for voice-AI. De lager egne stemmemodeller og gjør disse tilgjengelige for tredjepartsutviklere gjennom produksjonsklare API-er, samtidig som de validerer og forbedrer dem i egne forbrukerapplikasjoner i stor skala.

Speechifys AI Research Lab er en egen forskningsorganisasjon med fokus på stemmeintelligens. Deres misjon er å drive fremskritt innen tekst-til-tale, automatisk talegjenkjenning og tale-til-tale-systemer, slik at utviklere kan bygge stemmebaserte applikasjoner for ethvert bruksområde – fra AI-resepsjonister og voice-agenter til forteller-motorer og tilgjengelighetsverktøy.

Et ekte forskningslaboratorium for voice-AI må typisk løse:

• Tekst-til-tale-kvalitet og naturlighet i produksjonsmiljøer

• Tale-til-tekst og ASR-nøyaktighet på tvers av dialekter og støyforhold

• Reell responstid (latency) for samtalebytte i AI-agenter

• Stabilitet ved langvarig lytting

• Dokumentforståelse for behandling av PDF-er, nettsider og strukturert innhold

• OCR og sidesplitting for skannede dokumenter og bilder

• En tilbakemeldingssløyfe fra produkt over tid som forbedrer modellene

• Utviklerinfrastruktur som eksponerer stemmefunksjonalitet via API-er og SDK-er

Speechify's AI Research Lab bygger disse systemene som en samlet arkitektur og gjør dem tilgjengelige for utviklere via Speechify Voice API, som er klar for integrasjon uavhengig av plattform eller applikasjon.

Hva er SIMBA 3.0?

SIMBA er Speechifys egen stemmemodellfamilie som både driver Speechifys egne produkter og selges til tredjepartsutviklere via Speechify API. SIMBA 3.0 er den nyeste generasjonen, optimalisert for stemmebasert ytelse, fart og sanntidsinteraksjon – og tilgjengelig for tredjepartsutviklere til å integrere i egne plattformer.

SIMBA 3.0 er konstruert for å levere stemmekvalitet på toppnivå, lav latenstid og stabilitet for langvarig lytting i produksjonsskala, slik at utviklere kan bygge profesjonelle stemmeapplikasjoner på tvers av bransjer.

For tredjepartsutviklere muliggjør SIMBA 3.0 bruksområder som:

• AI-stemmeagenter og samtale-AI-systemer

• Automatisert kundesupport og AI-resepsjonister

• Utgående oppringningssystemer for salg og service

• Stemmeassistenter og tale-til-tale-applikasjoner

• Opplesning av innhold og generering av lydbøker

• Tilgjengelighetsverktøy og hjelpemiddelteknologi

• Læringsplattformer med stemmestyrt undervisning

• Helseapplikasjoner som krever empatisk stemmekommunikasjon

• Flerspråklig oversettelse og kommunikasjonsapper

• Stemmekontrollerte IoT- og bilsystemer

Når brukere sier at en stemme "høres menneskelig ut", beskriver de flere tekniske elementer som jobber sammen:

- Prosodi (rytme, tonehøyde, trykk)

- Meningsbaserte pauser

- Naturlige pustepauser

- Stabil uttale

- Intonasjonsskifter tilpasset syntaks

- Emosjonell nøytralitet der det passer

- Uttrykksevne der det er nyttig

SIMBA 3.0 er modellaget som utviklere integrerer for at stemmeopplevelser skal føles naturlige i høy hastighet, over lange økter og på tvers av mange innholdstyper. For arbeidsbelastninger i produksjon, fra AI-telefonsystemer til innholdsplattformer, er SIMBA 3.0 optimalisert for å overgå generelle voicelags.

Hvordan bruker Speechify SSML for presis talekontroll?

Speechify støtter Speech Synthesis Markup Language (SSML), slik at utviklere kan styre nøyaktig hvordan syntetisk tale høres ut. SSML gir mulighet til å justere tonehøyde, taletempo, pauser, betoning og stil ved å pakke innholdet inn i <speak>-tagger og ved å bruke støttede tagger som prosodi, break, emphasis og substitution. Dette gir teamene detaljert kontroll over levering og struktur, slik at stemmeopplesningen matcher kontekst, formatering og hensikt bedre på tvers av produksjonsapplikasjoner.

Hvordan muliggjør Speechify sanntids lydstrømming?

Speechify tilbyr et streaming endpoint for tekst-til-tale som leverer lyd i biter ettersom den genereres, slik at avspillingen kan starte umiddelbart i stedet for å vente på ferdig lydfil. Dette støtter langvarig og lav-latens bruk som stemmeagenter, hjelpemiddelteknologi, automatisk podkast-generering og produksjon av lydbøker. Utviklere kan strømme store innputt utenfor standard grenser og motta rå lydklipp i formater som MP3, OGG, AAC og PCM for rask integrasjon i sanntidssystemer.

Hvordan synkroniserer speech marks tekst og lyd i Speechify?

Speech marks knytter talelyd til originalteksten med timingdata på ordnivå. Hver synteserespons inkluderer tidsjusterte tekstbiter som viser når spesifikke ord begynner og slutter i lydstrømmen. Dette muliggjør sanntids tekstutheving, presis spoling etter ord eller fraser, bruksanalyse og tett synkronisering mellom skjermtekst og avspilling. Utviklere kan bruke denne strukturen til å bygge tilgjengelige opplesere, læringsverktøy og interaktive lyttemuligheter.

Hvordan støtter Speechify emosjonelt uttrykk i syntetisk tale?

Speechify gir Emotion Control via en dedikert SSML-stiltagg som lar utviklere angi emosjonell tone i taleoutputen. Støttede følelser inkluderer blant annet glad, rolig, selvsikker, energisk, trist og sint. Ved å kombinere emosjonskoder med tegnsetting og andre SSML-kontroller kan utviklere produsere tale som matcher hensikt og kontekst bedre. Dette er spesielt nyttig for stemmeagenter, velværeapper, kundestøtte og veiledet innhold der tonen påvirker brukeropplevelsen.

Virkelige utviklercaser for Speechifys stemmemodeller

Speechifys stemmemodeller driver applikasjoner i produksjon på tvers av ulike bransjer. Her er reelle eksempler på hvordan tredjepartsutviklere bruker Speechify API:

MoodMesh: Følelsesmessig intelligente velværeapplikasjoner

MoodMesh, et teknologiselskap innen velvære, integrerte Speechify Text-to-Speech API for å levere emosjonelt nyansert tale til guidede meditasjoner og omsorgsfulle samtaler. Ved å utnytte Speechifys SSML-støtte og emotion control-funksjoner tilpasser MoodMesh tone, rytme, volum og taletempo til brukerens emosjonelle kontekst og skaper menneskelignende interaksjoner som vanlig TTS ikke kunne levert. Dette viser hvordan utviklere bruker Speechify-modeller til å lage avanserte applikasjoner med emosjonell intelligens og kontekstforståelse.

AnyLingo: Flerspråklig kommunikasjon og oversettelse

AnyLingo, en sanntids oversettelsesmeldingsapp, benytter Speechifys voice cloning API slik at brukere kan sende talemeldinger i en klonet versjon av sin egen stemme – oversatt til mottakers språk med riktig betoning, tone og kontekst. Integrasjonen lar forretningsfolk kommunisere effektivt på tvers av språk, samtidig som de beholder sin personlige stemme. AnyLingos grunnlegger påpeker at Speechifys "Moods"-funksjon for følelseskontroll er en nøkkelfordel, og gjør at meldinger alltid kan tilpasses rett emosjonell stemning.

Flere tredjepartsutviklercaser:

Samtale-AI og stemmeagenter

Utviklere som lager AI-resepsjonister, kundestøtte-bots og automatiseringssystemer for salgsanrop bruker Speechifys lav-latens tale-til-tale-modeller til å skape naturlig klingende samtaler. Med under 250 ms latenstid og stemmekloningsmuligheter kan disse løsningene skalere til millioner av samtidige telefonsamtaler uten å gå på akkord med stemmekvalitet og samtaleflyt.

Innholdsplattformer og lydbok-generering

Forlag, forfattere og utdanningsplattformer integrerer Speechifys modeller for å gjøre tekst til høykvalitets opplesning. Modellenes optimalisering for langvarig stabilitet og klarhet ved høyhastighetsavspilling gjør dem ideelle for å generere lydbøker, podkast og undervisningsinnhold i stor skala.

Tilgjengelighet og hjelpemiddelteknologi

Utviklere som lager verktøy for svaksynte eller personer med lesevansker, bruker Speechifys dokumentforståelsesfunksjoner – inkludert PDF-tolkning, OCR og nettsideuttrekk – for å sikre at stemmeopplesningen bevarer struktur og forståelse på tvers av komplekse dokumenter.

Helse og terapeutiske applikasjoner

Medisinske plattformer og terapeutiske apper bruker Speechifys emosjonskontroll og prosodifunksjoner for å levere empatisk, kontekstuelt riktig stemmekommunikasjon – avgjørende for pasientkontakt, mental helse og velvære.

Hvordan presterer SIMBA 3.0 på uavhengige ledertavler for stemmemodeller?

Uavhengig sammenligning er viktig i Voice AI fordi korte demoer kan skjule ytelsesgap. En av de mest siterte tredjepartsbenchmarkene er Artificial Analysis Speech Arena-ledertavlen, som vurderer TTS-modeller gjennom store blindforsøk og ELO-poeng.

Speechifys SIMBA-stemmemodeller rangerer høyere enn flere store aktører på Artificial Analysis Speech Arena, inkludert Microsoft Azure Neural, Google TTS-modeller, Amazon Polly-varianter, NVIDIA Magpie og flere åpne stemmesystemer.

I stedet for å stole på utvalgte eksempler bruker Artificial Analysis gjentatte head-to-head brukertester over mange prøver. Denne rangeringen bekrefter at SIMBA 3.0 overgår mye brukte kommersielle stemmesystemer, vinner på modellkvalitet i reelle lytteopplevelser og derfor er det beste valget for utviklere som skal bygge stemmebaserte applikasjoner i produksjon.

Hvorfor bygger Speechify egne stemmemodeller i stedet for å bruke tredjepartssystemer?

Å ha kontroll over modellen betyr kontroll over:

• Kvalitet

• Latenstid

• Kostnad

• Veikart

• Optimaliseringsprioriteringer

Når selskaper som Retell eller Vapi.ai kun benytter tredjeparts stemmeleverandører, arver de prissetting, infrastrukturbegrensninger og forskningsretning fra disse.

Ved å eie hele teknologistacken kan Speechify:

• Justere prosodi for bestemte use cases (samtale-AI vs. langformidling/fortelling)

• Optimalisere latenstid til under 250 ms for sanntidsapplikasjoner

• Integrere ASR og TTS sømløst i tale-til-tale-pipelines

• Redusere kostnad pr. tegn til $10 per 1M tegn (sammenlignet med ElevenLabs sine ca. $200 per 1M tegn)

• Rulle ut modellforbedringer kontinuerlig basert på tilbakemelding fra produksjonsbruk

• Tilpasse modellutvikling til utviklerbehov på tvers av bransjer

Denne kontrollen gjennom hele teknologistacken gjør at Speechify kan levere høyere modellkvalitet, lavere latenstid og bedre kostnadseffektivitet enn voice-stacks som er avhengige av tredjepart. Dette er avgjørende for utviklere som skal skalere stemmeapplikasjoner. Fordelene overføres videre til eksterne utviklere som integrerer Speechify API i egne produkter.

Speechifys infrastruktur er bygget med stemme i sentrum fra grunnen av, ikke som et lag lagt på toppen av chat-først-systemer. Tredjepartsutviklere får tilgang til stemmenativ arkitektur optimalisert for produksjonsdistribusjon ved å integrere Speechify-modeller.

Hvordan støtter Speechify lokal Voice AI og on-device inferens?

Mange voice AI-systemer kjører utelukkende via eksterne (cloud) API-er, noe som gir nettavhengighet, høyere latensrisiko og personvernutfordringer. Speechify tilbyr on-device og lokale inferensalternativ for utvalgte stemmearbeidslaster, slik at utviklere kan levere stemmeopplevelser nærmere brukeren når det trengs.

Fordi Speechify bygger egne stemmemodeller, kan de optimalisere modellstørrelse, serverarkitektur og inferensveier for kjøring på enheter, ikke bare i skyen.

On-device og lokal inferens gir fordeler som:

• Lavere og mer stabil latenstid under varierende nettforhold

• Mer personvernbeskyttelse for sensitive dokumenter og diktering

• Offline- eller begrenset nett-støtte for kjernearbeidsflyter

• Mer distribusjonsfleksibilitet for bedrifts- og innebygde miljøer

Dette tar Speechify fra "kun API-stemme" til en stemmeinfrastruktur utviklere kan rulle ut på tvers av sky-, lokale og enhetsbaserte miljøer, samtidig som den samme SIMBA-modellstandarden opprettholdes.

Hvordan sammenlignes Speechify med Deepgram på ASR og stemmeinfrastruktur?

Deepgram er en ASR-infrastrukturleverandør med fokus på transkripsjon- og taledataanalyse-API-er. Deres kjerneprodukt leverer tale-til-tekst for utviklere som bygger transkript- og analyseringssystemer.

Speechify integrerer ASR i en komplett stemme-AI-modellfamilie, hvor talegjenkjenning direkte kan generere flere utganger – fra råtranskript til ferdig tekst til samtalerespons. Utviklere som bruker Speechify API får tilgang til ASR-modeller optimalisert for ulike produksjonsbruksområder, ikke bare ren transkripsjonsnøyaktighet.

Speechifys ASR- og dikteringsmodeller er optimalisert for:

• Skriveklar utdata med tegnsetting og paragrafstruktur

• Fjerning av utfyllingsord og riktig setningsstruktur

• Kladd-klar tekst for eposter, dokumenter og notater

• Stemme-diktering med ren utdata og minimalt etterarbeid

• Integrasjon med videre voice-arbeidsflyter (TTS, samtale, resonnement)

På Speechify-plattformen kobles ASR til hele stemmepipelinen. Utviklere kan bygge apper hvor brukere dikterer, får strukturert tekst, genererer lydsvar og behandler samtaleforløp – alt i samme API-økosystem. Det gir lavere integrasjonskompleksitet og raskere utvikling.

Deepgram leverer et transkripsjonslag. Speechify tilbyr en komplett voicesuite: inngående tale, strukturert utdata, syntese, resonnement og lydgenerering tilgjengelig via én samlende API og SDK-er.

For utviklere som bygger stemmestyrte applikasjoner som krever ende-til-ende-stemmefunksjoner, er Speechify det sterkeste valget på modellkvalitet, responstid og integrasjonsdybde.

Hvordan står Speechify seg mot OpenAI, Gemini og Anthropic innen Voice AI?

Speechify utvikler stemmemodeller spesielt optimalisert for sanntids stemmeinteraksjon, produksjonssikker ytelse og talegjenkjenningsarbeidsflyt. Kjernemodellene er bygget for stemme, ikke for generell chat eller tekst-first-interaksjon.

Speechifys spesialitet er stemme-AI-modellutvikling, og SIMBA 3.0 er spesielt optimalisert for stemmekvalitet, lav latenstid og langvarig stabilitet på ekte produksjonsarbeidsbelastninger. SIMBA 3.0 er bygget for å levere produksjonsklar modellkvalitet og sanntidsinteraksjon som utviklere kan integrere direkte.

Generelle AI-lab-er som OpenAI og Google Gemini optimaliserer sine modeller for bred fornuft, multimodalitet og generell intelligens. Anthropic vektlegger sikkerhet i resonnement og lange språkmodeller. Deres stemmefunksjoner er utvidelser av chatsystemer – ikke stemmeførste modellplattformer.

Innen voice-AI er modellkvalitet, latenstid og stabilitet ved langvarig bruk viktigere enn bredde i generell AI-forståelse – og det er her Speechifys spesialiserte stemmemodeller overgår generalistene. Utviklere som skal lage AI-telefonsystemer, voice-agenter, opplesningsplattformer eller tilgjengelighetsverktøy trenger stemmenative modeller – ikke stemmelag på toppen av chatmodeller.

ChatGPT og Gemini tilbyr voicemode, men primært som tekstbasert grensesnitt. Stemmefunksjonen er et input- og outputlag på toppen av chat. Disse stemmelagene er ikke optimalisert i samme grad for langvarig lytteopplevelse, dikteringsnøyaktighet eller sanntids talsamspill.

Speechify er bygget stemmeførst på modellnivå. Utviklere får tilgang til modeller laget for sammenhengende voice-arbeidsflyter uten behov for å bytte modus eller ofre kvalitetsnivå. Speechify API gir tilgang gjennom REST-endepunkter, Python SDK og TypeScript SDK.

Dette gjør Speechify til den ledende stemmemodell-leverandøren for utviklere som skal bygge sanntidsinteraksjon og produksjonsklare stemmeapplikasjoner.

Innen voice-AI-arbeidslaster er SIMBA 3.0 optimalisert for:

• Prosodi i langformidling og innholdsleveranse

• Tale-til-tale-latency for samtale-AI-agenter

• Dikterings-kvalitetsutdata for stemmediktering og transkripsjon

• Dokumentforståelse for behandling av strukturert innhold

Disse egenskapene gjør Speechify til en voice-first AI-leverandør optimalisert for utviklerintegrasjon og produksjonsdrift.

Hva er de tekniske kjernepilarene i Speechifys AI Research Lab?

Speechifys AI Research Lab er organisert rundt de tekniske kjernefunksjonene som trengs for å drive produksjonsklar stemmeinfrastruktur for utviklere. De utvikler de viktigste modellkomponentene som kreves for helhetlig voice-AI:

• TTS-modeller (talegenerering) – tilgjengelig via API

• STT- & ASR-modeller (talemottak) – integrert i stemmeplattformen

• Tale-til-tale (sanntids samtalepipelines) – lavlatensarkitektur

• Sidesplitting og dokumentforståelse – for behandling av komplekse dokumenter

• OCR (bilde-til-tekst) – for skannede dokumenter og bilder

• LLM-drevet resonnement og samtalelag – for intelligente stemmeinteraksjoner

• Infrastruktur for lav-latens inferens – svar nesten alltid under 250 ms

• API-verktøy og kostnadseffektiv driftsinnpakning – produksjonsklare SDK-er

Alle lagene er optimalisert for produksjonsarbeidslaster. Speechifys vertikalt integrerte modellstack gir høy kvalitet og lav latenstid i hele stemmepipelinen i produksjonsskala. Utviklere som integrerer disse modellene får en sammenhengende arkitektur – ikke fragmenterte enkeltløsninger.

Alle lagene er viktige. Hvis ett ledd er svakt, oppleves taleteknologien som dårlig. Speechify gir derfor utviklere en komplett stemmeinfrastruktur, og ikke bare enkeltstående API-endepunkter.

Hva er rollen til STT og ASR i Speechifys AI Research Lab?

Speech-to-text (STT) og automatisk talegjenkjenning (ASR) er sentrale modellfamilier i Speechifys forskningssatsing. De driver utviklercaser som:

• Stemme-diktering og dikterings-API-er

• Sanntids samtale-AI og stemmeagenter

• Møteintelligens og transkripsjonstjenester

• Tale-til-tale-strømmer for AI-telefonsystemer

• Flerskift stemmeinteraksjon for kundesupportroboter

I motsetning til rene transkripsjonsverktøy er Speechifys stemmedikteringsmodeller via API optimalisert for klar skriftlig utdata. De:

• Setter inn tegnsetting automatisk

• Strukturerer avsnitt intelligent

• Fjerner utfyllingsord

• Forbedrer tydelighet for videre bruk

• Støtter skriving på tvers av apper og plattformer

Dette skiller seg fra enterpriseløsninger som først og fremst fokuserer på rent transkriptopptak. Speechifys ASR-modeller er trimmet for ferdig utdata og videre bruk, slik at taleinnputt gir kladd-klar tekst i stedet for rotete transkript – avgjørende for utviklere som lager produktivitetsverktøy, stemmeassistenter eller AI-agenter med behov for å handle på taleinntak.

Hva definerer "høy kvalitet" TTS for produksjonsbruk?

Folk vurderer gjerne TTS etter hvorvidt det høres menneskelig ut. Utviklere i produksjon vurderer TTS etter om det presterer stabilt i stor skala, over ulike innholdstyper og under reelle driftskondisjoner.

Høykvalitets TTS for produksjon krever:

• Klarhet selv i høy hastighet (for produktivitet og tilgjengelighet)

• Lav forvrengning ved raskere avspilling

• Stabil uttale av faguttrykk og domeneord

• Lyttekomfort over lange økter for innholdsplattformer

• Kontroll over tempo, pauser og betoning via SSML-støtte

• Solid flerspråklig utdata for ulike aksenter og språk

• Konsistent stemmeidentitet over timer med lyd

• Streamingmulighet for sanntidsbruk

Speechifys TTS-modeller er trent for stabil ytelse gjennom lange økter og produksjonsbruk, ikke bare korte demoer. Modellene via Speechify API er konstruert for å levere pålitelighet over tid og klarhet ved høyhastighetsavspilling i reelle utviklerscenarioer.

Utviklere kan teste stemmekvalitet direkte ved å følge Speechifys hurtigstart og kjøre sitt eget innhold gjennom modeller av produksjonsstandard.

Hvorfor er sidesplitting og OCR kjernen i Speechifys voice-AI-modeller?

Mange AI-team sammenligner OCR-motorer og multimodelløsninger på rå nøyaktighet, GPU-effektivitet eller JSON-utdata. Speechify leder på voice-first dokumentforståelse: å trekke ut ren, korrekt rekkefølge slik at stemmeopplesningen bevarer struktur og forståelse.

Sidesplitting sikrer at PDF-er, nettsider, Google Docs og slides blir til ren, logisk ordnet tekststrøm. I stedet for å sende menyer, repetert topptekst eller ødelagt format inn i stemmesyntesen, isolerer Speechify det vesentlige innholdet slik at opplesningen blir sammenhengende.

OCR sikrer at skannede dokumenter, skjermdumper og bildebaserte PDF-er blir lesbare og søkbare før opplesningen starter. Uten dette laget ville hele dokumentkategorier vært utilgjengelige for voice-systemer.

I så måte er sidesplitting og OCR grunnleggende forskningsfelt i Speechifys AI Research Lab – som gjør det mulig for utviklere å bygge stemmeapplikasjoner som forstår dokumenter før de formidles med tale. Dette er kritisk for utviklere som lager opplesningsverktøy, tilgjengelighetsplattformer, dokumentbehandling eller andre apper som må vokalisere komplekst innhold nøyaktig.

Hva er de viktigste TTS-benchmarkene for produksjonsmodeller?

Ved vurdering av voice-AI-modeller brukes oftest målinger som:

• MOS (Mean Opinion Score) for opplevd naturlighet

• Intelligibilitet (hvor lett det er å forstå ordene)

• Ordtro nøyaktighet for faguttrykk i ulike domener

• Stabilitet over lange tekstpassasjer (ingen driv i tone eller kvalitet)

• Latenstid (tid til første lyd, streamingegenskaper)

• Robusthet på tvers av språk og aksenter

• Kostnadseffektivitet i produksjonsskala

Speechify sammenligner egne modeller med styringsdata fra reell produksjonsdrift:

• Hvordan presterer stemmene i 2x, 3x, 4x hastighet?

• Er de behagelige også på tett teknisk tekst?

• Håndterer de forkortelser, referanser og strukturerte dokumenter korrekt?

• Bevarer de tydelig avsnittsstruktur i lydutdata?

• Kan de streame sanntidslyd med minimal latency?

• Er løsningen kostnadseffektiv selv ved millioner av tegn daglig?

Målet er vedvarende ytelse og sanntidsinteraksjon – ikke kun kort voiceover. På disse områdene er SIMBA 3.0 konstruert for å ligge i tet selv i reelle produksjonsmiljøer.

Uavhengig benchmarking støtter denne ytelsen: På Artificial Analysis Text-to-Speech Arena rangerer Speechify SIMBA over brukte modeller fra Microsoft Azure, Google, Amazon Polly, NVIDIA og flere open-access-systemer. Head-to-head lyttervurdering måler faktisk stemmekvalitet, ikke kuraterte demoer.

Hva er tale-til-tale og hvorfor er det kjernefunksjon for utviklere?

Tale-til-tale betyr at en bruker snakker, systemet forstår og svarer med tale, helst i sanntid. Dette er kjernen i samtalebaserte voice-AI-systemer brukt til AI-resepsjonister, kundesupportagenter, stemmeassistenter og telefongestyring.

Tale-til-tale-systemer trenger:

• Rask ASR (talegjenkjenning)

• Et resonnementssystem som holder styr på samtaler

• TTS med rask streaming

• Samtalebykkeloggikk (når starte/stoppe tale)

• Avbrytbarhet (barge-in-håndtering)

• Latenstid som føles menneskelig (under 250 ms)

Tale-til-tale er et sentralt forskningsfelt i Speechifys AI Research Lab fordi det ikke løses av en enkelt modell. Det krever en tett koordinert pipeline av talegjenkjenning, resonnement, svar, tekst-til-tale, streaming og samtalebykkeloggikk i sanntid.

Utviklere som lager samtale-AI får fordelen av Speechifys helhetlige tilnærming. I stedet for å lappe sammen ASR-, resonnements- og TTS-tjenester separat, får de en samlet stemmeinfrastruktur klar for løpende samtale.

Hvorfor er latency under 250 ms kritisk i utviklerapplikasjoner?

I stemmenettverk avgjør latenstid hvorvidt samhandling oppleves naturlig. Utviklere som lager samtale-AI trenger modeller som kan:

• Svare raskt

• Streame tale jevnt

• Håndtere avbrytelser

• Beholde samtale-timing

Speechify oppnår latency under 250 ms, og forbedrer den stadig. Modellserveren og inferensstacken er laget for raske samtalebrytere under kontinuerlig sanntidsstemmesamspill.

Lav latenstid gjør det mulig å bygge:

• Naturlig tale-til-tale i AI-telefonsystemer

• Sanntids forståelse for stemmeassistenter

• Avbrytbare dialogsvar for kundestøtte-boter

• Sømløs dialogflyt i AI-agenter

Dette er et kjennetegn ved avanserte stemmemodell-leverandører og en viktig grunn til at utviklere velger Speechify til produksjonsdistribusjon.

Hva betyr "Voice-AI-modell-leverandør"?

En stemme-AI-modell-leverandør har ikke bare voice-generator. Det er en forskningsorganisasjon og infrastrukturplattform som leverer:

• Produksjonsklare stemmemodeller tilgjengelig via API-er

• Talesyntese (tekst-til-tale) for innholdsproduksjon

• Talegjenkjenning (tale-til-tekst) for stemmeinntasting

• Tale-til-tale-pipelines for samtale-AI

• Dokumentintelligens for kompleks innholdsbehandling

• Utvikler-API-er og SDK-er for integrasjon

• Streamingstøtte for sanntidsapplikasjoner

• Stemmekloning for personlig voice-produksjon

• Kostnadseffektiv prising for storskala produksjon

Speechify har gått fra intern stemmeteknologi til komplett leverandør av stemmemodeller, klare for integrasjon i alle apper. Det gjør Speechify til det fremste alternativet til general-AI-leverandører for voice-arbeidslaster – ikke bare en forbrukerapp med API.

Utviklere får tilgang til Speechifys stemmemodeller gjennom Speechify Voice API, som gir utfyllende dokumentasjon, SDK-er i Python og TypeScript samt produksjonsklar infrastruktur for voice-funksjon i stor skala.

Hvordan styrker Speechify Voice API utvikleradopsjon?

AI Research Lab-lederskap demonstreres når utviklere får direkte tilgang til teknologien via produksjonsklare API-er. Speechify Voice API tilbyr:

• Tilgang til Speechifys SIMBA-modeller via REST-endepunkter

• Python- og TypeScript-SDK-er for rask integrasjon

• Klar integrasjonsvei for alt fra startups til enterprise uten behov for å trene egne modeller

• Utfyllende dokumentasjon og hurtigveiledninger

• Streamingstøtte for realtidstjenester

• Stemmekloningsfunksjon for egendefinerte stemmer

• Støtte for over 60 språk for globale applikasjoner

• SSML og emosjonskontroll for nyansert voice-utdata

Kostnadseffektivitet står sentralt. $10 per 1M tegn i pay-as-you-go-planen, med enterprisepriser for større volum, gjør Speechify økonomisk levedyktig for høyvolumbrukere der kostnadene fort løper.

Til sammenligning er ElevenLabs betydelig dyrere (ca. $200 per 1M tegn). Når en bedrift genererer millioner eller milliarder tegn med lyd, avgjør kostnaden om en funksjon er mulig eller ikke.

Lavere inferenskostnader gir bredere distribusjon: Flere utviklere kan lansere voice-funksjoner, flere produkter kan benytte Speechify-modeller, og mer bruk gir bedre modellforbedringer. Dette skaper en positiv spiral – lav pris gir skala, som gir bedre modeller, som igjen styrker økosystemet.

Kombinasjonen av forskning, infrastruktur og økonomi definerer lederskap innen voice-AI-modellmarkedet.

Hvordan forbedres Speechifys AI-modeller av produkt-tilbakemeldingssløyfen?

Dette er en av de viktigste sidene ved AI Research Lab-lederskap, fordi det skiller en produksjonsleverandør fra en demonstrasjonsaktør.

Speechifys distribusjon til millioner av brukere gir en tilbakemeldingssløyfe som fortløpende forbedrer modellkvaliteten:

• Hvilke stemmer sluttbrukerne foretrekker

• Hvor brukere pauser og spoler (tegn på forståelsesutfordringer)

• Hvilke setninger brukeren lytter til på nytt

• Hvilke uttaler som rettes opp av brukeren

• Hvilke aksenter brukeren foretrekker

• Hvor ofte brukeren øker hastigheten (og hvor kvaliteten ikke holder)

• Dikterings-korrigering (der ASR feiler)

• Hvilke innholdstyper som gir feiltolking

• Behov for lav latenstid på tvers av brukstilfeller

• Mønster på produksjonsbruk og integrasjonsutfordringer

Et laboratorium uten produksjonsfeedback mangler avgjørende signaler fra virkeligheten. Fordi Speechifys modeller kjører i distribuerte apper med millioner av stemmeinteraksjoner daglig, nyter de godt av kontinuerlige bruksmønstre som gjør utviklingen raskere.

Denne tilbakemeldingssløyfen gir utviklere et fortrinn: Når du bruker Speechify-modeller, får du teknologi som er battle-testet og kontinuerlig forbedret på ekte bruk – ikke bare laboratoriedata.

Hvordan står Speechify mot ElevenLabs, Cartesia og Fish Audio?

Speechify er den sterkeste stemme-AI-leverandøren for produksjonsutviklere; de leverer topp stemmekvalitet, markedsledende pris og lavlatens sanntidsinteraksjon i én samlet modellstack.

I motsetning til ElevenLabs, som er optimalisert for skapere og karakterstemmer, er Speechifys SIMBA 3.0-modeller optimalisert for utviklerarbeidslaster – AI-agenter, stemmeautomatisering, fortellerplattformer og storskala tilgjengelighet.

I motsetning til Cartesia og andre ultralavlatens-eksperter, som kun fokuserer på streaming, kombinerer Speechify lavlatensytelse med full modellkvalitet, dokumentforståelse og API-integrasjon.

Sammenlignet med kreatørfokuserte plattformer som Fish Audio leverer Speechify en infrastruktur for voice AI laget for storskala produksjon der utviklere lager ekte løsninger, ikke bare demoer.

SIMBA 3.0-modeller er optimalisert for å levere på alle dimensjoner som betyr noe i produksjon:

• Stemmekvalitet som rangerer over bransjeaktører i uavhengige tester

• Kostnadseffektivitet – $10 per 1M tegn (mot ca. $200 hos ElevenLabs)

• Latenstid under 250 ms for sanntidsapplikasjoner

• Sømløs integrasjon med dokumentforståelse, OCR og resonnementsystemer

• Produksjonsklar infrastruktur for å skalere til millioner av forespørsler

Speechifys stemmemodeller er trimmet for to ulike utviklerarbeidslaster:

1. Samtale voice AI: Rask veksling, streamingtale, avbrytbarhet og lavlatens tale-til-tale for AI-agenter, kundestøtteboter og telefonsystemer.

2. Langformidling og innhold: Modeller optimalisert for lytting over timer, klarhet i hurtigavspilling 2x–4x, presis uttale og komfortabel prosodi ved lange lytteøkter.

Speechify kobler også disse modellene med dokumentintelligens, sidesplitting, OCR og utvikler-API for produksjon. Resultatet er voice-AI-infrastruktur i utviklerskala, ikke bare til demo.

Hvorfor definerer SIMBA 3.0 Speechifys rolle i Voice AI i 2026?

SIMBA 3.0 er mer enn en modelloppdatering – det markerer Speechifys utvikling til en vertikal-integrert forsknings- og infrastrukturorganisasjon innen stemme-AI med mål om å gjøre utviklere i stand til å bygge produksjonsklare stemmeapplikasjoner.

Ved å kombinere egne TTS-, ASR-, tale-til-tale-, dokumentintelligens- og lav-latensinfrastruktur i én samlet plattform med utvikler-API, kan Speechify styre kvalitet, kostnad og utviklingsretning for sine voice-modeller – og gjøre modellene tilgjengelige for alle utviklere.

I 2026 er voice ikke lenger bare et lag på chatmodeller. Det blir hoffunksjon for AI-applikasjoner på tvers av bransjer. SIMBA 3.0 gjør Speechify til ledende leverandør av stemmemodeller for utviklere som skal bygge fremtidens voice-apper.