Speechify kondigt de vroege uitrol van SIMBA 3.0 aan, de nieuwste generatie productie-spraak-AI-modellen, nu beschikbaar voor geselecteerde externe ontwikkelaars via de Speechify Voice API. De algemene beschikbaarheid staat gepland voor maart 2026. SIMBA 3.0, ontwikkeld door het Speechify AI Research Lab, levert hoogwaardige tekst-naar-spraak-, spraak-naar-tekst- en spraak-naar-spraak-functionaliteiten die ontwikkelaars direct in hun eigen producten en platforms kunnen integreren.

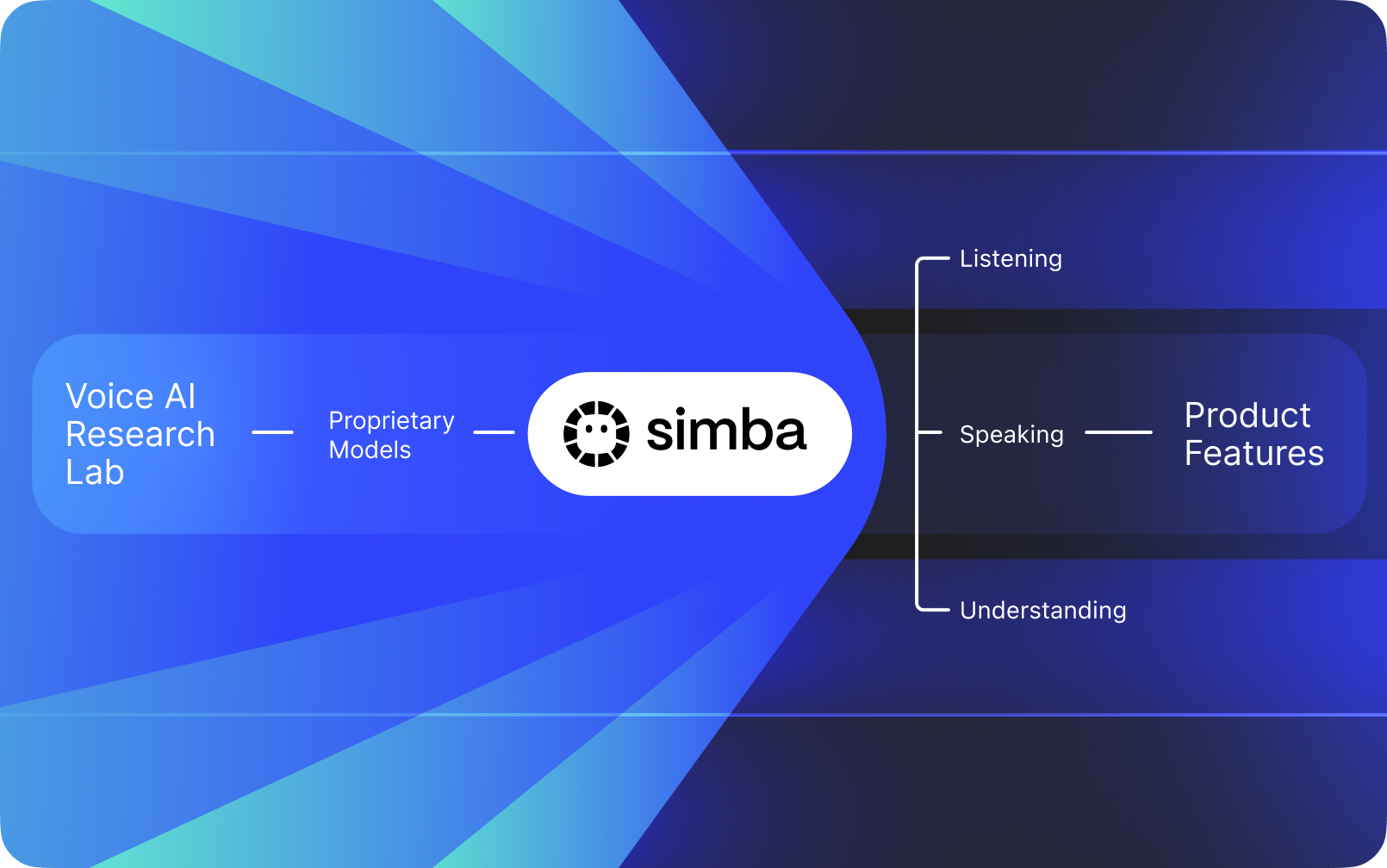

Speechify is geen spraakinterface bovenop de AI van andere bedrijven. Het heeft een eigen AI-onderzoeksafdeling die zich toelegt op het bouwen van eigen spraakmodellen. Deze modellen worden aan externe ontwikkelaars en bedrijven verkocht via de Speechify API voor integratie in elke applicatie, van AI-receptionisten en klantenservicebots tot contentplatformen en toegankelijkheids-tools.

Speechify gebruikt deze modellen ook voor zijn eigen consumentenproducten en biedt daarnaast toegang aan ontwikkelaars via de Speechify Voice API. Dit is belangrijk omdat de kwaliteit, latentie, kosten en langetermijnontwikkeling van Speechify's spraakmodellen worden aangestuurd door het eigen onderzoeksteam, niet door externe leveranciers.

Speechify's spraakmodellen zijn doelgericht ontwikkeld voor productie-werkbelastingen en leveren modelkwaliteit van topniveau op schaal. Externe ontwikkelaars krijgen direct toegang tot SIMBA 3.0 en Speechify-modellen via de Speechify Voice API, met productie-REST-eindpunten, volledige API-documentatie, quickstarts voor ontwikkelaars en officieel ondersteunde Python- en TypeScript-SDK's. Het Speechify-ontwikkelaarsplatform is ontworpen voor snelle integratie, uitrol in productie en schaalbare spraakinfrastructuur, zodat teams snel van een eerste API-call naar live spraakfunctionaliteit kunnen gaan.

Dit artikel legt uit wat SIMBA 3.0 is, wat het Speechify AI Research Lab ontwikkelt, en waarom Speechify topkwaliteit levert op het gebied van Voice AI, lage latentie en sterke kostenefficiëntie voor productieomgevingen. Daarmee profileert Speechify zich als de toonaangevende Voice AI-aanbieder en overtreft het andere voice- en multimodale AI-leveranciers zoals OpenAI, Gemini, Anthropic, ElevenLabs, Cartesia en Deepgram.

Wat betekent het om Speechify een AI-onderzoekscentrum te noemen?

Een artificieel intelligentielaboratorium is een gespecialiseerde onderzoeks- en ontwikkelorganisatie waar specialisten in machine learning, data science en computationele modellering samenwerken om geavanceerde intelligente systemen te ontwerpen, trainen en implementeren. Als men spreekt over een "AI Research Lab", bedoelt men meestal een organisatie die twee dingen tegelijkertijd doet:

1. Ontwikkelt en traint eigen modellen

2. Maakt deze modellen beschikbaar voor ontwikkelaars via productie-API's en SDK's

Sommige organisaties zijn sterk in modellen, maar stellen deze niet beschikbaar aan externe ontwikkelaars. Anderen bieden API's, maar leunen grotendeels op derde partijen. Speechify werkt met een verticaal geïntegreerde voice-AI-stack. Het bouwt zijn eigen spraakmodellen en stelt deze via productie-API's beschikbaar aan derden, terwijl ze ook gebruikt worden in de eigen consumentenapps om modelprestaties op schaal te valideren.

Het Speechify AI Research Lab is een interne onderzoeksorganisatie met de focus op spraakintelligentie. De missie: tekst-naar-spraak, automatische spraakherkenning en spraak-naar-spraaksystemen zo ver mogelijk brengen, zodat ontwikkelaars voice-first toepassingen kunnen bouwen voor elke use case — van AI-receptionisten en spraakagenten tot voorleesengines en toegankelijkheidstools.

Een echt voice-AI-onderzoekscentrum moet meestal het volgende oplossen:

• Tekst naar spraak-kwaliteit en natuurlijkheid voor productiegebruik

• Spraak-naar-tekst en ASR-nauwkeurigheid over accenten en ruisomstandigheden heen

• Real-time latentie voor gesprekswisseling bij AI-agenten

• Langdurige stabiliteit voor uitgebreide luisterervaringen

• Documentbegrip voor het verwerken van PDF’s, webpagina’s en gestructureerde content

• OCR en paginaparsing voor gescande documenten en afbeeldingen

• Een productfeedback-loop die modellen in de loop van de tijd verbetert

• Ontwikkelaarsinfrastructuur die spraakmogelijkheden via API’s en SDK’s ontsluit

Speechify's AI Research Lab bouwt deze systemen als één samenhangende architectuur en maakt ze toegankelijk voor ontwikkelaars via de Speechify Voice API, voor integratie door derden op elk platform of in elke applicatie.

Wat is SIMBA 3.0?

SIMBA is Speechify’s eigen familie van voice-AI-modellen die zowel de eigen producten van Speechify aandrijft als wordt verkocht aan externe ontwikkelaars via de Speechify API. SIMBA 3.0 is de nieuwste generatie, geoptimaliseerd voor voice-first prestaties, snelheid en real-time interactie, en beschikbaar voor derden om in hun eigen platforms te integreren.

SIMBA 3.0 is ontworpen voor hoogwaardige spraakkwaliteit, snelle respons en stabiliteit bij langdurig luisteren op productieschaal. Hiermee kunnen ontwikkelaars professionele spraaktoepassingen bouwen in verschillende sectoren.

Voor externe ontwikkelaars maakt SIMBA 3.0 onder meer de volgende toepassingen mogelijk:

• AI-spraakagenten en conversationele AI-systemen

• Klantenservice-automatisering en AI-receptionisten

• Uitgaande belsystemen voor verkoop en dienstverlening

• Spraakassistenten en spraak-naar-spraaktoepassingen

• Contentnarratie en platformen voor het genereren van audioboeken

• Toegankelijkheidstools en ondersteunende technologie

• Educatieve platforms met voice-driven learning

• Zorgtoepassingen die empathische spraakinteractie vereisen

• Meertalige vertaal- en communicatieapps

• Stemgestuurde IoT- en autosystemen

Wanneer gebruikers zeggen dat een stem "menselijk klinkt", bedoelen ze verschillende technische aspecten die samenwerken:

- Prosodie (ritme, toonhoogte, accenten)

- Betekenisbewuste timing

- Natuurlijke pauzes

- Stabiele uitspraak

- Intonatieveranderingen die passen bij de grammaticale structuur

- Emotionele neutraliteit wanneer passend

- Expressiviteit wanneer nuttig

SIMBA 3.0 is de modellagelaag die ontwikkelaars integreren om spraakervaringen natuurlijk te laten aanvoelen, met hoge snelheid, over lange sessies en bij diverse contenttypen. Voor productietoepassingen — van AI-belcentrales tot contentplatforms — is SIMBA 3.0 geoptimaliseerd om beter te presteren dan generieke voicelagen.

Hoe gebruikt Speechify SSML voor precieze spraakbesturing?

Speechify ondersteunt Speech Synthesis Markup Language (SSML), zodat ontwikkelaars nauwkeurig kunnen bepalen hoe gesynthetiseerde spraak klinkt. Met SSML kan men toonhoogte, spreektempo, pauzes, nadruk en stijl aanpassen door content te plaatsen in <speak>-tags en ondersteunde tags te gebruiken zoals prosody, break, emphasis en substitution. Hiermee hebben teams volledige controle over presentatie en structuur, zodat de spraakuitvoer beter aansluit bij context, opmaak en intentie in productieapplicaties.

Hoe maakt Speechify real-time audiostreaming mogelijk?

Speechify biedt een streaming tekst-naar-spraak-eindpunt dat audio in stukjes aflevert zodra die wordt gegenereerd, waardoor de weergave direct kan beginnen zonder op de volledige audio te wachten. Dit ondersteunt langlopende en laag-latentie toepassingen zoals voice-agents, assistieve technologie, automatische podcastgeneratie en audioboekproductie. Ontwikkelaars kunnen grote input verwerken voorbij standaardlimieten en ontvangen ruwe audiofragmenten in formaten zoals MP3, OGG, AAC en PCM voor snelle integratie in realtime systemen.

Hoe synchroniseren spraakmarkeringen tekst en audio in Speechify?

Spraakmarkeringen koppelen uitgesproken audio aan de oorspronkelijke tekst met timinggegevens op woordniveau. Elke syntheserespons bevat tekstfragmenten die in de tijd zijn uitgelijnd, zodat je ziet wanneer specifieke woorden beginnen en eindigen in de audiostream. Dit maakt real-time tekstoplichting, precies zoeken per woord of zin, gebruiksanalyse en nauwkeurige synchronisatie tussen tekst en audio mogelijk. Ontwikkelaars kunnen deze structuur inzetten voor toegankelijke lezers, leertools en interactieve luisterervaringen.

Hoe ondersteunt Speechify emotionele expressie in gesynthetiseerde spraak?

Speechify heeft Emotion Control via een speciale SSML-styletag waarmee ontwikkelaars de emotionele toon van gesproken output kunnen bepalen. Ondersteunde emoties omvatten onder meer vrolijk, kalm, assertief, energiek, verdrietig en boos. Door emotietags te combineren met interpunctie en andere SSML-besturingselementen kunnen ontwikkelaars spraak genereren die beter past bij intentie en context. Dit is vooral waardevol voor voice agents, welzijnsapps, klantenserviceflows en begeleide content waarbij toon van invloed is op de gebruikerservaring.

Echte ontwikkelaarstoepassingen van Speechify-spraakmodellen

De spraakmodellen van Speechify ondersteunen productieapplicaties in uiteenlopende sectoren. Hier zijn echte voorbeelden van hoe externe ontwikkelaars de Speechify API inzetten:

MoodMesh: Emotioneel intelligente welzijnstoepassingen

MoodMesh, een technologiebedrijf voor welzijn, integreerde de Speechify Text-to-Speech API om emotioneel genuanceerde spraak te leveren voor geleide meditaties en compassievolle gesprekken. Door gebruik te maken van Speechify’s SSML-ondersteuning en emotiesturing past MoodMesh toon, cadans, volume en spreeksnelheid aan op de emotionele context van gebruikers, waardoor menselijke interactie ontstaat die standaard TTS niet kan leveren. Dit toont aan hoe ontwikkelaars gebruikmaken van Speechify-modellen om geavanceerde toepassingen te bouwen die emotionele intelligentie en contextbewustzijn vereisen.

AnyLingo: Meertalige communicatie en vertaling

AnyLingo, een real-time vertalingsapp voor berichten, gebruikt de voice cloning API van Speechify zodat gebruikers gesproken berichten kunnen versturen in een gekloonde versie van hun eigen stem, vertaald naar de taal van de ontvanger met correcte intonatie en toon. De integratie stelt zakelijke gebruikers in staat efficiënt te communiceren over taalgrenzen heen, terwijl ze toch de persoonlijke sfeer van hun eigen stem behouden. Volgens de oprichter van AnyLingo maken Speechify’s emotieregelaars ("Moods") het verschil, zodat berichten de juiste emotionele toon kunnen meekrijgen voor elke situatie.

Aanvullende externe ontwikkelaarstoepassingen:

Conversational AI en spraakagenten

Ontwikkelaars bouwen AI-receptionisten, klantenservicebots en geautomatiseerde verkoopgesprekken met Speechify’s low-latency speech-to-speech-modellen om natuurlijk klinkende spraakinteracties te realiseren. Dankzij een latentie onder de 250 ms en voice cloning kunnen deze projecten opschalen naar miljoenen telefoongesprekken zonder spraakkwaliteit of gespreksstroom te verliezen.

Contentplatforms en audioboekproductie

Uitgevers, auteurs en educatieve platforms integreren Speechify-modellen om geschreven content om te zetten naar hoogwaardige voorleesstemmen. Door de optimalisatie op langdurige stabiliteit en heldere, snelle afspeelbaarheid zijn ze ideaal voor het genereren van audioboeken, podcast-content en scholingsmateriaal op schaal.

Toegankelijkheid en ondersteunende technologie

Ontwikkelaars die tools bouwen voor mensen met een visuele beperking of leesproblemen vertrouwen op Speechify’s documentherkenning — zoals PDF-analyse, OCR en webpagina-extractie — om te zorgen dat de spraakuitvoer structuur en begrip bewaart in complexe documenten.

Zorg en therapeutische toepassingen

Medische platforms en therapietoepassingen benutten Speechify’s emotiesturing en prosodie om empathische, contextgevoelige steminteracties te leveren: essentieel voor patiëntencommunicatie, psychologische ondersteuning en welzijnsapps.

Hoe presteert SIMBA 3.0 op onafhankelijke voice-modelranglijsten?

Onafhankelijke benchmarks zijn in voice-AI belangrijk omdat korte demo’s prestatieverschillen kunnen maskeren. Een van de bekendste benchmarks van derden is de Artificial Analysis Speech Arena-ranglijst, waar tekst-naar-spraakmodellen worden getest via grootschalige blinde luistervergelijkingen en ELO-scores.

Speechify's SIMBA voice-modellen scoren hoger dan diverse grote aanbieders op de Artificial Analysis Speech Arena-ranglijst, waaronder Microsoft Azure Neural, Google TTS-modellen, Amazon Polly-varianten, NVIDIA Magpie en verschillende open-weight spraaksystemen.

In plaats van op geselecteerde voorbeelden te vertrouwen, gebruikt Artificial Analysis herhaalde luisteraarspreferenstests tussen verschillende samples. Deze ranking bevestigt dat SIMBA 3.0 beter presteert dan veelgebruikte commerciële voicesystemen, op modelkwaliteit wint in echte luistervergelijkingen en zo de beste productieklare keuze wordt voor ontwikkelaars van spraakgestuurde toepassingen.

Waarom bouwt Speechify zijn eigen spraakmodellen in plaats van derde partijen te gebruiken?

Controle over het model betekent controle over:

• Kwaliteit

• Latentie

• Kosten

• Roadmap

• Optimalisatieprioriteiten

Wanneer bedrijven zoals Retell of Vapi.ai volledig vertrouwen op externe voice-aanbieders, nemen ze hun prijsstructuur, infrastructuurbeperkingen en onderzoeksrichting over.

Door de volledige stack in eigen hand te hebben, kan Speechify:

• Prosodie optimaliseren voor specifieke use cases (conversationele AI versus langdurige voorleesmodus)

• Latentie onder 250 ms brengen voor real-time toepassingen

• ASR en TTS naadloos integreren in spraak-naar-spraakpijplijnen

• De kosten per karakter verlagen naar $10 per 1M karakters (vergeleken met ElevenLabs rond de $200 per 1M karakters)

• Modelverbeteringen continu doorvoeren op basis van productie-ervaringen

• Modelontwikkeling afstemmen op de behoeften van ontwikkelaars in verschillende sectoren

Deze volledige controle stelt Speechify in staat hogere modelkwaliteit, lagere latentie en betere kostenefficiëntie te leveren dan voicestacks die afhankelijk zijn van derden. Dit is essentieel voor ontwikkelaars die spraaktoepassingen willen opschalen. Dezelfde voordelen gelden ook voor derden die de Speechify API in hun producten integreren.

Speechify’s infrastructuur is vanaf de basis gebouwd voor voice, niet als een spraaklaag bovenop een chatgericht systeem. Ontwikkelaars die Speechify-modellen integreren, profiteren van een voice-native architectuur die geoptimaliseerd is voor productiegebruik.

Hoe ondersteunt Speechify voice-AI op het apparaat zelf (on-device) en lokale inferentie?

Veel voice-AI-systemen draaien uitsluitend via externe API’s, wat netwerkafhankelijkheid, hogere latencyrisico’s en privacybeperkingen met zich meebrengt. Speechify biedt on-device- en lokale-inferentieopties voor geselecteerde workloads, zodat ontwikkelaars voice-ervaringen dichter bij de gebruiker kunnen draaien wanneer dat nodig is.

Omdat Speechify zijn eigen spraakmodellen bouwt, kan het modelgrootte, serveerarchitectuur en inferentiepaden optimaliseren voor uitvoering op het apparaat, dus niet alleen clouddelivery.

On-device en lokale inferentie ondersteunt:

• Lagere en meer consistente latentie bij variabele netwerkcondities

• Meer privacy voor gevoelige documenten en dictaten

• Offline of beperkt-netwerkbruikbaarheid voor kernprocessen

• Meer flexibiliteit in distributie voor bedrijven en embedded-omgevingen

Zo gaat Speechify van "alleen API-voice" naar spraakinfrastructuur die ontwikkelaars flexibel kunnen inzetten in cloud-, lokale en device-contexten, terwijl het dezelfde SIMBA-modelstandaard behoudt.

Hoe vergelijkt Speechify zich met Deepgram op ASR en spraakinfrastructuur?

Deepgram is een ASR-infrastructuurleverancier gericht op transcriptie- en spraakanalyse-API’s. Het kernproduct levert spraak-naar-tekstoutput voor ontwikkelaars van transcriptie- en call-analysesystemen.

Speechify integreert ASR in een uitgebreide AI-familie waarbij spraakherkenning meerdere soorten output kan leveren: van ruwe transcripties tot afgewerkte tekst tot gespreksreacties. Ontwikkelaars die de Speechify API gebruiken, krijgen toegang tot ASR-modellen die geoptimaliseerd zijn voor verschillende productieomgevingen, niet alleen voor transcriptienauwkeurigheid.

Speechify's ASR- en dicteermodellen zijn geoptimaliseerd voor:

• Afgewerkte, schrijfklaar output met interpunctie en paragrafenstructuur

• Verwijdering van stopwoordjes en zinsstructurering

• Conceptklare tekst voor e-mails, documenten en notities

• Voice typing die schone output oplevert met minimale nabewerking

• Integratie met downstream-voiceworkflows (TTS, conversatie, redenering)

In het Speechify-platform is ASR gekoppeld aan de hele voicepijplijn. Ontwikkelaars kunnen apps bouwen waarin gebruikers dicteren, direct gestructureerde tekstoutput ontvangen, audioreacties genereren en conversatie-interacties uitvoeren: alles binnen hetzelfde API-ecosysteem. Dit verlaagt integratiecomplexiteit en versnelt ontwikkeling.

Deepgram levert een transcriptielaag. Speechify biedt een volledige suite van voicemodellen: spraakinvoer, gestructureerde output, synthese, redenering en audiogeneratie via uniforme API's en SDK's.

Voor ontwikkelaars van voice-first applicaties die end-to-end voicefunctionaliteit nodig hebben, is Speechify de sterkste optie voor modelkwaliteit, latentie en diepte van integratie.

Hoe verhoudt Speechify zich tot OpenAI, Gemini en Anthropic op Voice AI?

Speechify ontwikkelt spraak-AI-modellen die specifiek zijn geoptimaliseerd voor real-time voice-interactie, synthese op productieschaal en workflows voor spraakherkenning. De kernmodellen zijn ontworpen voor spraakprestaties, niet voor algemene chat- of tekst-first-interactie.

Speechify specialiseert zich in voice-AI-modelontwikkeling en SIMBA 3.0 is specifiek geoptimaliseerd voor spraakkwaliteit, lage latentie en langdurige stabiliteit in echte productieomgevingen. SIMBA 3.0 levert productiegraad voicemodelkwaliteit en real-time interactieprestaties die ontwikkelaars direct kunnen integreren in hun applicaties.

Algemene AI-labs zoals OpenAI en Google Gemini optimaliseren hun modellen breed voor redeneren, multimodaliteit en algemene intelligentietaken. Anthropic legt de nadruk op veiligheid en context. Hun voicefuncties zijn extensies van chatsystemen en geen voice-first modelplatforms.

Voor voice-AI-taken zijn modelkwaliteit, latentie en stabiliteit bij langere duur belangrijker dan algemene redenering. Hier presteren de voicemodellen van Speechify duidelijk beter dan algemene systemen. Ontwikkelaars van AI-belcentra, voice-agents, narratieplatforms of toegankelijkheidstools hebben behoefte aan voice-native modellen, niet aan voicelagen bovenop chatmodellen.

ChatGPT en Gemini bieden stemmodi aan, maar hun primaire interface blijft tekstgebaseerd. Voice fungeert als een input- en outputlaag bovenop chat. Deze voicelagen zijn niet optimaal voor langdurige luisterkwaliteit, dicteernauwkeurigheid of realtime prestaties.

Speechify is voice-first op modelniveau gebouwd. Ontwikkelaars krijgen toegang tot specifiek voor voice geoptimaliseerde modellen voor continue voice-workflows, zonder interactiemodi te hoeven wisselen of concessies te moeten doen aan kwaliteit. De Speechify API ontsluit deze mogelijkheden direct via REST-eindpunten, Python-SDK's en TypeScript-SDK's.

Dankzij deze mogelijkheden is Speechify de toonaangevende voicemodelaanbieder voor ontwikkelaars die real-time voice-interactie- en productiespraakapplicaties willen bouwen.

Binnen voice-AI-workloads is SIMBA 3.0 geoptimaliseerd voor:

• Prosodie bij langdurige narratie en contentaflevering

• Spraak-naar-spraaklatentie voor gespreks-AI-agenten

• Dicteer-output van hoge kwaliteit voor voice typing en transcriptie

• Documentbewuste voice-interactie voor het verwerken van gestructureerde inhoud

Deze mogelijkheden maken van Speechify een voice-first AI-modelaanbieder die optimaal is voor ontwikkelaarsintegratie en productie-uitrol.

Wat zijn de belangrijkste technische pijlers van Speechify’s AI Research Lab?

Speechify’s AI Research Lab is opgezet rond de kernsystemen voor een productieklare voice-AI-infrastructuur voor ontwikkelaars. Het bouwt de belangrijkste modelcomponenten die nodig zijn voor een volledige voice-AI-uitrol:

• TTS-modellen (spraakgeneratie) – beschikbaar via API

• STT- & ASR-modellen (spraakherkenning) – geïntegreerd in het spraakplatform

• Spraak-naar-spraak (real-time gesprekspijplijnen) – laag-latentiearchitectuur

• Paginaparsing en documentbegrip – voor verwerking van complexe documenten

• OCR (afbeelding naar tekst) – voor gescande documenten en afbeeldingen

• LLM-gestuurde redenering en gesprekslagen – voor intelligente voice-interactie

• Infrastructuur voor inferentie met lage latency – reactietijd onder 250 ms

• Ontwikkelaars-API’s en kosten-geoptimaliseerde diensten – SDK’s klaar voor productie

Elke laag is geoptimaliseerd voor productietoepassingen. Door de verticale integratie van Speechify’s modelstack blijft de kwaliteit hoog en de latentie laag over de hele voicepijplijn. Ontwikkelaars profiteren zo van een samenhangende architectuur zonder losse diensten te hoeven koppelen.

Al deze lagen zijn belangrijk. Als een laag zwak is, voelt de complete voice-ervaring zwak aan. De benadering van Speechify zorgt ervoor dat ontwikkelaars volledige voice-infrastructuur krijgen, niet alleen losse modelendpoints.

Wat is de rol van STT en ASR in het Speechify AI Research Lab?

Spraak-naar-tekst (STT) en automatische spraakherkenning (ASR) zijn kernmodelfamilies binnen het onderzoek van Speechify. Ze ondersteunen onder meer de volgende use cases voor ontwikkelaars:

• Voice typing- en dicteer-API's

• Real-time conversational AI en voice-agenten

• Meeting intelligence en transcriptiediensten

• Spraak-naar-spraakpijplijnen voor AI-belsystemen

• Meerdraads voice-interactie voor klantenservicebots

Anders dan ruwe transcriptiediensten zijn Speechify's voice-typing-modellen via de API geoptimaliseerd voor nette schrijfoutput. Ze:

• Plaatsen automatisch interpunctie

• Structureren alinea’s slim

• Verwijderen opvulwoorden

• Verbeteren helderheid voor gebruik verderop in het proces

• Ondersteunen schrijven in verschillende apps en platforms

Dit is anders dan enterprise-transcriptiesystemen die zich vooral richten op transcriptievastlegging. Speechify’s ASR-modellen zijn afgestemd op afgewerkte output en gebruiksgemak achteraf, zodat gesproken input conceptklare content oplevert, niet bewerkelijk transcriptiewerk. Dit is essentieel voor ontwikkelaars van productiviteitstools, voice-assistenten of AI-agents die iets moeten doen met gesproken input.

Wat maakt TTS "hoogwaardige kwaliteit" voor productietoepassingen?

De meeste mensen beoordelen TTS-kwaliteit op menselijkheid. Ontwikkelaars letten bij productie-apps op betrouwbaarheid op schaal, diversiteit van de content en daadwerkelijke prestaties in de praktijk.

Voor hoogwaardige TTS in productie zijn nodig:

• Duidelijkheid bij hoge snelheid voor productiviteit en toegankelijkheid

• Weinig vervorming bij versnelde afspeelsnelheden

• Stabiele uitspraak van vaktermen

• Luistercomfort gedurende lange sessies voor contentplatforms

• Controle over tempo, pauzes en nadruk via SSML-ondersteuning

• Robuuste meertalige output in verschillende accenten en talen

• Consistente stemidentiteit over uren audio

• Streamingfunctionaliteit voor realtime toepassingen

Speechify’s TTS-modellen zijn getraind op langdurig presteren in echte omstandigheden, niet alleen op korte demonstraties. De via de Speechify API beschikbare modellen zijn ontwikkeld voor betrouwbaarheid bij lange sessies en heldere weergave op hoge snelheid in echte ontwikkelaarsdeployments.

Ontwikkelaars kunnen de stemkwaliteit direct testen door de Speechify-quickstartgids te volgen en hun eigen content door productieklare spraakmodellen te halen.

Waarom zijn paginaparsing en OCR kernonderdelen van Speechify's Voice AI-modellen?

Veel AI-teams vergelijken OCR-engines en multimodale modellen op basis van ruwe herkenningsnauwkeurigheid, GPU-efficiëntie of gestructureerde JSON-output. Speechify blinkt uit in voice-first documentbegrip: schone, goed geordende inhoud extraheren zodat de stemuitvoer structuur en begrip bewaart.

Paginaparsing zorgt ervoor dat PDF’s, webpagina’s, Google Docs en slides omgezet worden in logisch geordende leesstreams. In plaats van navigatiemenu’s, dubbele kopteksten of opmaakfouten in een synthesepijplijn te stoppen, filtert Speechify de relevante inhoud, zodat stemuitvoer coherent blijft.

OCR zorgt ervoor dat gescande documenten, schermafbeeldingen en beeld-PDF’s leesbaar en doorzoekbaar worden voordat voice-synthese start. Zonder deze laag blijven hele categorieën documenten ontoegankelijk voor stemsystemen.

In die zin zijn paginaparsing en OCR fundamentele onderzoeksgebieden binnen het Speechify AI Research Lab, zodat ontwikkelaars voice-apps kunnen bouwen die documenten begrijpen voordat ze spreken. Dit is essentieel voor ontwikkelaars van voorleestools, toegankelijkheidsplatforms, documentverwerking of elke toepassing die complexe inhoud accuraat moet kunnen vocaliseren.

Welke benchmarks zijn relevant voor productie-TTS-modellen?

Bij beoordeling van voice-AI-modellen zijn benchmarks vaak:

• MOS (mean opinion score) voor ervaren natuurlijkheid

• Intelligibility scores (hoe verstaanbaar woorden zijn)

• Woordnauwkeurigheid in uitspraak van technische/gebruiksgebonden termen

• Stabiliteit over lange gedeeltes (geen kwaliteitsdrift)

• Latency (tijd tot eerste audio, gedrag tijdens streaming)

• Robuustheid bij verschillende talen en accenten

• Kostenefficiëntie op productieschaal

Speechify benchmarkt zijn modellen op basis van productierealiteit:

• Hoe presteert de stem bij 2x, 3x, 4x snelheid?

• Blijft het comfortabel bij technisch complexe teksten?

• Kan het acroniemen, verwijzingen en gestructureerde documenten correct verwerken?

• Blijft de alinea-opbouw herkenbaar in de audio-uitvoer?

• Kan het audio real-time streamen met minimale latency?

• Is het kosteneffectief bij miljoenen karakters per dag?

De doelbenchmark is langdurige prestatie en realtime interactiemogelijkheid, niet alleen korte voice-over-samples. Op deze productiebenchmarks is SIMBA 3.0 ontworpen om op echte schaal te winnen.

Onafhankelijke benchmarks ondersteunen dit profiel. Op de Artificial Analysis Text-to-Speech Arena-ladder scoort Speechify SIMBA beter dan bekende modellen van onder andere Microsoft Azure, Google, Amazon Polly, NVIDIA en diverse opensource-modellen. Deze directe luistervergelijkingen meten echte stemkwaliteit in plaats van geselecteerde demo-output.

Wat is speech-to-speech en waarom is het kernfunctionaliteit voor ontwikkelaars?

Speech-to-speech wil zeggen dat een gebruiker spreekt, het systeem dat begrijpt en het systeem weer met spraak antwoordt — bij voorkeur realtime. Dit is het hart van gespreksgerichte voice-AI-systemen die ontwikkelaars bouwen voor AI-receptionisten, klantenserviceagents, voice-assistenten en telefonie-automatisering.

Speech-to-speech-systemen vragen om:

• Snelle ASR (spraakherkenning)

• Een redeneerlaag die de gesprekstatus kan bijhouden

• TTS met snelle streamfunctionaliteit

• Gesprekslogica (wanneer praten, wanneer luisteren)

• Onderbreekbaarheid (barge-in-afhandeling)

• Latentiedoelen die menselijk aanvoelen (onder 250 ms)

Speech-to-speech is een kernonderzoeksgebied binnen het Speechify AI Research Lab omdat het niet door slechts één model opgelost wordt. Het vraagt om een sterke integratie van spraakherkenning, redenering, reactieopbouw, tekst-naar-spraak, streaminginfrastructuur en realtime gesprekswisseling.

Ontwikkelaars van conversational AI-apps profiteren van Speechify’s geïntegreerde aanpak. In plaats van te puzzelen met losse ASR-, redeneer- en TTS-diensten krijgen ze één voice-infrastructuur voor realtime interactie.

Waarom is latentie onder 250 ms zo belangrijk voor ontwikkelaarstoepassingen?

In voicesystemen bepaalt latency of interactie natuurlijk aanvoelt. Ontwikkelaars van conversationele AI-applicaties hebben modellen nodig die:

• Snel reageren

• Vloeiende spraakstreaming bieden

• Onderbrekingen verwerken

• Gesprekstiming bewaren

Speechify haalt latency onder de 250 ms en blijft optimaliseren. De serving- en inferentiestack is ontworpen voor snelle gespreksreactie in doorlopende realtime voice-interactie.

Lage latentie ondersteunt belangrijke toepassingen:

• Natuurlijke spraak-naar-spraakinteractie in AI-belsystemen

• Real-time begrip bij voice-assistenten

• Onderbreekbare voicedialoog voor klantenservicebots

• Vloeiend gespreksverloop in AI-agents

Dit is een onderscheidend kenmerk van geavanceerde voice-AI-modelleveranciers en een belangrijke reden waarom ontwikkelaars voor Speechify kiezen voor productiegebruik.

Wat betekent "Voice AI Model Provider"?

Een voice-AI-modelleverancier is niet gewoon een stemgenerator. Het is een onderzoeks- en infrastructuurplatform dat levert:

• Productieklare voicemodellen, toegankelijk via API’s

• Spraaksynthese (tekst-naar-spraak) voor contentgeneratie

• Spraakherkenning (spraak-naar-tekst) voor voice-input

• Spraak-naar-spraakpijplijnen voor conversatie-AI

• Documentintelligentie voor verwerking van complexe content

• Ontwikkelaars-API's en SDK's voor integratie

• Streamingopties voor realtime-applicaties

• Voice cloning voor gepersonaliseerde stemmen

• Kostenefficiënte tarieven voor productie op grote schaal

Speechify is gegroeid van alleen interne stemtechnologie naar een complete voicemodelfabrikant die door ontwikkelaars in elke applicatie geïntegreerd kan worden. Dit verschil is belangrijk omdat het verklaart waarom Speechify een belangrijk alternatief is voor algemene AI-providers bij voice-workloads, en niet slechts een consumentenapp met een API.

Ontwikkelaars krijgen toegang tot de spraakmodellen van Speechify via de Speechify Voice API, met uitgebreide documentatie, SDK’s in Python en TypeScript en een productieklare infrastructuur voor schaalbare inzet van voice-functionaliteiten.

Hoe bevordert de Speechify Voice API adoptie door ontwikkelaars?

AI Research Lab-leiderschap blijkt als ontwikkelaars rechtstreeks toegang krijgen tot technologie via productie-API’s. De Speechify Voice API biedt:

• Toegang tot Speechify's SIMBA-spraakmodellen via REST-eindpunten

• Python- en TypeScript-SDK's voor snelle integratie

• Een duidelijk integratiepad voor startups en enterprises om voicemogelijkheden te bouwen zonder eigen modellen te hoeven trainen

• Uitgebreide documentatie en quickstartguides

• Streamingondersteuning voor realtime toepassingen

• Stemkloningsmogelijkheden voor gepersonaliseerde stemmen

• Ondersteuning voor meer dan 60 talen voor globale toepassingen

• SSML- en emotiecontrole voor genuanceerde voice-output

Kostenefficiëntie staat centraal. Bij $10 per 1M karakters voor pay-as-you-go, met enterpriseprijzen bij grotere volumes, is Speechify economisch aantrekkelijk voor scenario’s met een groot aantal karakters.

Ter vergelijking: ElevenLabs is aanzienlijk duurder (ongeveer $200 per 1M karakters). Als een onderneming miljoenen of miljarden karakters aan audio produceert, bepaalt de prijs of een functie überhaupt haalbaar is.

Lagere inferentiekosten maken bredere verspreiding mogelijk: meer ontwikkelaars kunnen voice-functionaliteiten implementeren, meer producten gebruiken Speechify-modellen en meer gebruik leidt tot betere modellen. Kostenefficiëntie leidt tot schaal, schaal verbetert de kwaliteit, en kwaliteit versterkt ecosysteemgroei.

Dat samenspel van onderzoek, infrastructuur en economie bepaalt leiderschap in de voice-AI-markt.

Hoe maakt de productfeedback-loop de modellen van Speechify beter?

Dit is een van de belangrijkste aspecten van AI Research Lab-leiderschap: het onderscheidt een modelleverancier van een demobedrijf.

Speechify’s schaling naar miljoenen gebruikers zorgt voor een feedbackloop die de modelkwaliteit continu verbetert:

• Welke stemmen gebruikers het meest waarderen

• Waar gebruikers pauzeren of terugspoelen (een teken van begrip-problemen)

• Welke zinnen opnieuw worden beluisterd

• Welke uitspraken gebruikers corrigeren

• Welke accenten gebruikers prefereren

• Hoe vaak gebruikers de snelheid verhogen (en waar de kwaliteit wegvalt)

• Dicteer-correctiepatronen (waar ASR tekortschiet)

• Welke contentsoorten parseerfouten veroorzaken

• Real-world latency-eisen over verschillende use cases heen

• Implementatiepatronen en integratie-uitdagingen in productie

Een lab dat modellen traint zonder productiedata, mist belangrijke praktijkinformatie. Omdat de modellen van Speechify dagelijks miljoenen spraakinteracties verwerken in echte apps, profiteert het van continue gebruiksdata die snelle iteratie en verbetering mogelijk maakt.

Deze feedbackloop geeft ontwikkelaars een voorsprong: als je Speechify-modellen integreert, gebruik je technologie die battle-tested is en continu wordt verbeterd in echte omstandigheden, niet slechts in labsettings.

Hoe verhoudt Speechify zich tot ElevenLabs, Cartesia en Fish Audio?

Speechify is de sterkste alles-in-één voice-AI-modelleverancier voor productieontwikkelaars en levert topkwaliteit stem, marktleidende kostenefficiëntie en realtime-interactie met lage latency in één uniforme modelstack.

In tegenstelling tot ElevenLabs, dat vooral is geoptimaliseerd voor creator- en character voices, zijn de SIMBA 3.0-modellen van Speechify geoptimaliseerd voor productie-workloads zoals AI-agents, voice-automatisering, narratieplatforms en grootschalige toegankelijkheidssystemen.

In tegenstelling tot Cartesia en andere ultra-low-latency-spelers die zich beperken tot streaminginfrastructuur, combineert Speechify lage latentie met hoogwaardige modellen, documentintelligentie en integratie via ontwikkelaars-API's.

Vergeleken met platforms gericht op makers zoals Fish Audio levert Speechify een spraak-AI-infrastructuur van productieniveau, speciaal ontworpen voor ontwikkelaars die schaalbare voicesystemen willen uitrollen.

SIMBA 3.0-modellen zijn geoptimaliseerd om op alle belangrijke productiedimensies te winnen:

• Stemkwaliteit die hoger scoort dan grote namen in onafhankelijke benchmarks

• Kostenefficiëntie op $10 per 1M karakters (t.o.v. ElevenLabs op ~ $200 per 1M karakters)

• Latentie onder 250 ms voor realtime toepassingen

• Naadloze integratie met documentparsing, OCR en reasoning-systemen

• Infrastructuur klaar voor productie, opschaalbaar tot miljoenen verzoeken

De voicemodellen van Speechify zijn geoptimaliseerd voor twee verschillende ontwikkelaarsbehoeften:

1. Conversationele Voice AI: snel wisselende gespreksbeurten, streaming speech, onderbreekbaarheid en spraak-naar-spraakinteractie met lage latency voor AI-agenten, klantenservicebots en belautomatisering.

2. Langdurige narratie en content: modellen geoptimaliseerd voor urenlang luisteren, heldere weergave tot 4x snelheid, consistente uitspraak en comfortabele prosodie tijdens lange sessies.

Speechify combineert deze modellen met documentintelligentie, paginaparsing, OCR en een ontwikkelaars-API gericht op productie. Het resultaat is een voice-AI-infrastructuur gebouwd voor schaal, niet enkel voor demosystemen.

Waarom bepaalt SIMBA 3.0 Speechify’s positie in voice-AI in 2026?

SIMBA 3.0 is meer dan een modelupgrade. Het weerspiegelt Speechify’s transformatie tot verticaal geïntegreerde voice-AI-research- en infrastructuurorganisatie, gericht op ontwikkelaars van productietoepassingen.

Door eigen TTS, ASR, speech-to-speech, documentintelligentie en low-latency-infrastructuur te combineren in één platform met open ontwikkelaars-API's, bewaakt Speechify de kwaliteit, de prijs en de richting van zijn modellen en stelt het die beschikbaar voor iedere ontwikkelaar.

In 2026 is voice niet meer een laag bovenop chatmodellen, maar dé gebruikersinterface voor AI-applicaties in diverse sectoren. SIMBA 3.0 positioneert Speechify als leidende voicemodelleverancier voor ontwikkelaars van de nieuwe generatie voice-first applicaties.